Amazon Web Services(AWS)では、顧客から寄せられるさまざまな要望にあわせ、サービスを用意してきた。「Amazon Elastic MapReduce(EMR)」もその一つである。分散並列処理フレームワーク「Apache Hadoop」を仮想マシンの「Amazon Elastic Compute Cloud(EC2)」やストレージサービスの「Amazon Simple Storage Service(S3)」上で稼働させる。

EMRは、Hadoopをオンデマンドで実行可能なため、利用料金は使った分だけ支払えばよい。「コストを抑えたい」というニーズに対応したサービスだ。ユニークなコストの抑え方として“スポットインスタンス”の活用がある。

スポットインスタンスは、空いているAWSのサーバを入札形式で指し値で利用するものだ。サーバの数を増やすことで処理にかかる時間を短縮することができる。

また、通常のサーバ増強に比べて低コストで済む。通常の3分の1のコストで、作業時間が大幅に短縮した例もあるという。Hadoopを運用するために必要なエンジニアをアテンドする必要がないので、人的コストや稼働までの時間も短縮することができる。

玉川憲氏

玉川憲氏

こうした特徴に加えて、「ビッグデータによる解析のトライ&エラーを気軽に試すことができるというのも大きな特徴」とアマゾン データ サービス ジャパンのソリューションアーキテクチャ本部技術統括部長でエバンジェリストも務める玉川憲氏が説明する。

データ解析するためには、データを収集、保存し、それを解析した結果を踏まえデータが十分なのか、何か足すべきデータがあるのかを判断する作業が不可欠だ。

「この作業を本気でやろうとすれば、そのためのサーバ調達、チューニングといった作業とそのための初期投資費用がかかる。しかし、EMRを利用すれば大幅に費用は安くなり、稼働までの期間も短くなる」

実際に解析作業を行ってみると、必要なデータが収集されていないことに気がつく場合も多いという。ビッグデータに発展するようなデータを集めていない企業も多く、「まずログを貯めることからとアドバイスする場合も多い」そうだ。通常、自前でサーバとシステムを用意するのであれば難しいトライ&エラーだが、それを試すことができるのがAWSの大きな強みとなっている。

EMRは、AWSの他のサービスと連動することでS3との連携、JavaやRubyなどのSDKを利用することが可能となる。「毎回手作業でやるには時間がかかりすぎる作業をテンプレート、スクリプトなどを活用することで手間や時間を軽減することもできる」

できるだけ省力化したビッグデータ活用が可能になる環境が整っている。EMRの活用例としては、ソーシャルデータの分析、ソーシャルグラフの構築、ユーザーの嗜好性解析、リコメンデーションエンジン、データマイニング、大量ファイルの解析などがあげられる。

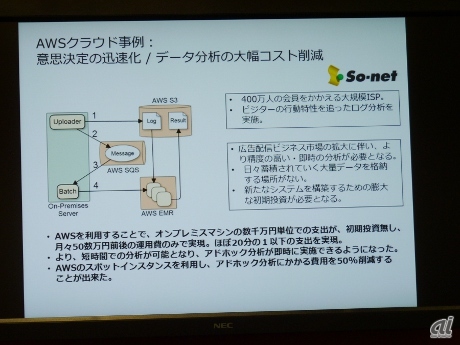

So-netでの活用事例

So-netでの活用事例

※クリックすると拡大画像が見られます

400万人の会員を抱えるSo-netは、ビジターの行動特性を追ったログを解析。オンプレミスなら数千万円の購入費用がかかるところ、AWS利用で初期投資ゼロ、月額五十数万円と大幅にコストを抑えることに成功。スポットインスタンスを利用することで、アドホック分析にかかる費用も50%削減した。

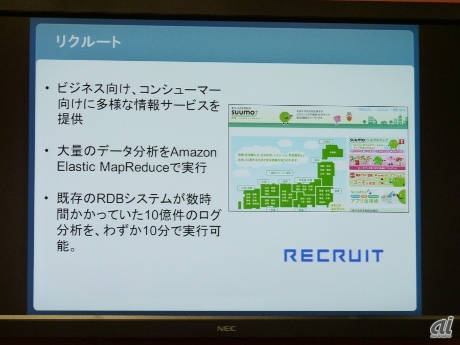

リクルートでは不動産ポータルサイト「SUMO」での大量データ分析にEMRを活用。既存のRDBシステムで数時間かかっていた10億件のログ分析を10分で実行可能にした。

SUMOでの活用事例

SUMOでの活用事例

※クリックすると拡大画像が見られます

こうした事例は東京にデータセンターが開設された直後から存在しているが、最近はビッグデータでのAWS活用は第2フェーズといえる段階に入ったという。「できるだけ低料金で、試行錯誤しながら使って貰えるものへこちら側もさらに内容の充実を図りたい」(玉川氏)とサービス内容拡充にも意欲的だ。