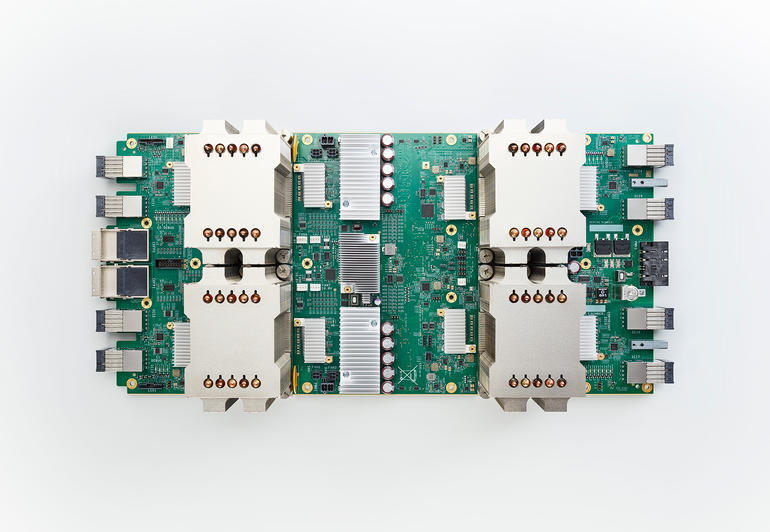

Googleは米国時間5月17日、開発者カンファレンス「Google I/O」で、次世代の機械学習向けカスタムチップ「Tensor Processing Unit」(TPU)を発表した。2016年のGoogle I/Oで発表された第1世代のTPUは、トレーニング済みの機械学習モデルを実行するよう設計されていた。今回の新しいチップは、最大180テラフロップスという驚異的な演算能力で、機械学習モデルのトレーニングと実行の両方を行う。

第2世代のTPUとなる「Cloud TPU」は、「Google Cloud Platform」(GCP)を通じて誰でも利用できるようになる。GCPを使う開発者は、Intelの「Skylake」やNVIDIAのGPU「Volta」のような従来型の構成でも引き続き設計できる。

Cloud TPUは、競合するパブリッククラウド企業と一線を画するために、Googleが最先端技術を駆使する最新例だ。

Googleの最高経営責任者(CEO)Sundar Pichai氏はGoogle I/Oの基調講演で、「Google Cloudを、機械学習向けの最高のクラウドにしたい。それが重要な前進の足場を固める」と語った。

Googleは演算能力をさらに高めるため、超高速ネットワークが組み込まれたTPUを64個接続して機械学習用のスーパーコンピュータにする「TPU pod」を構築した。TPU podは、最大11.5ペタフロップス(1万1500テラフロップス)の演算処理能力で、単一の大規模な機械学習モデルと複数の小規模な機械学習モデルの両方のトレーニングに対応する。

Googleは、TPU podの能力の説明として、同社の新しい大規模な言語翻訳モデルのトレーニングは、世界最高の市販GPUだと32個使っても丸一日かかるが、TPU podなら8分の1の規模で6時間しかかからないと述べた。

個々のCloud TPUもTPU pod全体も、「TensorFlow」を使うことで可能になる高度な抽象化を利用してプログラミングするよう設計された。TensorFlowは、Googleが開発したオープンソースの機械学習システムだ。

第1世代のTPUは、2年前にGoogleの社内で導入され、現在、検索や「Google翻訳」の新しいニューラル機械翻訳システム、音声認識、「Googleフォト」といった同社の製品に利用されている。

GoogleのシニアフェローであるJeff Dean氏は今週、Googleはまだ、一部の機械学習モデルのトレーニングにCPUとGPUを使用していると記者に話した。ただ、TPUの利用が徐々に増えていくと同氏は見ている。

さらにGoogleは、「TensorFlow Research Cloud(TFRC)」を発表した。TFRCでは、1000個のCloud TPUによるクラスタを一定の条件下で研究者に無料で提供する。利用する研究者は、研究結果の公開をいとわないことが条件で、場合によっては、研究に関連するコードをオープンソース化する必要がある。GoogleはTFRCの提供によって機械学習研究を加速させることを目指している。

プロプライエタリな研究向けには、「Cloud TPU Alpha」というプログラムを立ち上げる計画だという。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。