MicrosoftのハードウェアマイクロサービスはIntelのFPGA上に構築されている(Intelは2015年にFPGAメーカーのAlteraを買収している)。これらのチップとMicrosoftのフレームワークを組み合わせることで、速度や効率、レイテンシの向上がもたらされるため、ビッグデータのワークロードに特に適したものとなる。

提供:Microsoft

またMicrosoftは、「BrainWave」という開発コード名のプロジェクトでDNNに注力している。同社は「Microsoft Ignite 2016」カンファレンスでBrainWaveを公式に披露し、FPGAを用いたシステム上で大量の翻訳処理を実行してみせた。

同社はワシントン州レドモンドでの、AIに特化したイベント「Microsoft Research Faculty Summit」でBrainWaveについて説明する予定だったが、更新されたアジェンダを見る限り、BrainWaveに関する言及はなくなったようだ。

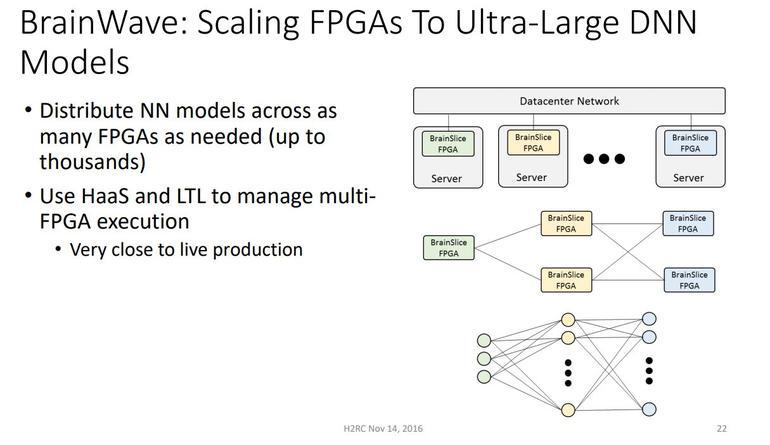

同社が2016年に実施した、構成可能なクラウドの計画に関するプレゼンテーションよると、BrainWaveはFPGAベースのハードウェアマイクロサービス上で稼働するディープラーニングプラットフォームだという。このプレゼンテーションでは、データセンターやインターネットをまたがる「サービスとしてのハードウェアアクセラレーション」に言及している。BrainWaveは、必要に応じて複数のFPGAにニューラルネットワークモデルを分散させるようになっている。

クラウドデータセンターでのFPGA利用に目を向けている企業はMicrosoftのみではない。AmazonとGoogleはいずれも、AI関連のタスクにカスタムチップを採用している。

Amazonは既に「Amazon Elastic Compute Cloud」(Amazon EC2)上で、XilinxのFPGAを利用できる「F1」インスタンスの提供を開始しており、FPGA向けのハードウェア開発キットも提供している。一方、Googleは同社の機械学習ライブラリ「TensorFlow」でディープラーニングモデルの訓練に関する取り組みを続けてきており、TensorFlow向けにカスタマイズした「Tensor Processing Unit」(TPU)というチップも開発済みだ。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。