本連載「松岡功の『今週の明言』」では毎週、ICT業界のキーパーソンたちが記者会見やイベントなどで明言した言葉をいくつか取り上げ、その意味や背景などを解説している。

今回は、富士通研究所の佐々木繁 代表取締役社長と、米Google CloudのPrabhakar Raghavan バイスプレジデントの発言を紹介する。

「企業が使うAIは“説明可能なAI”でなければならない」

(富士通研究所 佐々木繁 代表取締役社長)

富士通研究所の佐々木繁 代表取締役社長

富士通研究所が先頃、研究開発戦略および最新技術について記者・アナリスト向けの説明会を開いた。同社の社長で富士通の最高技術責任者(CTO)を兼務する佐々木氏の冒頭の発言は、その説明会で、「説明可能なAI(人工知能)」の必要性を説き、「それを実現したのは私たちだけだと自負している」と強調した。

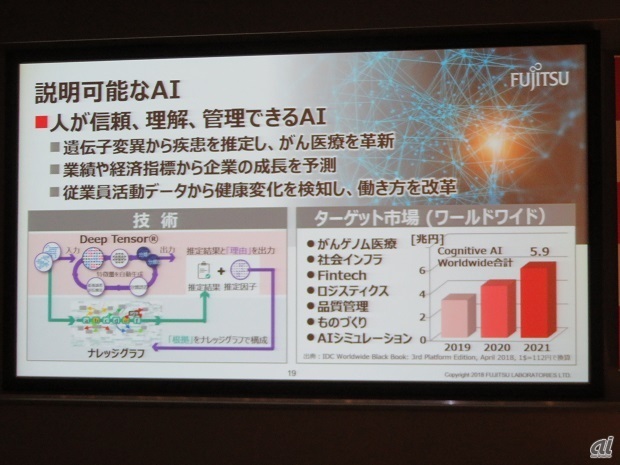

同社が開発した説明可能なAIは、「Deep Tensor/Knowledge Graph」(ディープテンソル/ナレッジグラフ)と呼ぶ。人やモノのつながりを表現する「グラフ構造」のデータを高精度に解析できる機械学習技術であるDeep Tensorと、学術文献など専門的な知識を蓄積したKnowledge Graphと呼ばれるグラフ構造の知識ベースを関連付けることにより、大量のデータを学習させたAIの推定結果から推定理由や学術的な根拠を提示するという。

この技術開発の背景としては、ディープラーニングなどの機械学習技術の活用が広がる一方で、これらの技術は推定結果が得られた理由を人間が検証することが困難なため、AIを使った専門家の判断に関して説明責任が問われる医療や金融などのミッションクリティカルな領域などへの適用に課題があったとしている。すなわち、これまではAIがブラックボックスだったのである。

それに対し、Deep Tensor/Knowledge Graphでは、AIの推定結果に対する理由や根拠として得られた学術文献などの専門的な知識をもとに、専門家によってAIの推定結果が信頼に値するかを確認できるとともに、得られた結果を手がかりに新しい知見を得ることができるようになるなど、専門家がAIと協調して問題解決する世界が実現するとしている。

佐々木氏はこうした説明可能なAIを「人が信頼、理解、管理できるAI」と説明した。既に、遺伝子変異から疾患を推定し、がん医療を革新したり、業績や経済指標から企業の成長を予測したりするなどのアプローチを始めているという(図参照)。

図:説明可能なAIの内容

説明会の質疑応答で、「AI技術の中で、競合と比べて富士通が世界でトップだという領域があれば、お聞かせいただきたい」と質問したところ、同氏は説明可能なAIを挙げ、次にように答えた。

「AIは大量のデータを学習させれば良い答えが出るだろうが、その答えに至った理由を説明できないと、企業としては問題があるのではないか。企業が使うAIは、説明可能なAIでなければならない」

冒頭の発言はこのコメントから抜粋したものである。AIのブラックボックスを打開する技術として、果たして広く受け入れられるか、注目しておきたい。