NVIDIAは米国時間8月13日、自然言語理解に向けた同社の人工知能(AI)テクノロジーの進歩について発表するとともに、対話型AIの訓練で新たな世界記録を打ち立てたと述べた。NVIDIAは、同社のAIプラットフォームが最速の訓練記録を樹立するとともに、最速の推論と過去最大の訓練モデルを実現したと述べた。

NVIDIAは同社のAIプラットフォームとGPUに決定的な最適化を施すことで、対話型AIサービスの卓越したプロバイダーになろうとしている。同社によると、対話型AIサービスはこれまで、大規模なAIモデルをリアルタイムで配備する際に発生するさまざまな能力上の問題により、限定的なものとなっていたという。

NVIDIAの応用ディープラーニング(DL)研究のバイスプレジデントを務めるBryan Catanzaro氏は報道陣向けの発表の場で、対話型AIは極めて単純なトラクザクション型AIとは異なり、コンテキストやニュアンスを読み取って、すぐさま応答を返すと説明した。このため、対話型AIのモデル自体は、人間レベルの理解力を実現するうえではるかに大規模かつリアルタイムで動作する必要がある。

NVIDIAは性能面でのブレークスルーについて、Googleによって生み出された言語モデル「BERT」(Bidirectional Encoder Representations from Transformers:Transformerによる双方向のエンコーダー表現)の訓練で世界記録を樹立したと述べた。NVIDIAは、ディープラーニングモデルを超高速で実行できる「NVIDIA DGX SuperPOD」を使用するとともに、大規模なモデルを取り扱うために単一GPUのメモリー内に収まるようニューラルネットワークを分割する「モデル並列性」という手法を活用することで、大規模なBERT-Largeモデルを53分で訓練したという。

Catanzaro氏は、「この種のテクノロジーがなければ、大規模な言語モデル1つを訓練するのに何週間もかかるはずだ」と述べた。

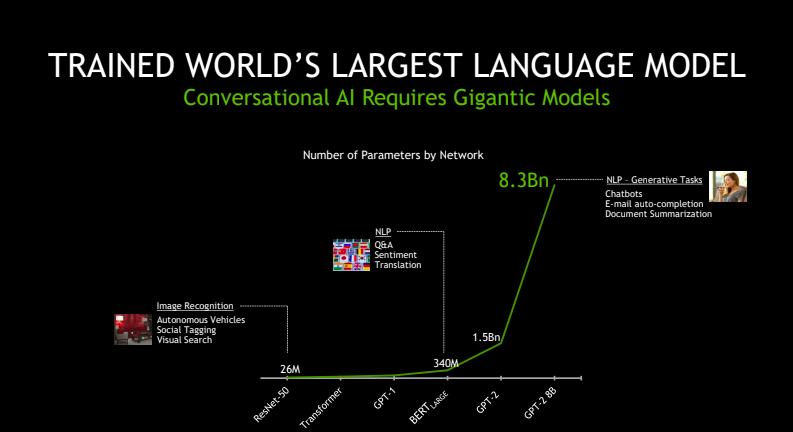

NVIDIAによると、BERTの推論は最速で2.2ミリ秒であり、訓練した最大のモデルのパラメーター数は83億だったという。

同氏は、「大規模な言語モデルは自然言語のためのAIに大きな変革をもたらしている」とし、「大規模言語モデルは、格段に難しい言語問題の解決に向けた力となり、これによって本当の意味での対話型AIという目標に近づけるようになる」と述べた。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。