大日本印刷(DNP)は8月24日、NHKテクノロジーズ(NT)と共同で、映像と音声を人工知能(AI)で解析し、内容や感情に合ったフォントで字幕を表示する「感情表現字幕システム」のプロトタイプを開発したと発表した。同システムには、2018年にDNPが開発した文章の内容に合うフォントを自動で判別・表示する「DNP感情表現フォントシステム」が活用されている。これにより、耳の不自由な人や音が出せない環境においても、番組の臨場感を伝えることができるという。

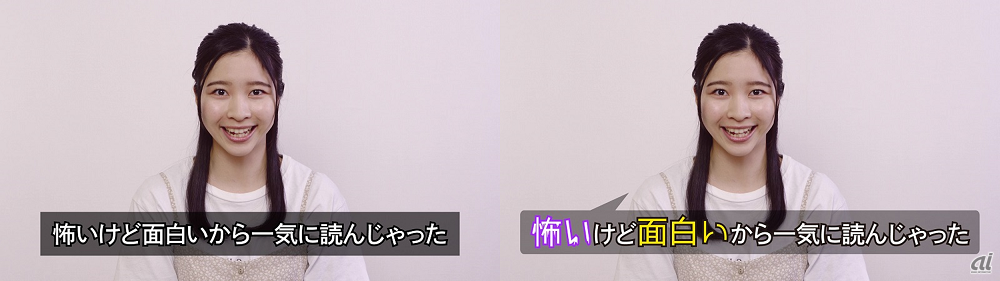

一般的な字幕(左)/音声解析し、言葉に合わせて自動生成した字幕(右)(出典:DNP)

顔の表情を解析し、感情に適したフォントを自動表示する。左が「不安」の感情、右が「楽しい」という感情(出典:DNP)

近年、多くの人に分かりやすく情報を伝える「ユニバーサルメディア」へのニーズが高まっており、テレビ業界も聴覚に障がいのある人や高齢者などに向けて、より多くの番組への字幕付与が求められている。NTが2018年度に実施した、聴覚に障がいのある人々とのディスカッションでは「従来の字幕放送はフォントに抑揚がない」「タイミングがずれることがある」「発話者が分かりにくい」といった課題が挙がった一方で、映像効果としてテロップに使われるユニークなフォントによってセリフの印象が深くなるという意見があったという。また、制作側では番組に字幕を入れる作業が大きな負荷になっており、自動的に精度の高い字幕を付与できる技術が求められていた。こうしたニーズを受けて、両社は感情表現字幕システムの共同開発に至ったとしている。

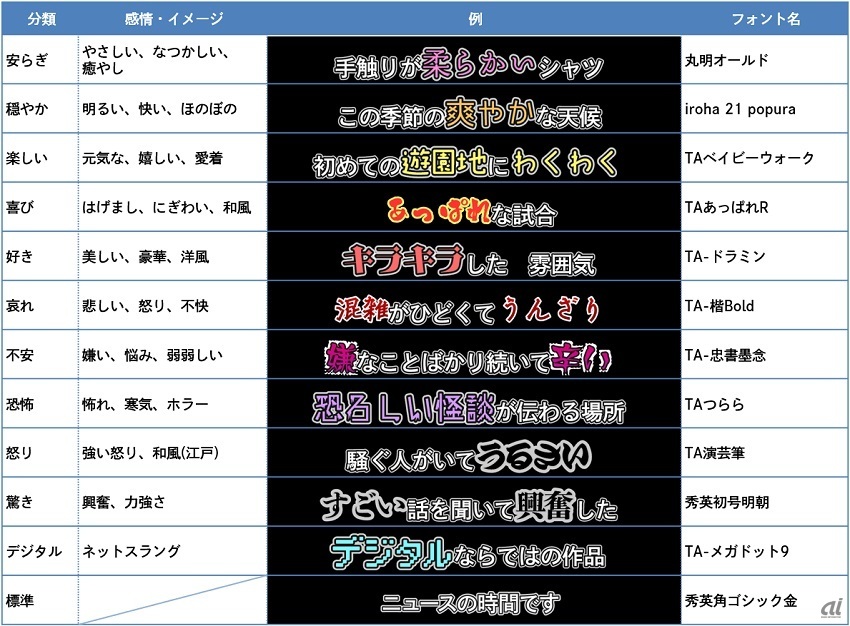

同システムでは、事前収録や生放送の映像における音声を解析し、リアルタイムで字幕を自動的に付与する。その際、字幕の内容や発話者の表情を解析して感情を把握し、その感情の表現に最適なフォントを12種類の中から自動で選んで字幕に使う。例えば、楽しい内容は丸みのあるフォント、怒っている内容は角ばったフォントで表示することで、より直感的に内容を伝えることができる。

また映像内の発話者を特定し、自動的にその口元の近くに字幕を表示する。これにより、複数の人物が登場する映像でも、誰が何を話しているのかが分かりやすくなる。

12種類の感情・イメージと使用フォントの組み合わせ例。感情の分類やフォントは手動で変更可能(出典:DNP)

DNPとNTは、感情表現字幕システムの開発を続け、オープンキャプション(常に表示される字幕)での実用化を目指している。また、音声/感情認識のAIの精度を向上させるとともに、リアルタイム性を高めることで、生放送やインターネット同時配信サービスのクローズドキャプション(視聴者が表示/非表示を切り替えられる字幕)にも展開していく。DNPは、同システムをデジタルサイネージなどの動画の字幕に応用するほか、映像編集用ソフトウェアとして提供することも計画している。