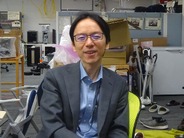

同機能はOracleやMySQLのデータストリームを「BigQuery」や「Cloud SQL for PostgreSQL」、「Google Cloud Storage」などGCPのサービスにリアルタイムで取り込める。「オンプレミスのOracleやMySQLの負荷が高まった際の、リードトラフィックだけを伸ばすためのDBとして利用」(寳野氏)することも可能だ。

Datastreamの概要

Datastreamの概要

※クリックすると拡大画像が見られます

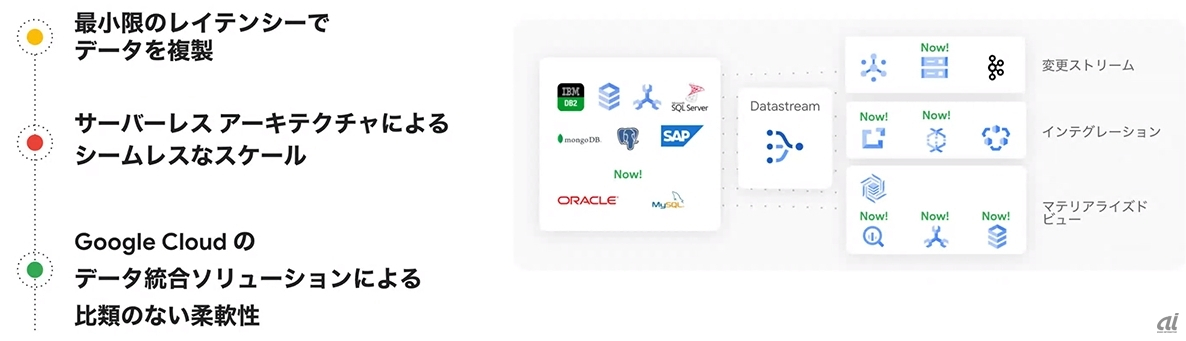

分散したデータに対する加工や処理は、データのトラッキングや信頼性低下につながってしまう。グーグルは自身の経験として「1カ月前に抽出したマーケティング用ターゲットユーザーを他の部署に提出しても、データの鮮度からマーケティング施策が正しいか分からなくなってしまう」(寳野氏)ケースを目にしたという。

同社は組織内外を超えたデータ共有の容易性を重視した結果として、Analytics Hubが生まれたと説明する。Analytics Hubは文字通り、機械学習モデルなどのデータや分析手法を組織内外で共有するためのハブだ。

「組織を超えたデータ共有(データ販売)時の課題は、データの活用方法やデータ精度の不明確さだが、LookerやBIツール(のテンプレート)を共有することで分析方法の共有が可能」(寳野氏)

Analytics Hubの概要

Analytics Hubの概要

※クリックすると拡大画像が見られます

GCPで重視する4項目

グーグルはGCPの運用について、「オープン」「インテリジェンス」「信頼性」「プラネットスケール」の4項目を重視しているという。

オープンについては「たとえば顧客が使いたい技術がOSS(オープンソースソフトウェア)であれば、GCPでも別の場所でも使っていただける。GCP独自技術でも別の場所で実行できるポータビリティを重視している」(寳野氏)

インテリジェンスについても寳野氏は「企業がインサイトデータから価値を得るには機械学習を素早く活用できるサービス、データ格納先から機械学習モデルを作成できるインテリジェンスが欠かせない。そして重要なのはインフラストラクチャーを気にせず実行できること」と説明した。

信頼性については「データの信頼性は重要な課題。機械学習時に誤ったデータを用いると誤った結果しか生まれない。データ分析も同様だ。データアクセスの可視化や必要な場面では容易なアクセスを可能にする仕組みを重視している」(寳野氏)

そして最後のプラネットスケールについて寳野氏は「過去の経営会議で必要とされてきたのは先月のデータだったが、現在はその場でデータを見てアクションにつなげるような議論の場に変化している。するとリアルタイムにドリルダウンして明細まで確認できるようなデータや処理能力が必要。われわれはスケールし続けられる技術を重要視している」と語った。