Amazon Web Services(AWS)は、12月1~3日に年次イベント「re:Invent 2021」を開催。連日の基調講演の中で、ユーティリティーコンピューティング担当シニアバイスプレジデントのPeter DeSantis氏が、独自開発する「Graviton」プロセッサーやストレージサービス、機械学習技術への取り組みを語った。

AWS ユーティリティーコンピューティング担当シニアバイスプレジデントのPeter DeSantis氏

AWSにとって2021年は、2006年の「Amazon Simple Storage Service」(S3)ストレージサービスの提供開始から15周年の節目となる。コンピュートサービスの「Amazon Elastic Compute Cloud」(EC2)もS3から約半年後に開始され、いずれのAWSの礎に当たるサービスである。DeSantis氏は、「南アフリカのケープタウンのオフィスで、EC2サービスをローンチした。最初はグリッドコンピューティングのサービスであり、各種インスタンスサービスやアベイラビリティーゾーン(AZ)などを生み、セキュリティやコスト、可用性、安定性、伸縮性といった高まる要件に対応し続けてきた」を切り出した。

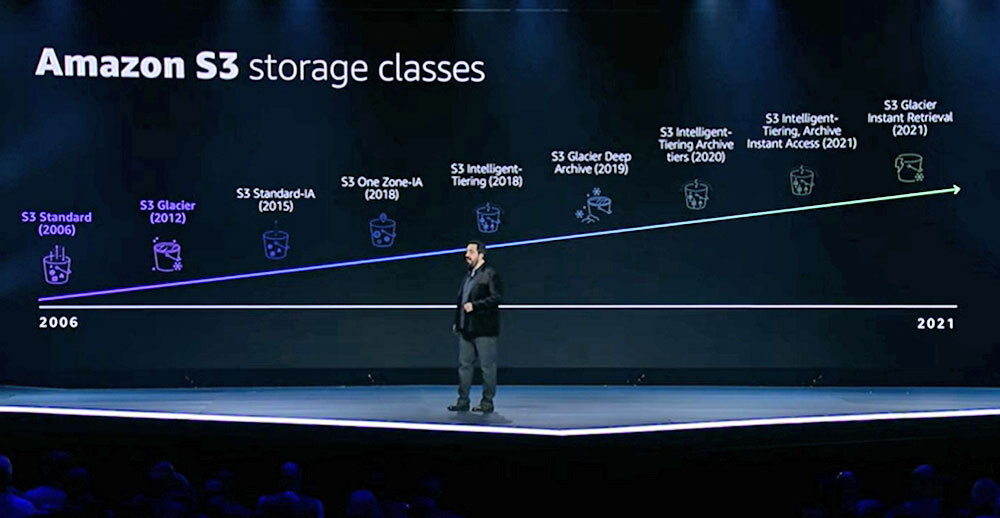

そして、「初のブロックストレージサービスとなったS3では、画像やバックアップといったさまざまな種類のデータ、そして、データの大規模化に対応し続け、現在ではデータレイクとしても活用されると同時に、やはりスピードやコスト、アクセス性といった高まる要件にも対応してストレージクラスを拡充してきた」と続けた。

「S3」のストレージクラスの歴史

ことストレージに関しては、量や種類が増え続ける一方のデータへの対応、容量単価の低減、データへの高速アクセスをどう担保させるかが課題になる。容量とコストにHDDに優れるが、プラッターやモーター、磁気ヘッドといった機械構造が高速アクセスのボトルネックになる。

S3サービスに使われる無数のHDDリソースを有効利用する上、DeSantis氏はデータを最適に配置するための推論技術に長年取り組んできたと述べる。その成果もあり、現在は大規模なコンピューターグラフィックスデータを用いる設計開発などでのモデリング、シミュレーション解析にも対応可能なサービスになった。

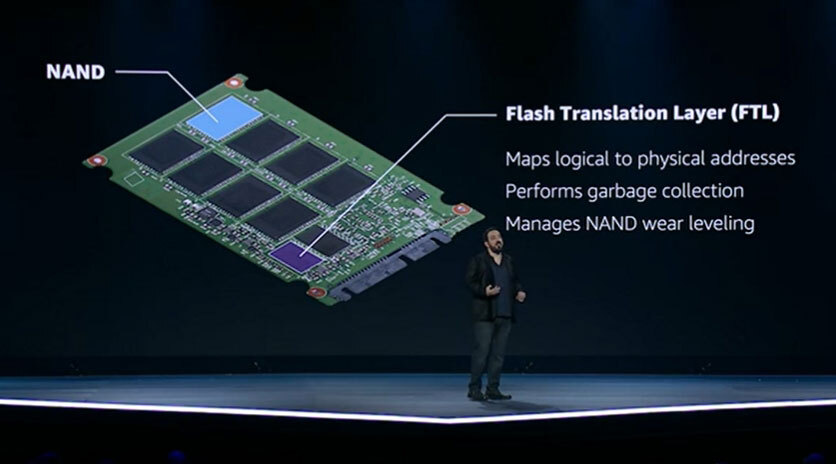

ストレージにおける次の大きな変化がSSDの登場と普及だ。DeSantis氏は、「Amazon Elastic Block Store」(Amazon EBS)でのSSD採用の取り組みも振り返った。SSDに搭載されるフラッシュメディアは、HDDのような機械構造を伴わず優れたアクセスを実現する。ただし、高速性と安定性を両立させたセルへのデータの書き込みは技術的な挑戦であり、「Flash Translation Layer」(FTL)がその鍵を握ると述べる。

SSDにおけるデータの高速性と安定性では「Flash Translation Layer」(FTL)が鍵になるという

DeSantis氏によれば、FTLの性能はSSDメーカーごとに異なるロジックに左右される。サービスプロバイダーの立場で異なるメーカーのSSDを調達し、顧客にストレージサービスを提供する上で、多種多様なワークロードに対応するにはここがボトルネックとなった。

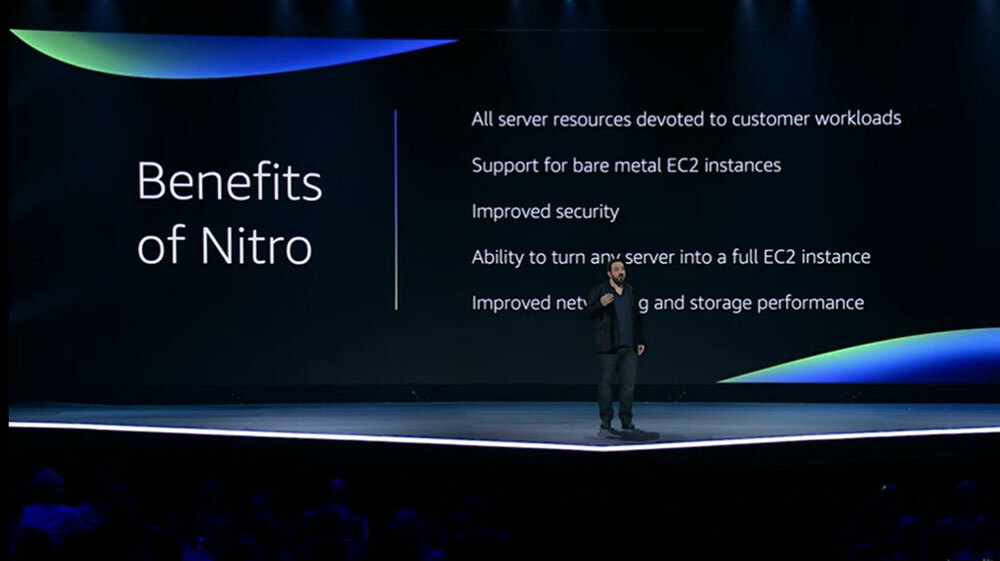

こうしたハードウェアの差異は、さまざまなワークロードに対応するインスタンスサービスやストレージサービスを提供する上での課題になる。そこで、2015年に買収したAnnapurna LabsのASIC技術をベースに「AWS Nitro System」を独自開発した。

Nitro Systemを介することでハードウェアを抽象化でき、通信やストレージアクセス、暗号化処理などをNitro Systemにオフロードさせることによって、IntelやMac、Armなど各種プロセッサーやストレージデバイスの特性を生かしつつ、時により高い処理性能を持つ多様なインスタンスサービスの提供が可能になった。Amazon EBSの場合、Nitro Systemを用いた大容量データへの高速アクセスを行う「io2 Block Express」において25万6000のIOPSを実現し、PostgreSQLの処理能力が従前(io1)に比べ2.43倍に向上したという。

「Nitro System」の実現がAWSのサービスに大きな影響を与えた

Annapurna Labsの技術を用いたもう1つの独自開発が、Armベースのプロセッサー「Graviton」シリーズになる。re:Invent 2021では、第3世代の「Graviton3」と、これを採用した新インスタンスの「C7g」「Trn1」が発表された。

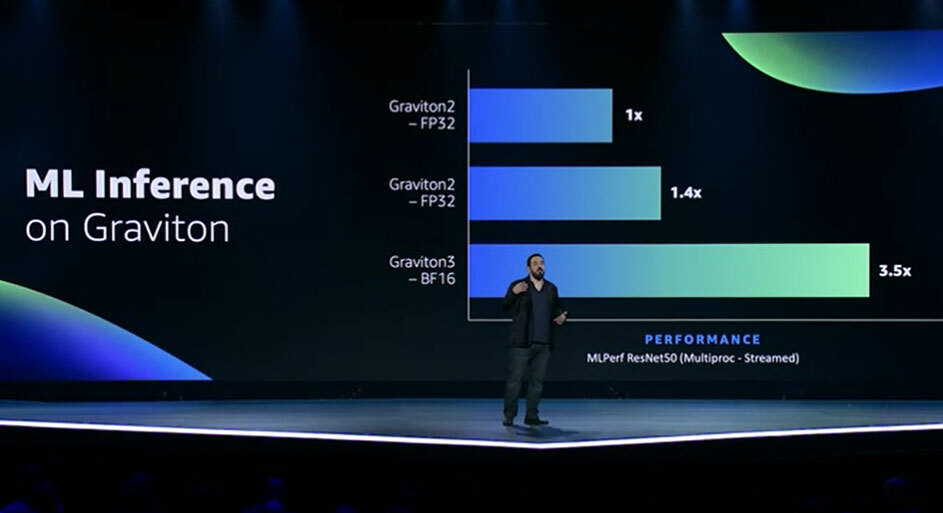

Graviton3は、前世代のGraviton2に比べ演算処理で最大25%、浮動小数点演算と暗号化処理では最大2倍に性能が向上した。ニューラルネットワーク向けの浮動小数点形式の「bfloat16」のデータをサポートするため、同分野での処理能力は3.5倍に向上しているとする。

最新プロセッサーのGraviton3は、特に機械学習の推論処理で性能が大幅に向上した

DeSantis氏は、プロセッサーの高性能化とその性能を最大限に引き出すようなワークロードでは電力消費が増えてしまうが、Graviton3ではメニーコア化(約500億のトランジスター)やDDR5によるメモリー帯域幅の拡大によって、そうした懸念に対処したと話す。

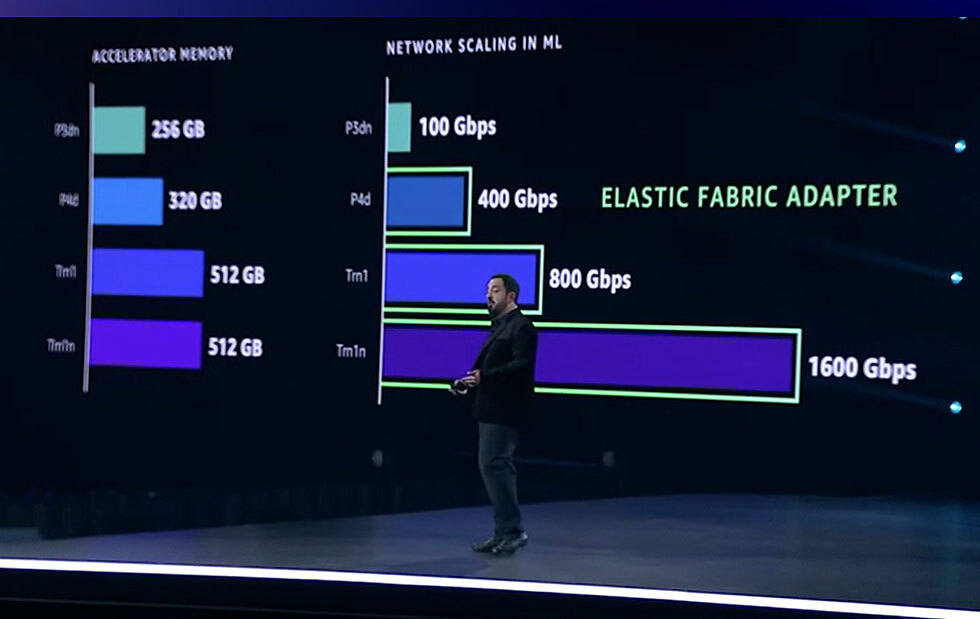

機械学習向けインスタンスにおけるメモリーやネットワークの違い。最新の「Trn1」よりネットワークが高性能とする公式発表にはない「Trn1n」というインスタンスも示されている

機械学習などは、インスタンスサービスで利用するホットなワークロードの1つになっているが、学習する教師データの増大や開発モデルの複雑化により、処理をいかに効率化するかが重要になる。DeSantis氏は、分散処理や最新のハードウェアを生かしたインスタンスの組み合わせが鍵だとした。

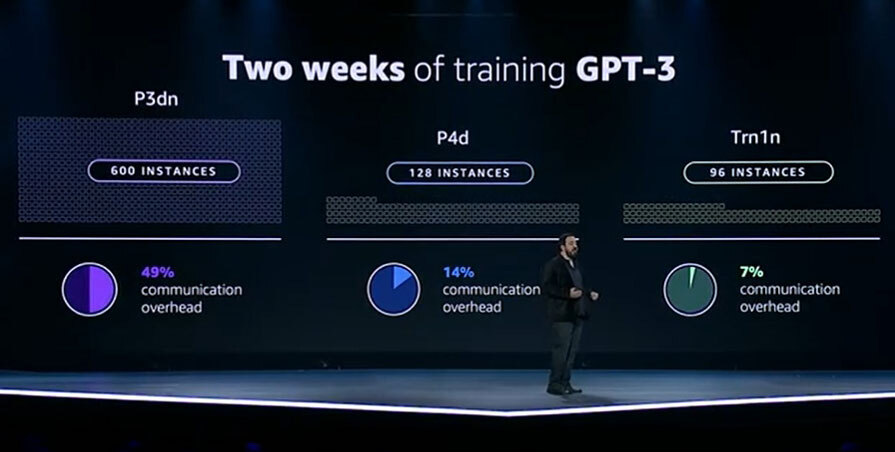

DeSantis氏によれば、例えば自然言語処理のBERT-LargeとGPT-3では、パラメーター数がBERT-Largeで約3400万、GPT-3では1750億と大きく異なる。同氏が示したところでは、BERT-Largeを1時間実行した場合、EC2のP3dnインスタンスのオーバーヘッドは13%だが、より新しいP4dインスタンスでは9%程度になる。GPT-3を2週間実行した場合は、P3dnインスタンスで49%にもなるが、P4dでは14%、最新のTrn1では7%という。

GPT-3を2週間実行した場合の比較