米NVIDAは4月25日、米OpenAIの「ChatGPT」をはじめとする大規模言語モデル(LLM)を利用するAIチャットボットなどの正確性、適切性、整合性、安全性を確保するオープンソースソフトウェア「NeMo Guardrails」を発表した。

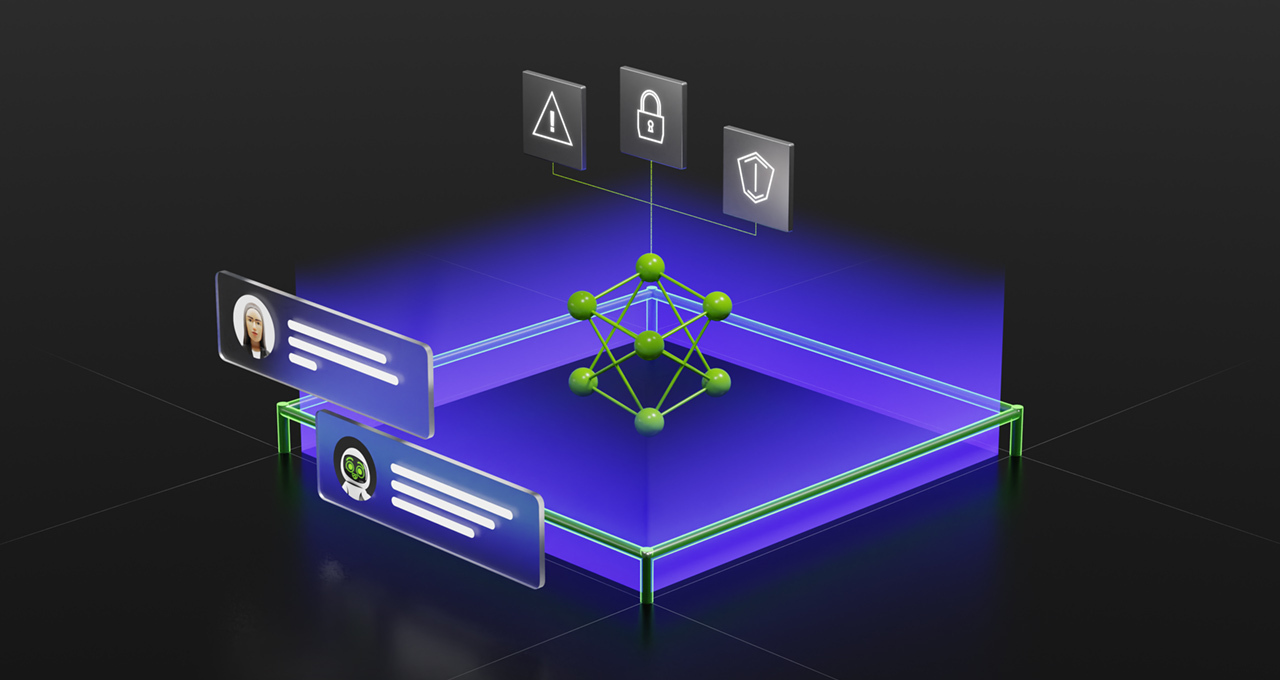

ジェネレーティブAI(生成系AI)の活用が進む中、その安全性の確保が業界全体の懸念事項となっている。NeMo Guardrailsは、企業の安全基準やセキュリティ要件に沿った形でAIチャットボットが応答できるように、「話題」「安全性」「セキュリティ」という3つの境界(ガードレール)を設定できる。

話題のガードレールは、アプリが望ましくない領域の話題に逸脱するのを防ぐ。安全性のガードレールは、アプリが正確で適切な情報で応答するのを保証し、不要な言葉をフィルタリングしたり、信頼できる情報源のみを参照したりできる。セキュリティのガードレールは、安全性が確認されている外部のサードパーティーアプリケーションとのみ接続するよう制限をかけられる。数行のコードを追加するだけで迅速に新しいルールを作成可能という。

オープンソースのツールキット「LangChain」や自動化ツール「Zapier」など、さまざまなツールとの連携も可能となっている。

NeMo Guardrailsは、企業独自のデータを使って生成系AIモデルの構築、カスタマイズ、展開を可能にする「NVIDIA NeMo フレームワーク」に組み込まれている。NeMoはサービスとしても提供されており、独自のデータセットやドメイン知識に基づいてカスタムの生成系AIモデルを作成・実行したい企業向けのクラウドサービスとなっている。

「ガードレール」のイメージ