NVIDIAの最高経営責任者(CEO)Jensen Huang氏は現地時間5月29日、台湾の台北で行った「COMPUTEX」(台北国際コンピューター見本市)の基調講演で、人工知能(AI)タスクにおける大量のデータ移動に特化した新しい種類のイーサネットプラットフォームを含む多くの製品を発表した。

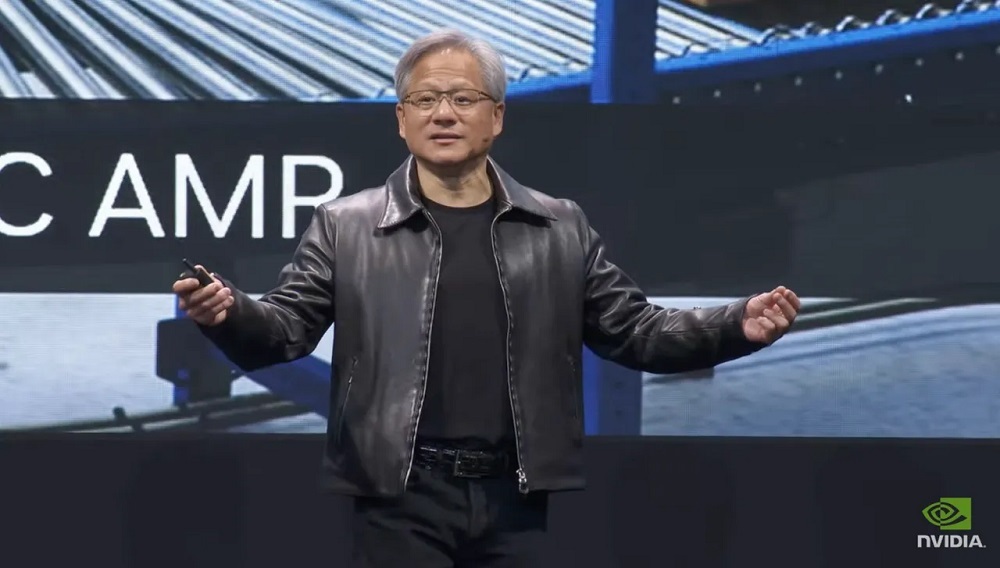

「NVIDIA Spectrum-4」のチップを見せるJensen Huang氏

提供:NVIDIA

「すべてのデータセンターを生成AI用のデータセンターに変えるために、あらゆるものと後方互換性のある新たなイーサネットをどのように導入すればよいのか?」とHuang氏は基調講演で問いかけ、次のように述べた。「われわれはハイパフォーマンスコンピューティングの能力を、初めてイーサネット市場にもたらそうとしている」

「NVIDIA Spectrum-X」ネットワーキングプラットフォーム

NVIDIAが発表した「NVIDIA Spectrum-X」ネットワーキングプラットフォームは、「世界初のAI向けハイパフォーマンスイーサネット」だという。この技術の重要な特徴は「パケットをドロップしない」点だと、同社のネットワーキング部門上級バイスプレジデントGilad Shainer氏はメディアブリーフィングで述べている。

Spectrum-Xを構成する製品の1つが「NVIDIA Spectrum-4」で、NVIDIAはこれを「1秒当たり51テラビットを誇る、AIネットワークに特化して構築された世界初のイーサネットスイッチ」と説明している。このスイッチは、NVIDIAの「BlueField」データプロセシングユニット(DPU)、データのフェッチとキューイングを処理するチップ、およびNVIDIAの光トランシーバーと連携する。また、400ギガビットイーサネット(GbE)で128ポート、または800GbEで64ポートをエンドツーエンドでルーティングすることが可能だという。

Huang氏は壇上で、銀色に輝くSpectrum-4イーサネットスイッチのチップを掲げ、台湾積体電路製造(TSMC)の「4N」プロセス技術で製造された90mm×90mmのダイに1000億個のトランジスターを搭載した「巨大な」チップだと説明した。同氏によれば、このチップは500Wで動作するという。

Huang氏

提供:NVIDIA

Spectrum-X

提供:NVIDIA

NVIDIAのチップは、イーサネットネットワーク市場に変化をもたらす可能性を秘めている。スイッチシリコン製品の多くを供給しているのは、チップメーカーのBroadcomだ。これらのスイッチは、Cisco Systems、Arista Networks、Extreme Networks、Juniper Networksなどのネットワーク機器メーカーが販売している。これらのメーカーは、AIトラフィックの処理を向上させるために機器の拡充を進めている。

Spectrum-Xファミリーは、2つの形態に分かれるデータセンターに対応するように設計されている。1つ目はHuang氏が「AI工場」と呼ぶ形態だ。こうした施設は、AIのトレーニングに使われるNVIDIAの「NVLink」と「InfiniBand」をベースとした極めて高性能なGPUを数億ドル(数百億円)かけて導入し、少数の非常に大規模なワークロードに対応する。

もう1つの形態はAIクラウドだ。こちらはイーサネットをベースとしたマルチテナント型のデータセンターで、顧客のために膨大な数のワークロードを同時に処理する。AIを消費する側に各種の予測を提供することに主眼を置いており、それをSpectrum-Xが支援する。

Shainer氏はSpectrum-Xシリーズ製品について、「輻輳(ふくそう)制御のための新しいメカニズム」を使って「トラフィックをネットワークの隅々まで最適な状態で届ける」と説明した。この新しいメカニズムは、ネットワークルーターのメモリーバッファーで起こり得るパケット詰まりを防ぐという。

「何か起こる前にホットスポットを見つけ出し、そこで輻輳が生じないように、ネットワーク上のレイテンシーを見つける最先端のテレメトリー技術をわれわれは利用している」(Shainer氏)

NVIDIAはあらかじめ用意されたコメントの中で、「業界の先端をいくクラウド革新企業を含め、世界トップのハイパースケーラーがSpectrum-Xを採用している」と述べた。

同社はイスラエルオフィスに「Israel-1」と名付けた「生成系AIスーパーコンピューター」を実証試験プラットフォームとして構築しており、「H100 GPU」で構成された「Dell PowerEdge XE9680」サーバーを使い、Spectrum-4スイッチを介してデータをやり取りしている。

「DGX GH200」AIスーパーコンピューター

この新しいイーサネット技術の発表に加え、Huang氏は基調講演で、AIに対応した「DGX」コンピューターシリーズの新モデル「DGX GH200」も発表した。「大規模な生成系AIモデルに向けた大型メモリーAIスーパーコンピューターの新しいクラス」だと同社は説明している。

生成系AIとは、OpenAIの「ChatGPT」のように、文章や画像など、さまざまな作品を生み出すプログラムを指す言葉だ。

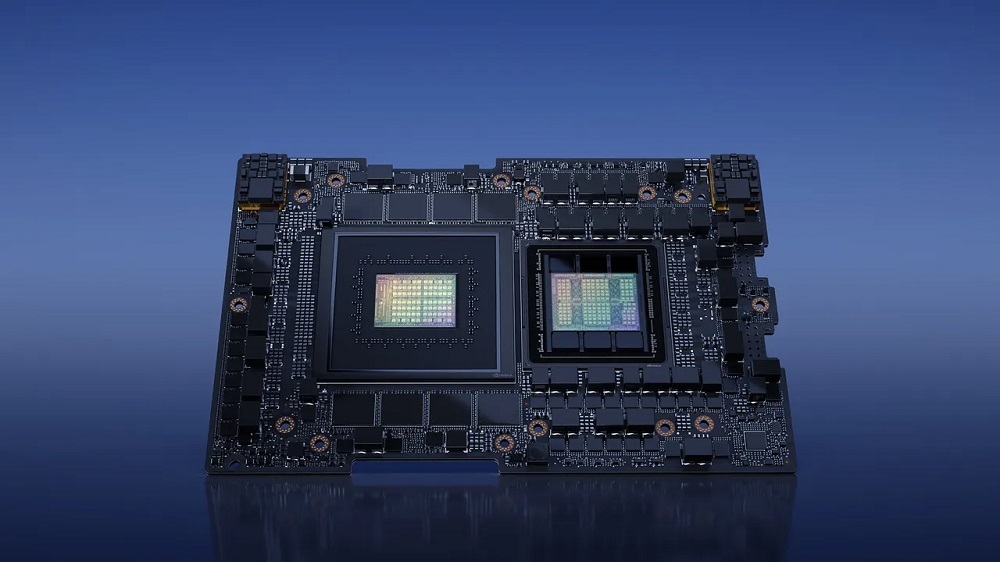

DGX GH200は、同社が「スーパーチップ」と呼ぶコンポーネントを搭載して出荷される初のシステムとなる。この「NVIDIA GH200 Grace Hopper Superchip」は、Armベースの「NVIDIA Grace CPU」と「NVIDIA H100 TensorコアGPU」を組み合わせたものだ。

GH200 Grace Hopper Superchip

提供:NVIDIA

Huang氏によれば、GH200 Grace Hopper Superchipは「フル生産体制」に入っているという。NVIDIAのプレスリリースには、「GH200を搭載したシステムの利用を予定している顧客には、欧州および米国の世界的なクラウド企業やスーパーコンピューターセンターが含まれる」と書かれている。

NVIDIAによれば、DGX GH200は256基のスーパーチップを搭載し、144テラバイトの共有メモリーを利用することで、合わせて1エクサフロップス(毎秒10の18乗回、つまり100京回の浮動小数点演算を実行できる性能)を達成するという。また、2020年に発売された初代のAIシステム「NVIDIA DGX A100」の500倍の速度を実現するとしている。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。