ほとんどの人が何らかのアルゴリズムに日々接している一方、人工知能(AI)がどのように機能するのか、実際に理解していると自信を持って言える人はそれほど多くない。しかし、Googleが英国で現地時間11月20日から開催している「Google Cloud Next '19 UK」で発表した新たなツールは、一般の人々が機械学習(ML)の難解さをひもとくうえで力となるはずだ。

提供:Google Model Cards

「Explainable AI」(説明可能なAI)と呼ばれるこのツールは、MLモデルが思考を重ねる手法と、結論に至った理由をユーザーに説明するという、その名が示す通りの機能を有している。

Explainable AIは、そういった機能を実現するために、データセット内の各特徴がアルゴリズムの導き出した結果にどの程度の影響を与えたのかを定量化する。つまり、それぞれのデータ係数には、MLモデルにどの程度影響を与えたのかを示すスコアが割り当てられる。

ユーザーはそのスコアを参照することで、あるアルゴリズムが何らかの判断を下した理由を理解できるようになる。例えば、誰かに対する融資の承認可否を決定するモデルの場合、Explainable AIは口座残高や信用度が最も重要なデータであることを示してくれる。

同ツールは現在、Googleの「AutoML Tables」上と「Cloud AI Platform Predictions」上でホストされているMLモデルに対して適用できる。

Googleは過去にもアルゴリズムの透明性を高めるための取り組みを実施している。同社は、そのAIプラットフォーム上で作業する際のデータセットの可視化機能と探査機能を開発者に提供する「What-If Tool」を発表している。

Explainable AIがデータの係数を定量化することで、さらに深い洞察がもたらされるとともに、そういった洞察がより多くの人たちに分かりやすく伝えられるようになる。

Google CloudのCloud AI戦略担当ディレクターTracy Frey氏は、「AI ExplanationsとWhat-If Toolを組み合わせて、モデルの振る舞いの全体像を示すこともできる」と述べた。

医療などの一部の分野では、AIの透明性を向上することは特に有用だろう。

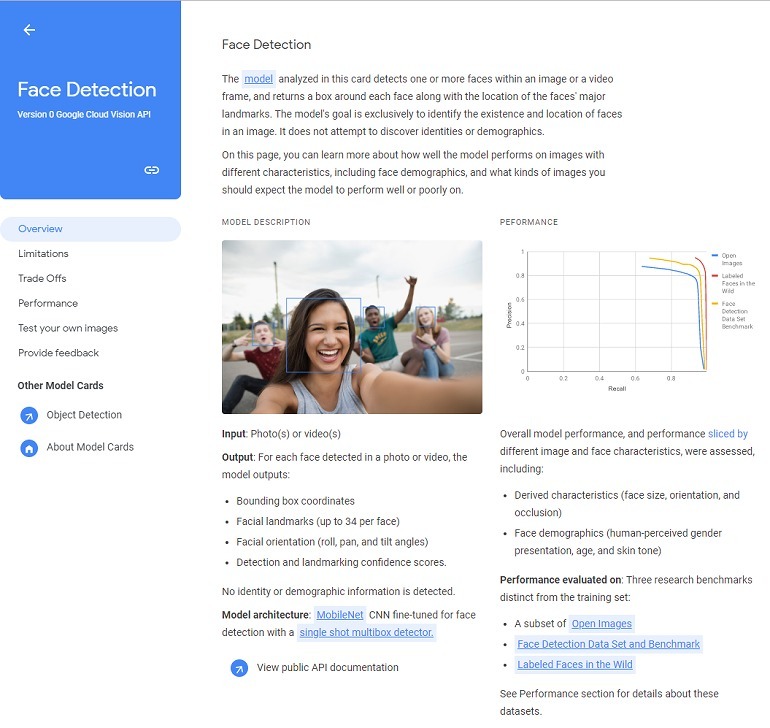

同社は「モデルカード」と呼ぶ新たなコンセプトの立ち上げも発表した。モデルカードとは、特定のアルゴリズムについての簡潔な情報を提供する短いドキュメントだ。

このドキュメントは、モデルのパフォーマンスや制約に関する実用的な詳細を含んでおり、実質的にMLモデルの身分証明書のようなものと言える。

同社は、これにより「開発者はどのモデルをどういった目的で、どのように配備するのが責任あるやり方なのかについて、より優れた判断を下せるようになる」と述べている。

Googleは既に、モデルカードの実例として、顔認識アルゴリズムと物体検知アルゴリズムの2つを公開している。

ユーザーはモデルの出力やパフォーマンス、制約について確認できるようになる。例えば、顔認識モデルカードでは、このアルゴリズムが顔の大きさや向きのほか、光源の品質によって左右されることが説明されている。

今回発表された新しいツールや機能は、テクノロジーを開発する上でさらなる透明性を求める、AIの基本理念に忠実な姿勢を示そうとするGoogleの取り組みの一端だ。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。