企業が人工知能(AI)を使用する際に求められるのは「正しく使う」ことだ。アクセンチュアがそうした企業の取り組みに向けて「責任あるAI」の実践を提唱している。一方で、筆者は「使用者責任」を問う法律をつくってはどうかとも考える。今回はこの論議について記しておきたい。

アクセンチュアが提唱する「責任あるAI」とは何か

「AIは企業において高度な意思決定をはじめとして、ますます幅広い用途に使われていく。そうした企業にこれから求められるのは、AIを正しく使うことだ。そこで私たちは『責任あるAI』の実践を提案している」

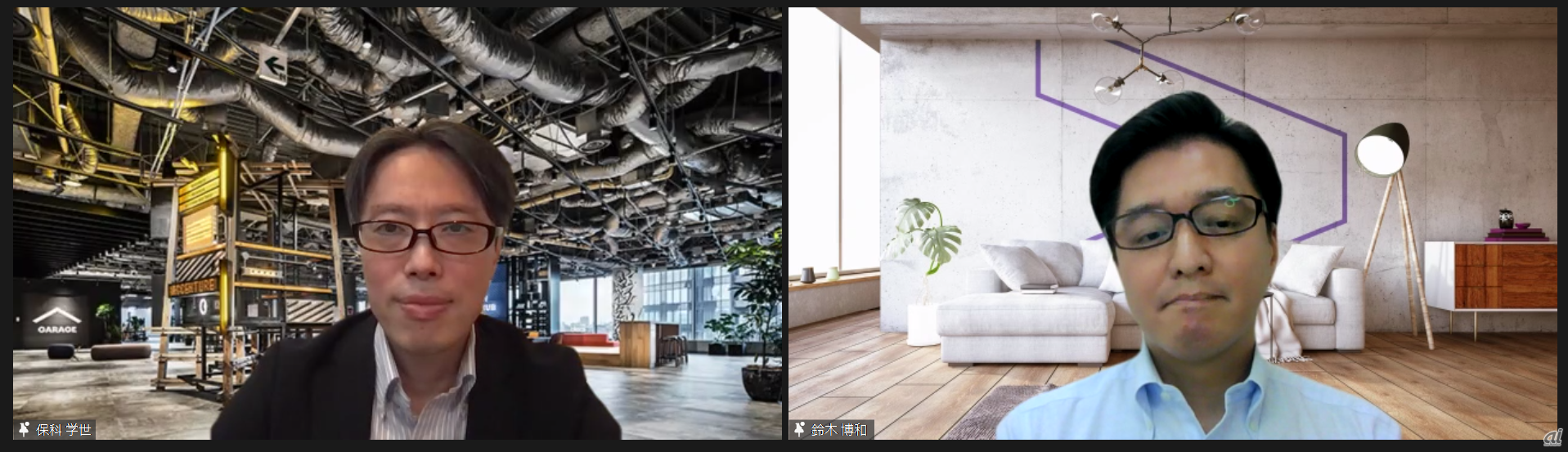

こう語るのは、アクセンチュア ビジネスコンサルティング本部 AIグループ日本統括 AIセンター長の保科学世氏だ。同社が先頃「責任あるAIの実践」についてオンラインで開いた記者説明会のひとコマである(写真1)。

写真1:左から、アクセンチュア ビジネスコンサルティング本部 AIグループ日本統括 AIセンター長の保科学世氏と、同AIグループ シニア・マネジャーの鈴木博和氏

責任あるAIとはどういうことか。保科氏によると、「顧客や社会に対してAIの公平性や透明性を担保する方法論」だとし、「この方法論に基づいてAIを設計、構築、展開することで、真に人間中心のAI活用の実現を目指すことが可能になる」と説明した。

さらに、「責任あるAIによって、企業はAIの持つリスクを正確に理解できるようになる。そして、AIが持つ潜在的リスクへ対策することで、人は初めてAIを信頼できるようになり、ひいては自社のビジネスに活用していけるようになる」とも述べた。

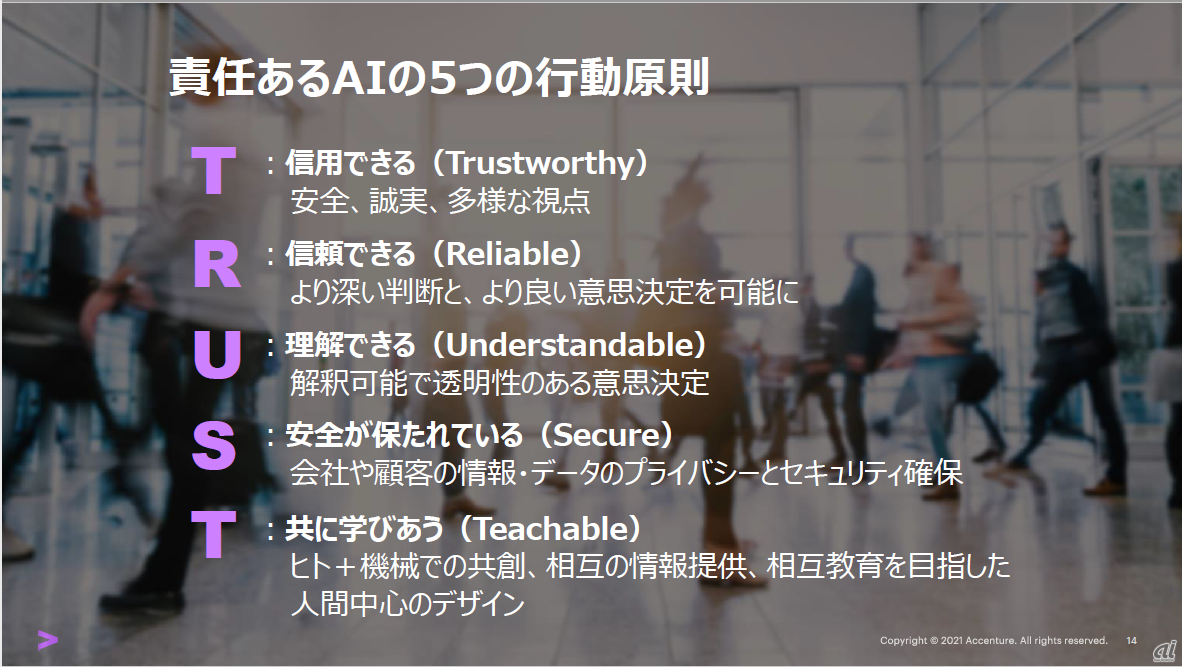

責任あるAIには、図1に示すような行動原則がある。「信用できる」「信頼できる」「理解できる」「安全が保たれている」「共に学びあう」の5つで、それらの英語表記の頭文字を並べると「TRUST」になる。

図1:「責任あるAI」の5つの行動原則(出典:アクセンチュア)

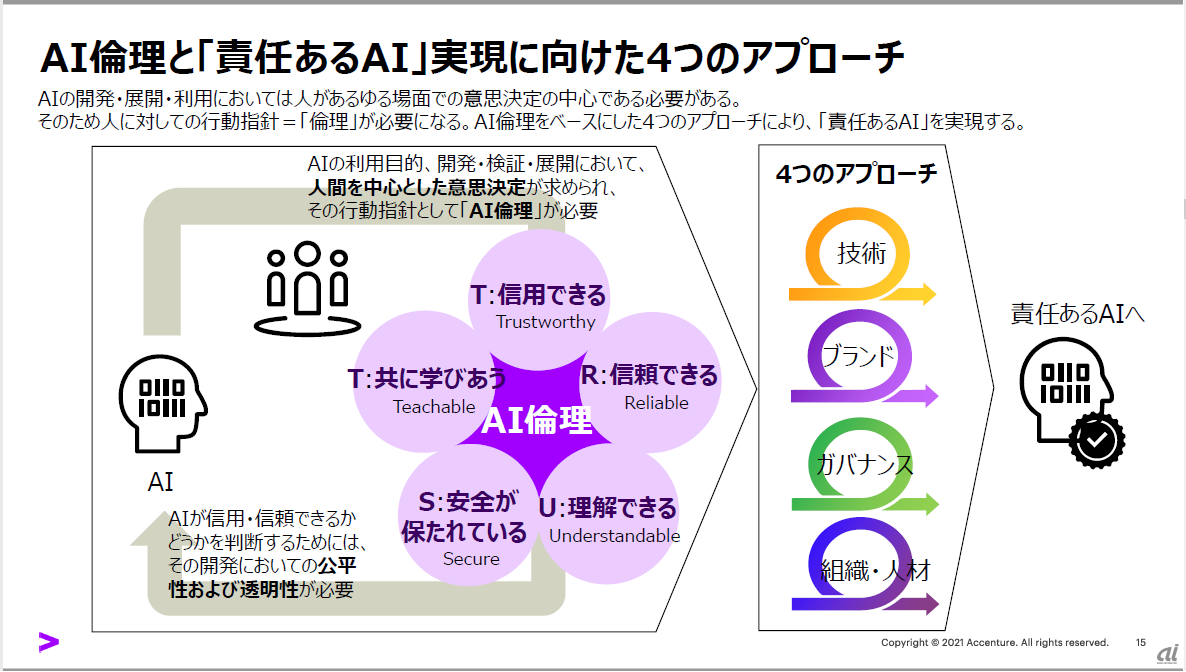

保科氏はさらに図2を示しながら、「AIの開発、展開、利用においては人があらゆる場面での意思決定の中心である必要がある。そのため、人に対しての行動指針、すなわち倫理が必要になる。そのAI倫理をベースにして、技術、ブランド、ガバナンス、組織・人材の4つのアプローチによって責任あるAIを実現する」と説明した。

図2:「責任あるAI」実現に向けた4つのアプローチ(出典:アクセンチュア)

逆に言うと、責任あるAIのベースとなるのはAI倫理ということだが、この点について同氏は、「AI倫理と表現したが、倫理を突き詰めればAIの新たな可能性を見いだせるのではないか。AIはリスクもある技術だが、それを生み出して使用する人間の考え方次第で、より良い社会や企業づくりに生かすことができると、私は確信している」と、自らの考え方を示した。