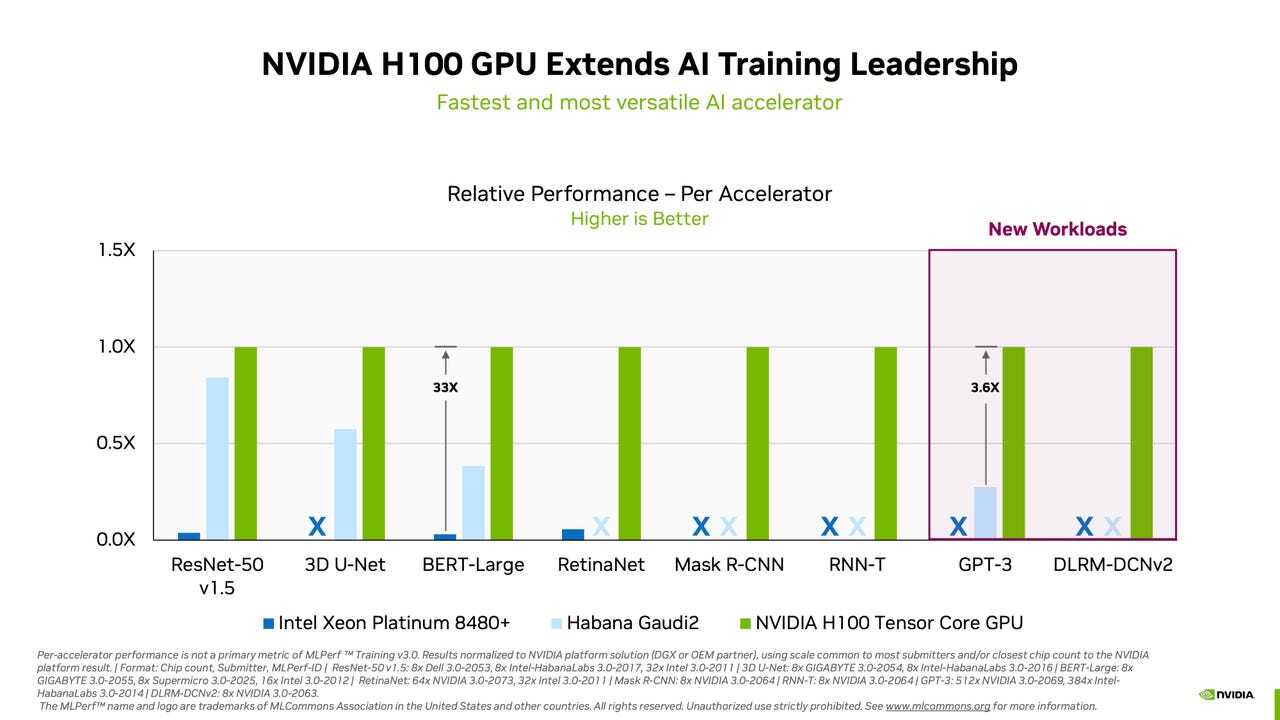

エンジニアリングコンソーシアムMLCommonsは米国時間6月28日、人工知能(AI)ベンチマークテスト「MLPerf Training v3.0」の結果を発表した。この数年と同様、NVIDIAがすべての項目で最高スコアを記録した。

提供:Nvidia

今回は、ライバルのGoogleやGraphcore、Advanced Micro Devices(AMD)が参加しなかったため、NVIDIAが8種類のテストのすべてでライバルに勝利した。

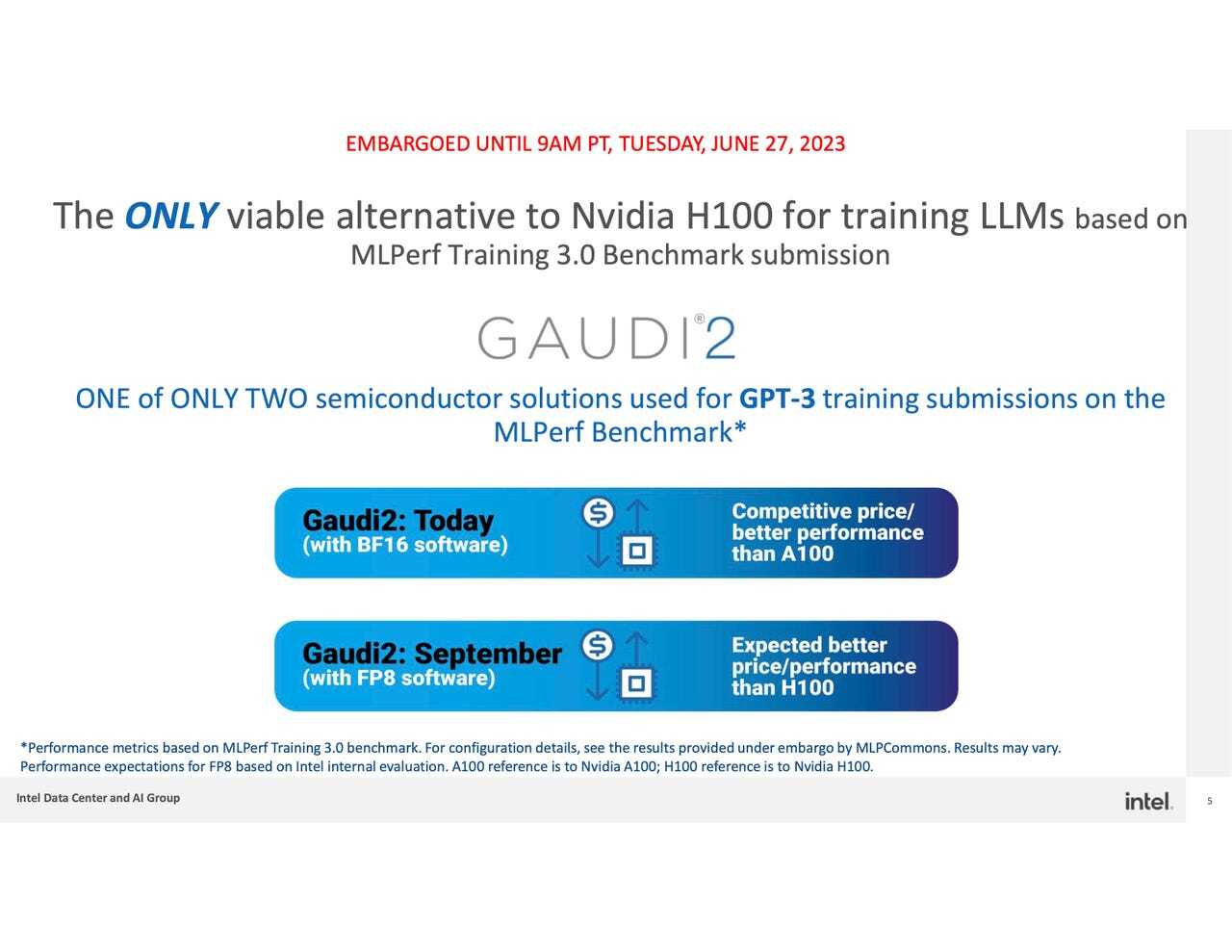

とはいえ、Intelの「Habana Gaudi2」チップは善戦した。同社は2023年秋までにNVIDIAのハイエンドGPU「H100」に勝つことを目指している。

提供:Intel Habana

MLPerf Training v3.0ベンチマークテストは、ニューラルネットワークの「重み」、つまりパラメーターを調整して、コンピュータープログラムが所定のタスクで基準となる精度を達成するまでの時間を分単位で報告するものだ。この一連のプロセスは、ニューラルネットワークの「訓練」と呼ばれている。

メインのテストは計8種類のタスクで構成されており、複数の実験で設定を調整し、ニューラルネットワークをチューニングするのに要した時間を記録する。チューニングはニューラルネットワークのパフォーマンスの半分を占めており、残りの半分はいわゆる推論(完成したニューラルネットワークが新しいデータを受け取って予測を行うこと)だ。推論能力は、MLCommonsの別のテストで評価される。

MLCommonsは、訓練されたニューラルネットワークが非常に低消費電力のデバイス上で新たなデータを処理する速さを測定するベンチマークテスト「MLPerf Tiny v1.1」の結果も公開している。

MLPerf Training v3.0のテスト結果によると、NVIDIAは最も短い時間で訓練を完了し、8種類のテストのすべてで首位になった。また今回、2種類の新しいタスクが追加された。1つは、OpenAIによって開発された「GPT-3」大規模言語モデル(LLM)のテストだ。同じLLMをベースとするOpenAIの「ChatGPT」プログラムが人気を博したことで、LLMを使用した生成AIが大きなブームとなっている。GPT-3のタスクでは、NVIDIAがパートナーのCoreWeaveの協力を得て構築したシステムで首位になった。

NVIDIAとCoreWeaveが共同で構築したシステムは、「Colossal Cleaned Common Crawl」と呼ばれるデータセットを使用した訓練をわずか11分弱で完了した。このシステムは、896個のIntel「Xeon」プロセッサーと3584個のNVIDIA H100 GPUで構成されており、NVIDIAの生成AI用「NeMO」フレームワークを使用してタスクを実行した。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。