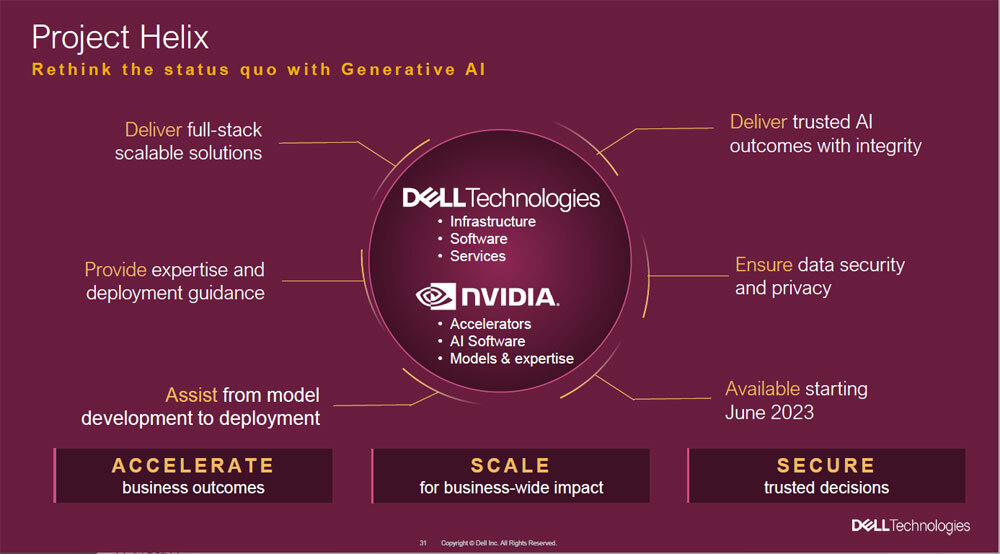

Dell Technologies(Dell)とNVIDIAは、Dellが5月22~25日に米国ラスベガスで開催した年次イベント「Dell Technologies World 2023」において、オンプレミス環境で生成AIを迅速に開発・構築する共同イニシアチブ「Project Helix」を発表した。企業が独自の大規模言語モデル(LLM)を開発・活用する際、用途に応じた最適な事前検証済みシステムを両社が共同で提供する。

基調講演では、DellとNVIDIAの30年にわたる強固なパートナーシップが強調された

今回のイベントでDellは、企業が抱える課題の一つとして「AIの活用」を掲げている。OpenAIの「ChatGPT」やGoogleの「Bard」など、汎用AIの急速な普及で、多くの企業がAI活用を検討している。ルーチンワークの自動化による生産性向上や、情報収集の効率化、チャットボットによる顧客体験の向上などが目的だ。

Dell Technologies Worldの会場となったMANDALAY BAY HOTELに併設されたULTRA ARENA

しかし、企業が自社のシステムにAIを導入する場合、さまざまな課題がある。その一つがデータセキュリティだ。Dell バイスチェアマン 兼 共同最高執行責任者(COO)のJeff Clarke氏は、基調講演で「データの保護や整合性の確保はもちろん、データプライバシーや『GDPR』(欧州の一般データ保護規則)など、各国・各地域のコンプライアンスや業界固有の規制に準拠しなければならない」と指摘する。

Dell バイス チェアマン兼共同COOのJeff Clarke氏

企業独自の生成AIモデルの開発・運用は、大規模な汎用AIモデルの活用とは異なるアプローチが必要だ。例えば、営業支援やカスタマーサポート、マーケティング、コミュニケーションなどに特化した目的別生成AIモデルの開発には、個別のチューニングをしなければならない。

Clarke氏は、「Project Helixは、DellとNVIDIAの技術ノウハウやインフラストラクチャーとソフトウェアを基盤にした、生成AIモデルの作成・実行に最適なフルスタックソリューションだ」と語る。

LLMを使用する生成AIを開発・活用するサーバーの場合、メモリーやGPUはもちろん、データストアの作成にも、目的別に最適化されている必要がある。Project Helixでは、DellとNVIDIAでそうした内容を事前に検証し、顧客ニーズに合わせて最適にサイジングしたソリューションを提供する。

「Project Helix」の概要

具体的なハードウェア構成は、AIや機械学習(ML)、深層学習(DL)など、要求の厳しいワークロードに対応可能な「Dell PowerEdge XE9680」や「PowerEdge R760xa」などの高密度GPUサーバーに、NVIDIAの「NVIDIA H100 Tensor Core GPU」やNVIDIAのネットワークを組み合せる。

ソフトウェアは、サーバーのパフォーマンスをモニタリング・分析する「Dell CloudIQ」をはじめ、NVIDIA GPUを用いたAIの開発環境の運用を簡素化する「NVIDIA AI Enterprise」も包含する。なお、NVIDIA AI Enterpriseには、LLMフレームワーク「NVIDIA NeMo」や、生成AIチャットボットを構築する「NeMo Guardrails」など、100以上のフレームワークや事前トレーニング済みモデルおよび開発ツールを包含する。

セキュリティ面ではハードウェアの構成内容が工場で生産された通りであることを証明する「Secured Component Verification」が、基礎コンポーネントに組み込まれている。さらに、オンプレミスの生成AIアプリケーション向けデータセキュリティを組み込んだインフラストラクチャーのプロビジョニング、モデリング、トレーニング、ファインチューニング、アプリケーション開発および展開といったサービスも提供されるという。

なお、Project Helixで構築されたインフラストラクチャーは、「Dell PowerScale」や「Dell ECS(Enterprise Object Storage)」など、非構造化データストレージとも連携可能だ。