分析基盤は何を提供すべきか

このようなアナリティクスに対するアプローチのために、アナリティクス基盤自体は、何を提供すべきだろうか。これについて田中氏は、次の6つの方法を提供する必要があると述べた。

- データを貯める方法

- データを収集する方法

- データを分析する方法

- データを可視化する方法

- データを提供する方法

- 効率よく回す方法

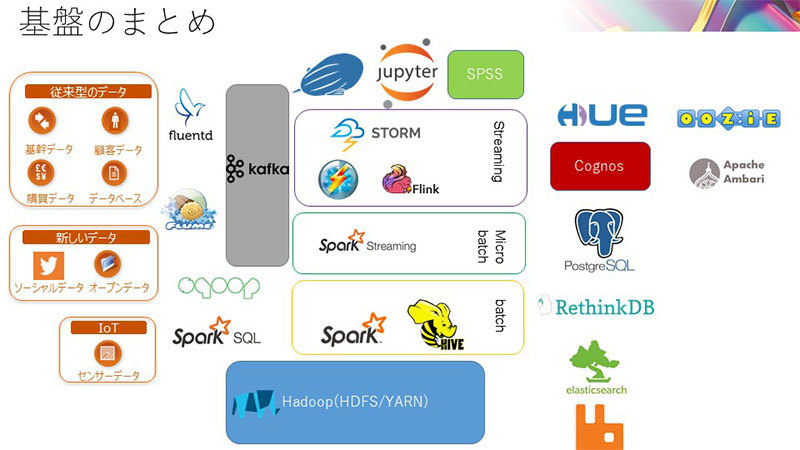

データを貯める方法については、最近ではHadoopをはじめとして多くのソリューションが登場している。データを収集する方法では、従来型の固定的な基幹データから、ソーシャルデータやオープンデータなど新しいデータ、さらには膨大なセンサーデータを集めることができるIoTなど、多様で膨大なデータを考慮する必要がある。このとき、KafkaなどのOSSツールが効力を発揮するという。そして、これらのデータを分析・可視化する方法として、Apache ZeppelinやJupyter NotebookといったSparkを実行できるツールが役立つという。データを提供する方法については、データや分析結果をどのように外部に提供するのか、あらかじめ考えて基盤設計しておくことが、その利用価値を広げるというのだ。

そして、特に忘れがちなポイントとして、これらのアナリティクスのフローを効率よく回すための方法が重要になると述べた。そして、ここで紹介したような多数のミドルウェアのクラスターを管理するため、Hadoop管理ツールであるApache Ambariや、バッチのフロー管理ツールOozieといったツール活用することで、アナリティクス基盤の運用業務の属人化を回避し、円滑に回すことができるという。

効果的に活用するための3つのナレッジ

もちろん、このようなツールを導入するだけで、アナリティクス基盤の活用が成功する訳ではない。そこで最後に、田中氏は、アナリティクス基盤を構築・運営する中で、自身の体験から得た知見を共有してくれた。いずれのノウハウも、冒頭で紹介したアナリティクス基盤がゴミ箱になるリスクと対応するもので、極めて実践的な内容になっている。

まず、どこでETLをやるべきかという課題がある。データを生成しているシステムや部門側に、アナリティクスに対応するデータの加工を依頼しても、なかなか対応してもらえないのだ。そこで田中氏のお勧めは、アナリティクス基盤側に、OSSの分散メッセージングツールであるKafkaを短期間のストレージとして設置することだという。システムの境界をKafkaで区切ることで、データ収集を非同期にして、データを処理しやすくするのだ。

次に、データに対する利用者ごとのアクセス制御など、セキュリティの切り分けについては、どのように対応すべきだろうか。ひとつの方法は、複数の可視化ツールを用意して、アクセスする人や役割ごとにツールを分けることが効果的だと述べた。また、個人情報などのデータの取り扱いは、Hadoopに投入する前の段階でKafkaを使ってマスキングしてしまうのが有効だという。

最後に、分析結果を生かすために、どうやってナレッジを共有するのかという課題については、Apache ZeppelinやJupyter Notebookなどの、ドキュメントとデータ可視化が一体になったツールを用意することで、処理とコメントを分析単位で記録していくのが効果的だと述べた。

新たなビジネスチャンスを創出する技術としてWatsonなどの人工知能が注目を集める。これらは、ネットを経由して集った膨大なデータを学習することで、パフォーマンスを発揮すると言われている。そこで重要かつ不可欠なのが、高速で柔軟なデータ収集・分析基盤であろう。データを収集・検証できる体制を整えなければ、人工知能も効力を発揮しないはずだ。もちろん、人工知能技術を使わないとしても、モバイルやネットを通じて押し寄せる膨大なデータから、どのようにビジネス価値を抽出するのか、多くのビジネスパーソンの興味を引くのではないだろうか。