ZDNet JapanおよびTechRepublic Japan主催、AWS Partner Network協賛で、クラウドの中心的存在である「アマゾン ウェブ サービス(AWS)」をテーマにした5週連続セミナーが開催された。2017年7月19日に行われ第4回のテーマは「ビッグデータ」。関連企業が登壇したセッションでは、クラウドベースのビッグデータ分析などについて、実践的な手順や役立つノウハウが詳しく紹介された。ここではその内容をレポートする。

クラスメソッド:アウトプット、インプット、アーキテクチャをまず定義

クラスメソッド

AWS事業部 部長

佐々木大輔氏

クラスメソッドのセッションでは、AWS事業部の佐々木大輔氏が登壇。「急成長するビジネスを支えるビッグデータ分析」と題して、同社が手がけた事例と、その際に利用したツールや分析ノウハウを解説した。

クラスメソッドは社内のAWS認定資格保有数が200を超え、3年連続で「AWSプレミアコンサルティングパートナー」に認定されている。サービスとしては、AWSを総合的に支援する「クラスメソッドメンバーズ」を展開。月間120万PVを誇る技術ブログ「Developers.IO」でも知られる。

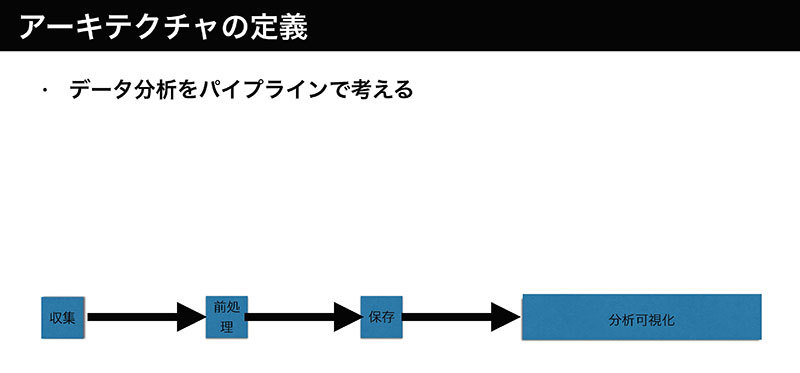

佐々木氏は、ビッグデータの導入事例として、Amazon KinesisとAmazon Redshift (Redshift)を活用して売上と店舗オペレーションを可視化する、あきんどスシローや、RedshiftとTableauを使って分析基盤を構築したダーツライブ、売上データを分析する基盤を構築した資生堂、トリドールホールディングスなどの事例を紹介。ビッグデータ分析を始めるうえではまず「アウトプット、インプット、アーキテクチャの3つを定義し、収集、前処理、保存、分析・可視化といったパイプラインを構築することがポイントです」と指摘した。

パイプライン上で最適なサービスを選択

アウトプットは、現状の課題を解決するために何を分析するのか、どんなアウトプットがほしいのかを定める。インプットは、データの種類や構造、場所などの明確化が必要。パイプラインについては、それぞれのフェーズでツールを活用する。

例えば、収集はデータレイクを構築するうえでS3が役立つ。前処理はETLを行うが、それにはAmazon EC2でのバッチ処理、Amazon EMRといった方法がある。また、保存先のDWHではRedshiftやAmazon Auroraが、分析・可視化ではマネージドBIツールのAmazon Quicksightが有用だという。

佐々木氏は「AWSが提供するツールだけでなく、Tableau、Talend、Qlikといった商用ツールを環境に合わせて活用していきます。特徴を理解したうえでパイプラインのジョブに最適なサービスを選択する必要があります。PoCを行ってダメなら、アウトプット、インプット、アーキテクチャの選定から仕切り直すこと」とポイントを解説した。

最後に「カスタマーストーリーアナリティクス」というソリューションも提供していることに触れながら、「AWSのビッグデータ分析には多くの事例とノウハウがあります。それを活用して、最速最安で分析をスタートしましょう」と述べた。