近年、ユーザー参加型のWeb サイトやブラウザベースのアプリケーションなどWeb2.0の特徴を生かした高度なサービスが登場し、人々の情報共有のあり方を大きく変えつつあります。

| Web 1.0 | Web 2.0 | |

|---|---|---|

| DoubleClick | ⇒ | Google AdSense |

| mp3.com | ⇒ | Napster |

| 個人サイト | ⇒ | ブログ |

| ページビュー | ⇒ | クリック単価 |

| パブリッシング | ⇒ | 参加 |

| コンテンツ管理システム | ⇒ | Wiki |

| ディレクトリ | ⇒ | タグ付け |

Web2.0におけるセキュリティ上の課題

セキュア コンピューティング ジャパン株式会社

シニア プリセールス コンサルタント

堀 政浩氏

Webサイトで情報を発信するためのツールが普及したのと同様に、マルウェアを作るためのツールも簡単に入手できるようになっています。それによりマルウェア作成のハードルがどんどん低くなっているのです。

ウイルス対策は90%以上、ほとんどの企業が導入しています。ファイアウォールもネットワークセキュリティとウイルスセキュリティは基本とされているので、 多くの企業で利用されています。しかし、ウイルス対策もファイアウォールも、ほとんどの製品はWeb2.0の脅威への備えとしては不十分なものでしかありません。多くの製品はシグネチャによる判別に頼っており、マルウェアや攻撃手法の変化のペースに対応するのが困難です。

シグネチャによるセキュリティは既知の脅威であれば確実にブロックできるのが特徴ですが、後追いの防御になります。各製品のベンダーから提供されるシグネチャ情報には常にタイムラグがあり、新たな脅威への対応は遅れてしいます。

これに抵抗するために求められるのが、レピュテーション(評価)ベースやインテント分 析による、プロアクティブ(予防的)なセキュリティとなります。

Web2.0時代の複合的脅威

レピュテーションを利用した保護

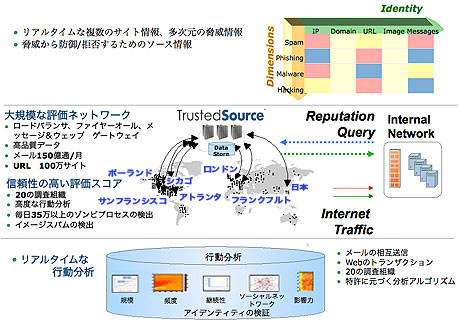

脅威は日々進化し、昨日の攻撃コードが翌日にまったく違うものになっています。そこで、レピュテーションベースのアクセス制御が有効になります。セキュアコンピューティングでは、レピュテーションシステムとしてTrustedSource(トラステッドソース)を2004年から運用しています。TrustedSourceでは、世界中に配置された1万台以上のセンサーを利用し、そこに流れるさまざまなネットワークの情報をセンターに集約し、サイバー上におけるインシデントの発見に活躍しています。

TrustedSourceにより、組織内の各サーバは、危険なアクセスを回避することができます。今後、進化し続ける新たな脅威に対しては、もはやネットワークの発信元との交信を遮断することが最も効果的なのです。

複合型脅威に対するソリューション

セキュアコンピューティングが提供しているアプライアンス製品「Webwasher」

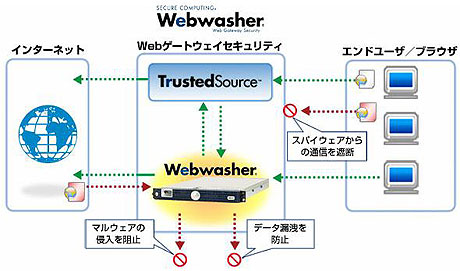

Webwasherは、Webゲートウェイセキュリティに位置づけられる製品で、エンドユーザーとインターネット間のインバウンド、アウトバウンド、双方のデータを監視します。そして最大の特長は、先述のプロアクティブな防御を実現している点です。

Webwasherの利用イメージ

Webwasherは、上記のアンチマルウェアやアンチウイルスの機能以外にも、1台の中にプロキシ/キャッシュ、URLフィルタ、SSLスキャナを搭載しています。また、URLフィルタは同社が誇るレピュテーションベース「TrustedSourceTM」が搭載され、ゼロデイ攻撃への対処も実現しています。

Webwasherは、コンプライアンスにも効果を発揮します。特定のURLに対する書き込みや、WebMailを利用したメール送信、社内機密情報のアップロードに対し、フィルターすることができます。

このように脅威が複雑化、複合化していくWeb2.0時代では、攻撃者がいつ悪意を向けてくるかは予測できず、そのためにもプロアクティブな防御は欠かせません。