NVIDIAは米国時間5月29日、新たなサーバプラットフォーム「HGX-2」を発表した。HGX-2は、高性能コンピューティング(HPC)と人工知能(AI)という双方の能力を必要とするアプリケーションが増加するなか、需要に応えるべく設計されたプラットフォームだ。

同社によると、このプラットフォームはHPCとAIのワークロード双方を取り扱える高精度計算機能を提供する初の製品だという。同製品は、科学技術計算やシミュレーション用として64ビット浮動小数点(FP64)演算機能と32ビット浮動小数点(FP32)演算機能を搭載するとともに、AIの訓練や推論用として16ビット浮動小数点(FP16)演算機能と8ビット整数(INT8)演算機能を搭載している。

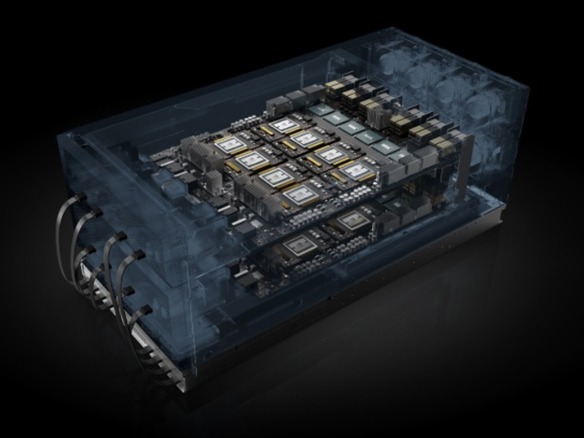

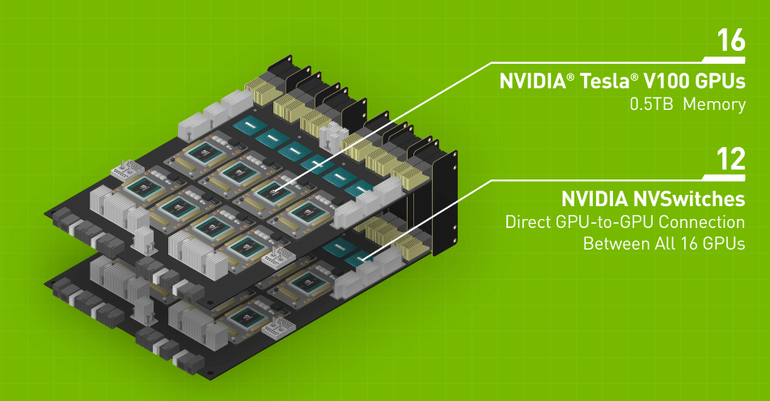

HGX-2サーバプラットフォームは1対の基板から構成されている。各基板には8基の「NVIDIA Tesla V100 Tensor Core GPU」(32Gバイト)が搭載されている。これら16基のGPUは12の「NVIDIA NVSwitch」を介して完全接続されており、全体で2ペタFLOPSのAI性能を実現している。

NVIDIAが最近発表した旗艦サーバ「NVIDIA DGX-2」は、このHGX-2を用いて構築された最初のシステムだ。

同社によると、ディープラーニング(DL)の訓練においてはHGX-2単体で、CPUのみを搭載したサーバ最大300台分に匹敵する性能を有しており、ResNet-50を使用した訓練のベンチマークで1秒あたり1万5500枚の画像処理を達成しているという。

既に4社のサーバメーカー(LenovoとQCT、Supermicro、Wiwynn)が、HGX-2搭載システムを2018年中に市場に投入する計画を発表している。さらに、4社の相手先ブランド設計製造業者(FoxconnとInventec、Quanta、Wistron)が大規模クラウドデータセンター向けのHGX-2搭載システムの設計を行っている。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。