NVIDIAは米国時間3月18日、5年ぶりにリアルイベントでの開催となった「NVIDIA GTC 2024」で、次世代のデータセンター向けGPUプラットフォーム「Blackwell」を発表した。このプラットフォームは、現世代の「Hopper」と比べてパフォーマンスで最大30倍、コスト効率と電力効率で最大25倍の性能を実現する。

同社は、BlackwellプラットフォームのGPUアーキテクチャはさまざまな分野で効果を発揮すると述べているが、最高経営責任者(CEO)のJensen Huang氏が基調講演で特に強調したのは生成AIでの利用だ。

NVIDIAによれば、Blackwellアーキテクチャーには新たに6つの新技術が導入されている。

- 強力なチップ:Blackwellアーキテクチャには、専用のTSMC 4NPプロセスを使用して製造されたチップが使用される。このチップは、2つのダイを10TB/sのチップ間リンクで接続して巨大な1枚のチップにしたもので、2080億個のトランジスタが搭載されている。

- 第2世代「Transformer Engine」:Blackwellでは、NVIDIAの先進的なダイナミックレンジ管理アルゴリズムである第2世代のTransformer Engineを使用することで、新たに4ビット浮動小数点によるAIの推論が行えるようになる。これによって、扱えるコンピューティングやモデルのサイズが2倍になるという。

- 第5世代「NVLink」:GPU間の通信に使用されるNVLinkも第5世代に進化し、最大で256基のGPU間で1.8TB毎秒のスループットを実現した。

- 「RAS Engine」:AIのトレーニングなどの長期間の処理を想定して、処理の最中に一部のGPUに不具合が出た場合にも柔軟に対応できるように、チップレベルで予防保守を行うRAS EngineがすべてのGPUに搭載される。

- セキュアなAI:データを暗号化したまま処理を行う「コンフィデンシャルコンピューティング」を実現するために、ネイティブインターフェースで暗号化プロトコルに対応する。これによって、パフォーマンスを下げずにAIモデルや顧客データを保護したまま処理を行うことができる。

- 解凍エンジン:最新のフォーマットに対応した専用のハードウェアデータ解凍エンジンを導入することで、データの高速な解凍が可能になる。

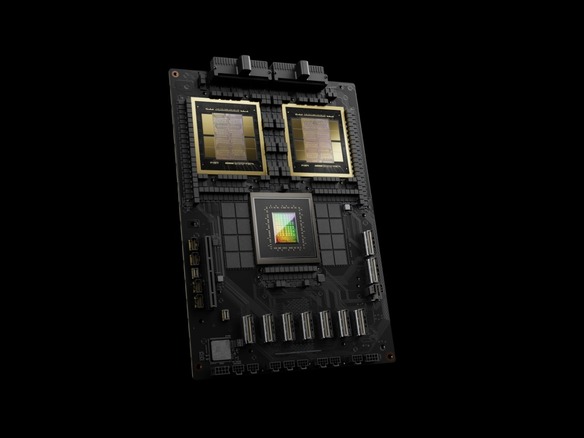

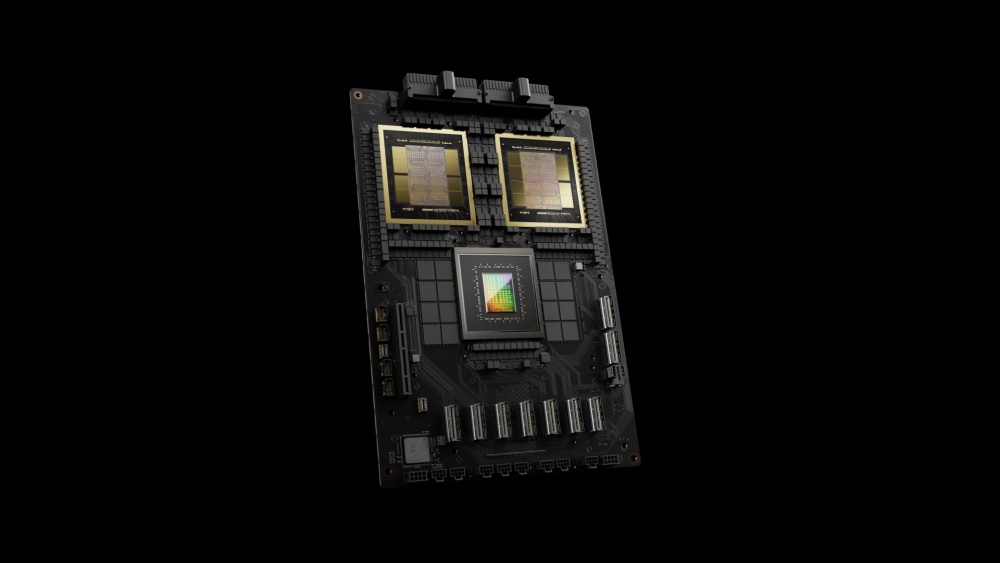

Blackwellプラットフォームの基本コンポーネントは、2つの「NVIDIA B200 TensorコアGPU」と1つの「NVIDIA Grace CPU」をNVLinkで接続したスーパーチップ「NVIDIA GB200 Grace Blackwell Superchip」だ。

「NVIDIA GB200 Grace Blackwell Superchip」

提供:NVIDIA

同社は今回、計算集約的なワークロード向けのマルチノード水冷ラックスケールシステムである「NVIDIA GB200 NVL72」も発表しており、このシステムにはGB200 Grace Blackwell Superchipが36基搭載される(つまり、1ラックにB200が72基、Grace CPUが36基搭載されることになる)。さらにこのLVN72は、1.4エクサフロップスのAIパフォーマンスと30TBの高速メモリを備えた単一のGPUとして機能し、最新版の「DGX SuperPOD」の構成要素になるという。

Blackwellプラットフォームを使用した製品は、2024年内にAmazon Web Services(AWS)、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructureなどの主要なクラウドサービスプロバイダーで利用できるようになる見込みだ。