富士通と東京工業大学、東北大学、名古屋大学、理化学研究所、サイバーエージェント、Kotoba Technologiesは5月10日、理化学研究所のスーパーコンピューターシステム「富岳」で学習した大規模言語モデル(LLM)「Fugaku-LLM」を公開した。日本語能力を強みとし、研究や商用で活用できるとしている。

Fugaku-LLMは、国内で多く開発されているLLMの70億パラメーターよりも大きな130億パラメーターの高い性能でありながら、現在の計算機環境下で扱いやすいLLMだという。学習には、サイバーエージェントが収集した独自の日本語の学習データと英語のデータなどを用いており、透明性と安全性を確保しながら日本語性能にも優れているとする。日本語ベンチマークの「Japanese MT-Bench」で最高性能を達成し、特に人文社会系のタスクでは高いベンチマーク性能を発揮するという。「GitHub」や「Hugging Face」を通じて公開され、ライセンスに基づいた研究および商用利用を可能にしている。

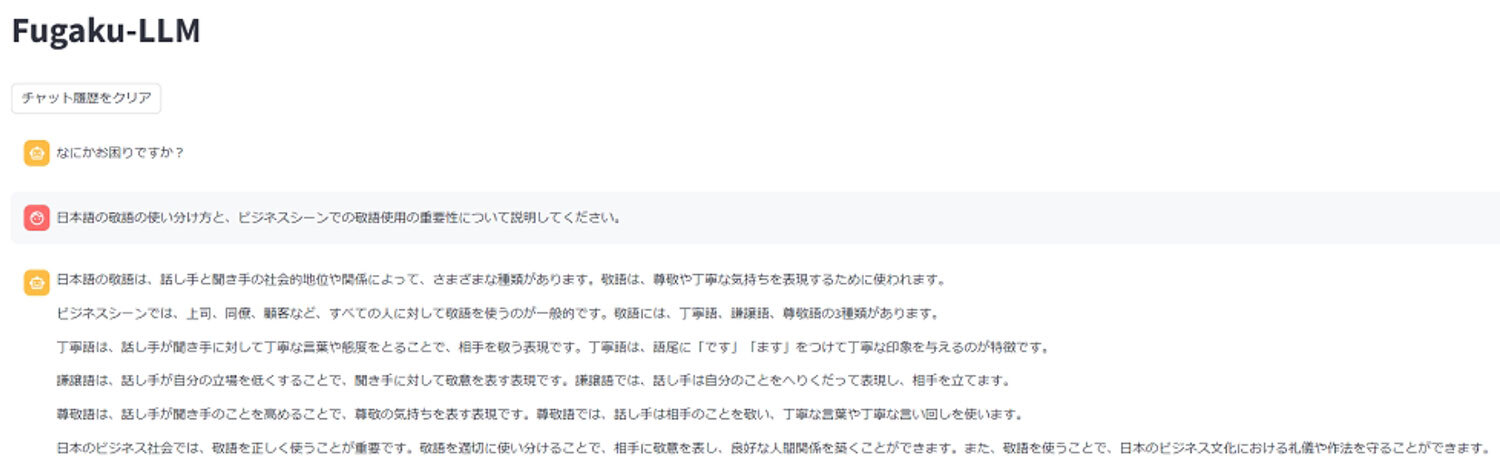

Fugaku-LLMのデモ(出典:富士通)

Fugaku-LLMのデモ(出典:富士通)

※クリックすると拡大画像が見られます

富岳で学習するに当たり、深層学習フレームワークの「Megatron-DeepSpeed」を富岳に移植して、「Transformer」の性能を富岳上で最適化しつつ、密行列積ライブラリーのTransformer向け高速化を実施して、演算速度を6倍に高めた。さらに、3種類の並列化を組み合わせた富岳向けの通信性能最適化と、「TofuインターコネクトD」上で集団通信を高速化したことにより、通信性能も3倍に高めたという。

学習では1万3824台の計算ノードを使用し、約4000億トークンを学習している。学習データの約6割が日本語コンテンツとなっており、そのほかには英語や数学、コードを組み合わせて学習を行ったという。また、日本語対応LLMの多くが国外開発のオープンモデルをベースに日本語データを継続学習させているのに対し、Fugaku-LLMでは上述のように最初から日本語中心の独自データで学習しているため、学習の全学習工程を把握して透明性と安全性を担保しているとのこと。Japanese MT-BenchにおけるFugaku-LLMのスコアは平均5.5、人文社会系のタスクで9.18となっており、敬語など日本語の特徴を踏まえた自然な言語での対話ができることなどが期待されるとしている。

Fugaku-LLMの開発における各組織の役割は以下の通り。

- 東京工業大学:全体総括、LLMの並列化と通信の高速化(3種類の並列化を組み合わせた通信性能の最適化、TofuインターコネクトD上での集団通信の高速化)

- 東北大学:学習用データの収集、学習モデルの選択

- 富士通:演算高速化と通信高速化(TofuインターコネクトD上での集団通信の高速化、パイプライン並列の性能最適化)、事前学習と学習後のファインチューニング

- 理化学研究所:大規模言語モデルの分散並列化、通信の高速化(TofuインターコネクトD上での集団通信の高速化)

- 名古屋大学:3D形状生成AIへのFugaku-LLMの応用方法の検討

- サイバーエージェント:学習用データの提供

- Kotoba Technologies:深層学習フレームワークの富岳への移植

富士通は、世界でLLMの学習にGPUが使われ、GPU不足が課題となっている中で、CPUを用いる国産の富岳を使ってFugaku-LLMを実現したことが、日本の半導体技術の活用や経済安全保障の観点からも重要な成果だと強調。今回の取り組みによる知見は、次世代計算基盤の設計にも活用し得るもので、AI分野での日本の優位性の確立に寄与するとした。

同社は、「多くの研究者や技術者が基盤モデルの改善や新たな応用研究に参画し、効率的な学習方法や言語モデルが創出され、科学シミュレーションと生成AIの連携による科学研究サイクルの自動化のようにAI基盤モデルを科学研究に活用する『AI for Science』や、数千超のAIによるバーチャルコミュニティーの社会シミュレーションなど次世代の革新的な研究やビジネスの成果につながることが期待される」とコメントしている。