(前編はこちら)

GPUにおけるAMDとIntelの動き

GPUでNIVIDAと市場を分け合うAMDは、人工知能(AI)向けに「Radeon Instinct」という製品をリリースし、現在のRedeon Instinctには、「Vega10」アーキテクチャを採用している。

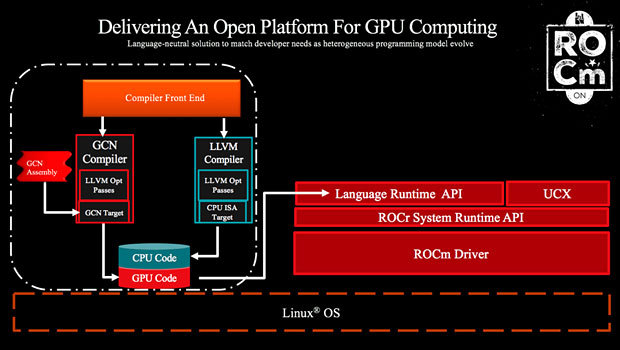

AMDは、NVIDIAの「CUDA」と同じようなソフトウェアライブラリや開発ツール群 の「ROCm(Radeon Open Compute)」を用意し、ROCmには、コンパイラのLLVMやOpenCL、HIP(Heterogeneous Compute Interface for Portability)などのツールがある。これらのツール上でGoogleの「TensorFlow」やFacebookの「Caffe2」などのAI処理フレームワークがサポートされており、AMDのVega10を利用できる。

ただ、NVIDIAに比べると、多くのユーザーがVega10を利用しているとは言い難い。オープンソースで開発しているが、ユーザー数が少ないためか、さまざまなウェブサイトからソフトウェアをダウンロードする必要があるため、セットアップも面倒だ。また、NVIDIAの「Tesla V100」は、AI処理を高速化するためにアーキテクチャをチューニングしているが、AMDのVega10はグラフィック用途が中心となっている。

AI処理という点からいえば、現状ではNVIDIAがライバルの二、三歩先を行っている状況だ。多くのパブリッククラウドでも、GPUを使用したAIサービスではNVIDIAのGPUを使用しているところが多い。例えば、Amazon Web Services(AWS)の深層学習「AMI」ではNVIDIAのTesla V100を使用している。AMDのVegaは、Google Could Platformの一部サービスで使用されている。

AMDは、AI分野でオープンソースのソフトウェアツール群「ROCm」を提供している(ROCmのウェブサイトより)

ROCmはコンパイラだけでなくAIに関するツールもまとめて提供している