人工知能(AI)モデルは進化しており、驚くようなこともできるようになった。しかし、それでもミスをしたり誤った答えを出したりすることがあり、これは「ハルシネーション」(幻覚:AIが事実と異なる情報を勝手に作り出してしまう現象)と呼ばれる。

提供:Userba011d64_201/Getty Images

OpenAIの「ChatGPT」やGoogleの「Bard」といった主要なAIチャットボットはいずれも、こうしたハルシネーションを起こしやすい。OpenAIとGoogleはどちらも、自社のチャットボットが誤った情報を生成する可能性があると明言までしている。

OpenAIは新たな研究論文に関する投稿記事の中で、AIモデルをより論理的に動作させてハルシネーションを回避する方法を発見したかもしれないと述べている。

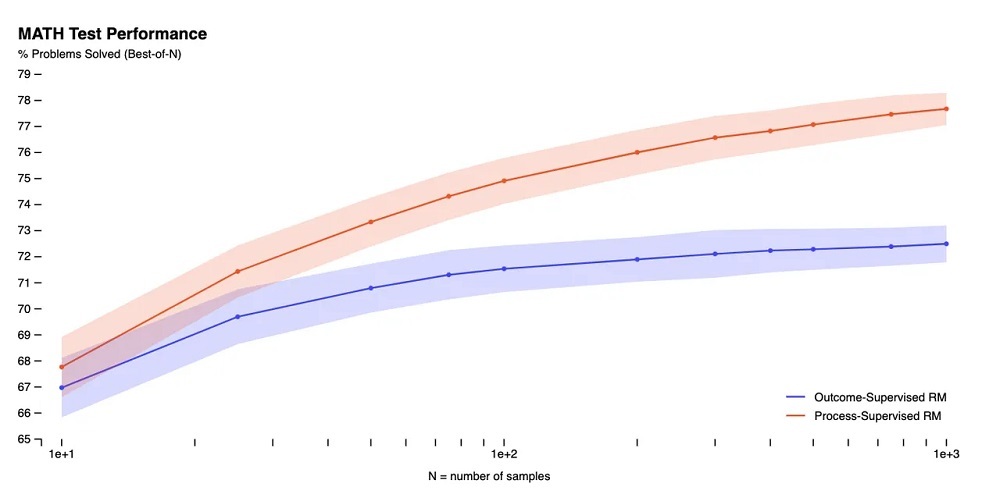

同社は、複雑な数学の問題を解く能力を備えたモデルを「プロセス監視」で学習させた。プロセス監視とは、1つのステップごとにフィードバックを提供する手法だ。これに対し、「結果監視」は最終結果に基づいてフィードバックを提供する。

研究論文によると、OpenAIがMATHデータセットを使って両方の手法をテストしたところ、プロセス監視が「有意に優れたパフォーマンス」につながることが分かったという。

提供:Screenshot by Sabrina Ortiz/ZDNET

「プロセス監視は、人が承認したプロセスに従うようモデルに促すことから、解釈可能な推論を生み出す可能性も高くなる」(OpenAI)

OpenAIは数学以外の分野について、これらの結果がどの程度まで当てはまるかは不明としながらも、他の分野でもプロセス監視の影響を探ることが重要だと述べている。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。