Intelは米国時間11月12日、米サンフランシスコで開催された自社イベント「AI Summit」で、次世代の「Movidius VPU(Vision Processing Unit)」(コードネーム「Keem Bay」)を発表した。この新しいプロセッサーは、競合プロセッサーに比べ最大で6倍の電力効率を誇るという。さらに同社は、深層学習トレーニング用のプロセッサー「Nervana Neural Network Processor for Training(NNP-T)」と、推論用のプロセッサー「Nervana NNP for Inference(NNP-I)」のデモも行った。

Jonathan Ballon氏

提供:Walden Kirsch/Intel Corporation

Intelは、AI用のハードウェア製品とソフトウェアサービスのラインアップを拡充することで、クラウドやデータセンター、エッジにおけるAI活用の市場に切り込む新なチャンスを作ろうとしている。IntelのAI製品グループ担当バイスプレジデント兼ゼネラルマネージャーであるNaveen Rao氏によれば、IntelのAI関連事業の年間売上高は、すでに35億ドル(約3800億円)に達しているという。

IntelがMovidius VPUを発表したのは2017年のことだ。同社のIoTグループ担当バイスプレジデントJonathan Ballon氏は、Keem Bayは2020年の上半期にリリース予定で、独自のアーキテクチャーによって、効率とスループットを向上させたと述べている。

Intelによれば、この次世代VPUのパフォーマンスは、第1世代に比べ10倍になっている。それに加え、Keem Bayの初期テストでは、NVIDIAのSOC「TX2」に比べ、3分の1低い電力消費で4倍以上のRawスループットを達成したという。また、NVIDIAの「Xavier」と比較すると、5分の1の電力消費でほぼ同等のRawスループットを実現した。

Balon氏は、「エッジではもちろんパフォーマンスも重要だ」と述べた上で、「しかし、顧客は電力消費やサイズも気にかけており、遅延も重要になってきている」と付け加えた。

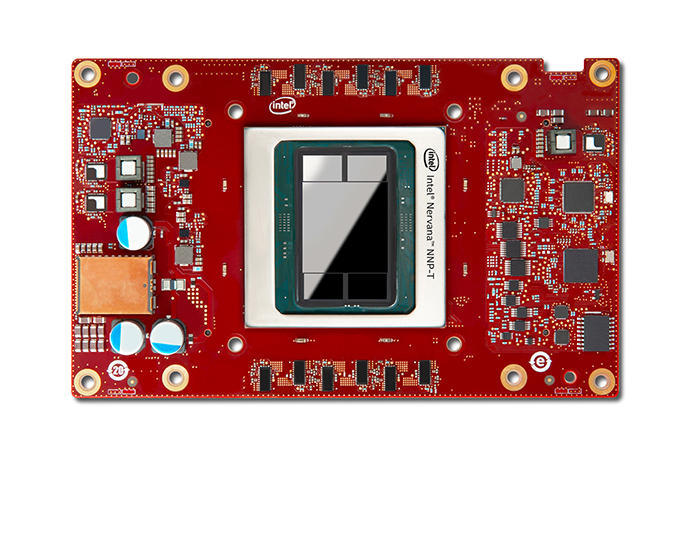

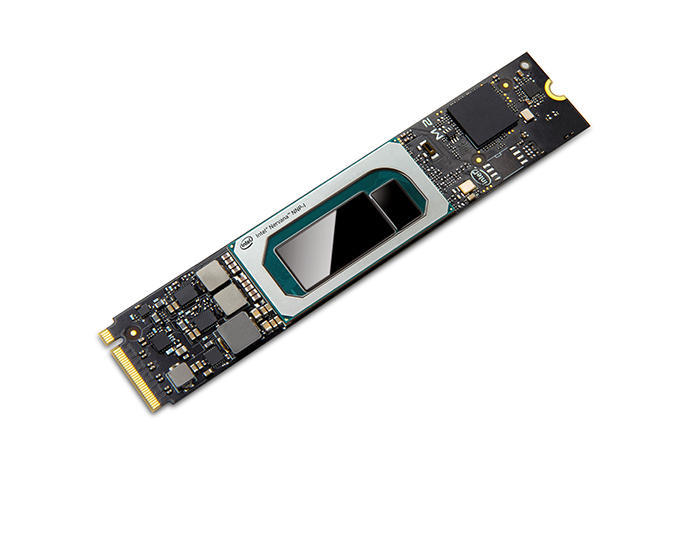

一方、Intelのトレーニング用NNP(「NNP-T1000」)と推論用NNP(「NNP-I1000」)は、同社が初めて提供する、クラウドやデータセンターで複雑な深層学習の処理を行うための専用ASICだ。

Intel Nervana NNP-T

提供:Intel Corporation

NNP-T1000は、現実の深層学習アプリケーションのトレーニングを効率的に行えるように設計されている。

またNNP-I1000は、準リアルタイムで、低遅延の推論を大量に実行できるように設計されている。Intelは最近、アルファテスト前のソフトウェアを使用し、試作品のNNP-Iプロセッサー2基を使って、ONNXを使用し、ResNet-50 v1.5で「ImageNet」の画像を分類したところ、オフライン処理で毎秒1万567枚、サーバーを利用した環境で毎秒1万263枚の画像を処理することに成功したことを示す「MLPerf」の結果を発表している。

NNP-Iは、コンピュータービジョンや深層学習による推論をエッジのビジョンアプリケーションで利用するためのツールキットである「OpenVINO Toolkit」でサポートされる予定だという。

またIntelは、同イベントで、OpenVINOを補完するサービスとして「Intel DevCloud for the Edge」を発表した。このサービスを利用すれば、ハードウェアを実際に購入しなくても、さまざまなIntel製プロセッサーでAIソリューションのプロトタイピングやテストを行うことができる。

Intel Nervana NNP-I

提供:Intel Corporation

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。