こんにちは。日本ヒューレット・パッカードのオープンソース・Linuxテクノロジーエバンジェリストの古賀政純です。最近ちまたでは、人間のように自然な会話ができる対話型AI(人工知能)「ChatGPT」が話題です。音声認識や画像認識、自然言語処理など、世界中でAIの開発が加速しており、その開発基盤にコンテナー技術が活用されています。今回からAIについて取り上げます。第1回は、日本におけるAIの取り組みの歴史とAIの仕組みについて、1990年代からAIに携わってきた筆者が自らの経験を交えつつ簡単に紹介します。

かつて日本にはAIの国家プロジェクトがあった

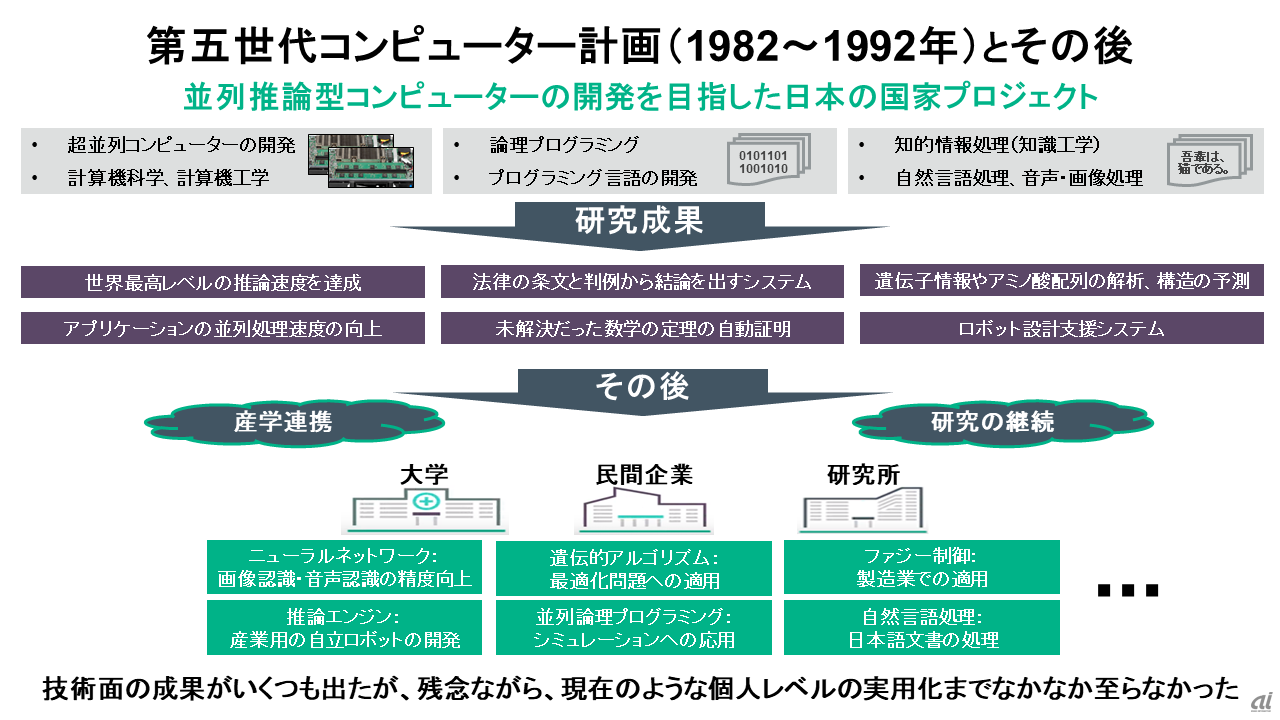

皆さんは、かつて日本にAIに関する国家プロジェクトがあったことをご存じですか。1982年に「第5世代コンピューター計画」と呼ばれる大規模な研究プロジェクトがありました。この国家プロジェクトの目的は、人間のように自然な言葉でコミュニケーションができるAIと、それを稼働させるコンピューターシステムの開発でした。具体的には、1940年代から現在まで変わらないノイマン型コンピューターに取って代わるAI用の超並列型コンピューターシステムとAI用のプログラミング言語の開発、そして、自然言語や音声・画像といった知的情報処理そのもので成果を出すといったものでした。

この国家プロジェクトでは、さまざまな研究成果が生まれました。例えば、法律の条文と判例から結論を出すシステムや、数学の定理を証明することにも成功しました。また、ロボットの設計を支援するシステムや生物の遺伝情報などの解析、構造を予測するシステムなどが開発されました。非常に先進的な取り組みで、目の付けどころも非常に良かったのですが、残念ながら一般に広く利用されるレベルでの実用化まで至ることはありませんでした。国家プロジェクトとして大規模な予算を投じたにもかかわらず、結局、一般人が手軽に使えるAIを実用化できなかったことから、日本の社会や企業の関心も薄れてしまい、1992年にプロジェクトは終わりを迎えます。

第5世代コンピューター計画が終わりを迎えつつあった1991年以降、バブル崩壊後の日本のメーカーやサービス事業者で価格競争が一層激化し、モノやサービスを他社よりもいかに安く提供するかにしのぎを削っていました。価格競争に勝ち残るため、多くの企業は製造費や人件費を抑えることに頭を悩ませ、これ以上価格を低くすると利益が出なくなるといった、いわゆる「コスト削減の負のスパイラル」に苦しんでいました。

そのような負のスパイラルに陥った状況を打開しようと、日本ではITを使ったオートメーション(自動化)の研究、開発が進みました。今のような企業全体の事業改革や新規ビジネス開拓のためのデジタルトランスフォーメーション(DX)というより、定型業務のIT活用による大幅な自動化とコスト削減に企業は大きく傾倒しました。そのため、「海のものとも山のものとも分からないような人工知能とやらに割く予算などない」と言われても仕方がなかったわけです。

一方、日本の大学や大手の研究所では、「第5世代コンピューター計画」の成果を生かしつつ、計算機工学、演算回路工学、知識工学、情報理論、人工知能などを含む「知能情報工学」の分野で研究が引き継がれました。筆者がAIに携わっていた1990年代中ごろは第2次人工知能ブームの末期で、理論だけでなく既に工学的な領域での応用のためのAI研究も各大学で行われていました。

具体的には、生物の脳神経の挙動を模倣した「ニューラルネットワーク」や、専門家の知識を取り入れてコンピューターに意思決定を代替させる「エキスパートシステム」、生物の遺伝子の交配や突然変異の仕組みを模倣することで最適解を見つける「遺伝的アルゴリズム」などが国内外問わず研究されていました。これらの知的情報処理の研究は、大学や企業の研究機関などで継続され、何とか知的情報処理を武器にしようとする国や大学、先見性のある民間企業の研究開発部門の取り組みもあり、官民連携でのAI技術の研究が粛々と行われていました。

1990年代のAIソフトウェア開発は苦労が絶えなかった時代

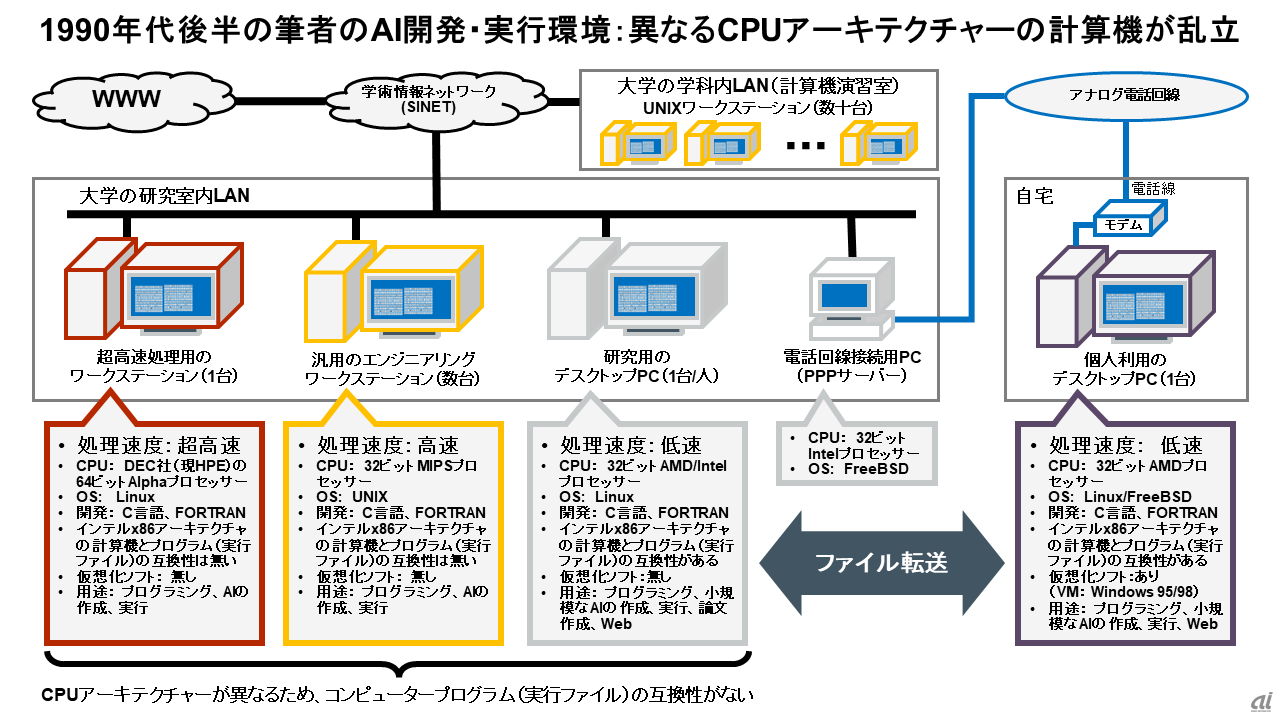

1990年代、日本の理工系の大学では、PCよりも高性能なデスクトップ型の計算機であるワークステーションが大量に導入されていました。筆者の大学で採用されていたワークステーションは、「MIPS」アーキテクチャーの32ビットCPUを搭載し、OSには商用UNIXを採用していました。理工系の大学では、広く普及していたものです。筆者は、このUNIXワークステーションのテキストエディターベースの開発環境で、「C」や「FORTRAN」と呼ばれるプログラミング言語を駆使し、人間の脳の働きを模倣したニューラルネットワークなどのAIのコンピュータープログラムを作成していました。

当時、ニューラルネットワークのコンピュータープログラムは、既に一般の理工系の書籍でも掲載されており、大学生や研究者などで利用されていましたが、現在広く利用されている「Python」と呼ばれるプログラミング言語を使ったAI用のプログラムの部品もなく、CやFORTRANを使って、自力でAIのプログラムを一から書かなければなりませんでした。Intelアーキテクチャー(x86)を搭載した低速PCに比べて高性能なUNIXワークステーションでAIを動かせたとはいえ、それでもAIを実行するには処理速度が非常に遅く、便利な「Docker」コンテナーの実行基盤もなかった時代です。

また、当時はMIPSプロセッサーよりもさらに高速なDigital Equipment Corporation(DEC、現Hewlett Packard Enterpriseの一部)の64ビット「Alpha」プロセッサーを搭載したワークステーションも普及していました。特にAlphaプロセッサーを搭載したワークステーションは、商用UNIXとLinuxを両方サポートしていたため、Linuxで動作する開発環境のソフトウェア資産を活用できる点で重宝されました。

筆者の大学の研究室も、32ビットのMIPSプロセッサーを搭載したUNIXマシンが数台と、64ビットのAlphaプロセッサーを搭載した超高速のLinuxマシンが1台、そして非常に低速な32ビットのx86プロセッサーを搭載したデスクトップPCを個人所有していました。さらに、学術情報ネットワークを通じてインターネットにも高速接続が可能という、1990年代の大学生にしては非常に恵まれた開発環境でした。普段は低速なPCやUNIXマシンでコーディングし、AIの実行は超高速マシンで行うこともありました。

しかし、MIPS、Alpha、IntelのCPUアーキテクチャーごとに、コンピュータープログラムのソースコードの書き方やコンパイル(ソフトウェアの設計図となるソースコードから実行ファイルを生成すること)の最適化の手法も異なるため、それらの異なる種類のCPUアーキテクチャーやOSを使いこなすことにかなり苦労した記憶があります。

1990年代末期には、IntelアーキテクチャーのPC上で動く仮想化ソフトウェアが登場し、OS環境をファイルとして保持できるようになり、AIの開発環境を迅速に用意できることに大きな期待が寄せられました。筆者も、AIやシミュレーションのプログラミング環境として一時期利用していましたが、当時の仮想化ソフトウェアは物理マシンで直接ソフトウェアを動かす場合に比べて性能劣化が大きく、AIの実行環境として使い物になるレベルではありませんでした。結局、高速処理が可能な非IntelアーキテクチャーのUNIXマシンやLinuxマシンを使わざるを得ませんでしたが、仮想化を使わない物理マシン環境であっても、AIの作成や実行には膨大な時間がかかっていました。

AIにおける処理時間の観点では、与える問題の難易度に大きく依存するので一概には言えませんが、誤解を恐れずに言うと、例えば現在のChatGPTとの対話や滑らかな音声会話、動画内の物体認識などを当時の手作りのAI環境で学習・実行しようとすると、応答結果が得られるまでに数日、数週間、下手すると数カ月になる恐れもあります。それを想像すると、何となく当時のAI開発に対する絶望感が理解できるかと思います。

脳を模倣した知的情報処理ができるコンピュータープログラムといっても、結果を得るまでにとんでもなく時間がかかる「厄介者」なわけですから、美しい理論体系やアイデア、UNIXやLinuxの使いやすいプログラミング環境があっても、「AIって本当に使い物になるの?」と誰もが疑い始めるわけです。そのため、企業の開発部門でもAIの実用化は困難と感じ、複雑な質問に回答できる人間のような脳を製品に実装することは、「価値があるし期待は大きいが、正直諦めざるを得なかった」というのが当時の実情だったのです。

図1.第5世代コンピューター計画が終了した1992年以降もAI技術の研究が行われた。筆者がAIに携わっていた1990年代の第2次人工知能ブームは、既にAIの研究に関する産学連携もあった。しかし、残念ながら個人が求める使いやすいレベルの実用化まで到達できなかった

図1.第5世代コンピューター計画が終了した1992年以降もAI技術の研究が行われた。筆者がAIに携わっていた1990年代の第2次人工知能ブームは、既にAIの研究に関する産学連携もあった。しかし、残念ながら個人が求める使いやすいレベルの実用化まで到達できなかった

図2.1990年代後半における筆者のAI開発・実行環境では、異なるCPUアーキテクチャーの計算機が乱立し、今のような便利なx86ベースのコンテナー技術もなかったため、AIのプログラムは異なるアーキテクチャーの計算機に合った形で作成、実行していた

図2.1990年代後半における筆者のAI開発・実行環境では、異なるCPUアーキテクチャーの計算機が乱立し、今のような便利なx86ベースのコンテナー技術もなかったため、AIのプログラムは異なるアーキテクチャーの計算機に合った形で作成、実行していた