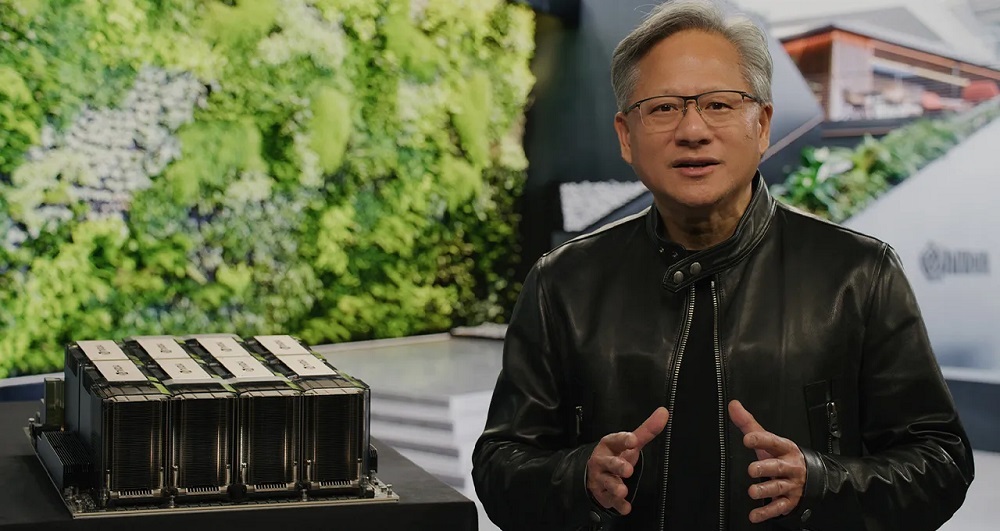

NVIDIAの共同創業者であり、最高経営責任者(CEO)のJensen Huang氏は米国時間3月21日、20日から開催されている「NVIDIA GTC」カンファレンスの基調講演で、2種類の新たな人工知能(AI)用GPUと4種類のプラットフォームを発表した 。同氏はその際、OpenAIの「ChatGPT」が話題になっていることについて、AI分野における「iPhone登場時のような革命的瞬間」だと表現した。

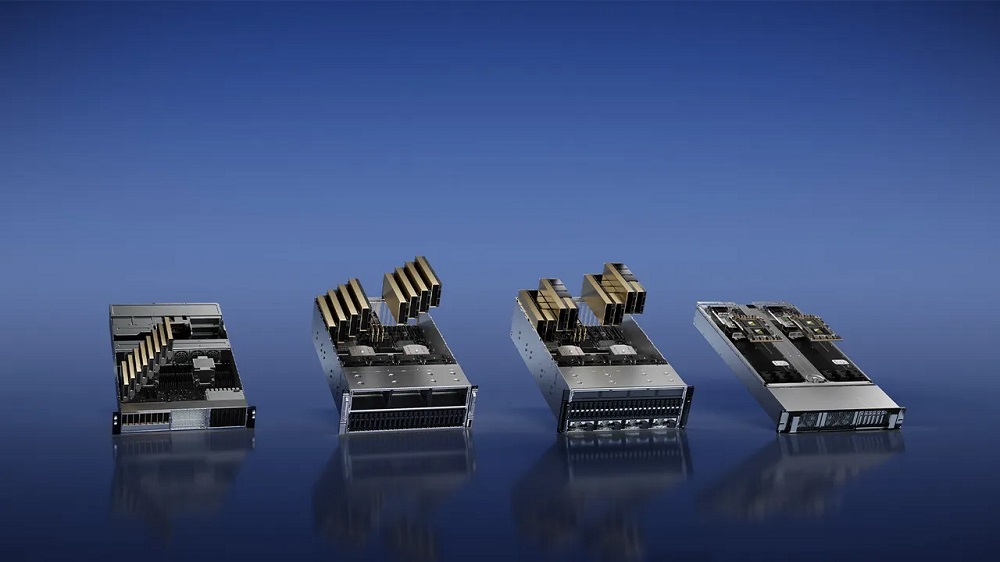

提供:Nvidia

新しいプラットフォームの1つである「NVIDIA H100 NVL for Large Language Model Deployment」は、大規模言語モデル(LLM)における「推論タスク」の処理に特化している。LLMは、ChatGPTといった自然言語処理プログラムで利用されている。

推論タスクとは、訓練済みの機械学習(ML)プログラムが展開された後に用いられる、いわば第二段階のタスクであり、その実行によって推論処理が実行される結果、質問に答えられるようになる。

NVIDIAによると、H100 NVLは94GBのメモリーを搭載しているという。また、同社の「Transformer Engine」により、「データセンター規模のシステムで比べた場合、『GPT-3』の推論速度は前世代の『NVIDIA A100』よりも最大12倍高速化される」という。

今回の製品は、Intelと対抗するためのものだという見方もできる。同社は、ChatGPTなどのMLプログラムを開発する際の最初の段階、すなわち「訓練」段階で覇権を握っているが、IntelのサーバーCPUである「Intel Xeon」ファミリーは推論タスクにおいて長きにわたって主流となっている。

NVIDIAによると、新たに発表された2種類のGPUである「NVIDIA L4 Tensor Core」と「NVIDIA H100 NVL」のうち、H100 NVLは「2023年の後半」に一般提供を開始する予定だという。

今回発表された「NVIDIA L4 for AI Video」というプラットフォームは、「CPUと比較するとAIによる動画性能は120倍であり、電力効率は99%向上する」という。

提供:Nvidia

同社は、L4プラットフォームが最初に搭載されるのは、「Google Cloud」が現在プライベートプレビュー版として提供している「G2」仮想マシン上だと述べた。またL4は、GoogleのMLプラットフォーム「Vertex AI」に統合されるという。

L4はGoogle以外にもAdvantechやASUS、Atos、Cisco Systems、Dell Technologies、富士通、Gigabyte Technology、Hewlett Packard Enterprise(HPE)、Lenovo、QCT、Supermicroといった30社を超えるコンピューターメーカーのシステムで利用できる。

Huang氏の基調講演では、ChatGPTを開発した新興企業のOpenAIに対する言及が随所でなされていた。Huang氏は2016年に初めて「NVIDIA DGX」システムを自ら発表している。そしてOpenAIは「Microsoft Azure」クラウド上でH100を用いてAI研究を強化する予定だという。

NVIDIAのCEO、Jensen Huang氏

提供:Nvidia

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。