ブラウザー「Opera」のユーザーにうれしい新機能が発表された。デバイス上で完全にローカルな形でOperaから利用できる大規模言語モデル(LLM)だ。

Opera Softwareの発表によると、ユーザーがLLMをダウンロードし、内蔵機能を通じてローカルで使えるのは、主要ブラウザーでは初めてだという。これにより、サーバーにデータを送信することなくOperaでLLMを利用できる。この機能は、「AI Feature Drops Program」の一環として、「Opera One」の開発者向けストリームで提供される。AI Feature Drops Programとは、実験的な人工知能(AI)機能をアーリーアダプターがテストできるプログラムだ。

利用できるLLMは、Googleの「Gemma」、Mistral AIの「Mixtral」、Meta Platformsの「Llama」、オープンソースの「Vicuna」などで、合計すると約50系統150種類のLLMが利用できる。

Operaによると、各LLMの容量は2GBから10GBで、専門化されたLLMほど必要な容量が少ないという。また、ハードウェアの演算能力にもよるが、ローカルのLLMはサーバーベースのものよりも処理速度かなり遅くなる可能性があるため注意が必要だという。

Operaはおすすめのモデルをいくつか挙げている。「Code Llama」はコードの生成と検討を目的にLlamaを拡張したものだ。Mixtralはテキスト生成や質問への回答などの自然言語処理タスクに幅広く対応している。Microsoft Researchの「Phi-2」は、「推論と言語理解で抜きんでた能力を示している」言語モデルだという。

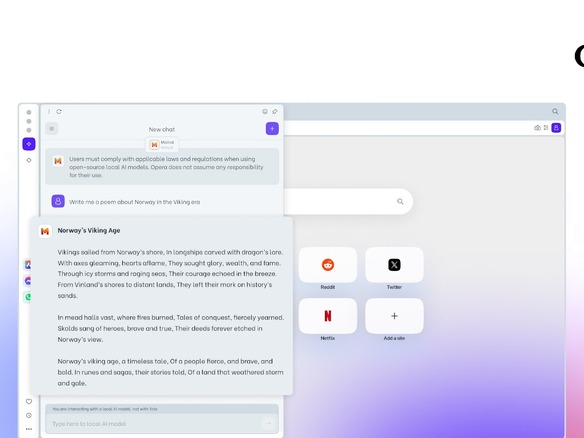

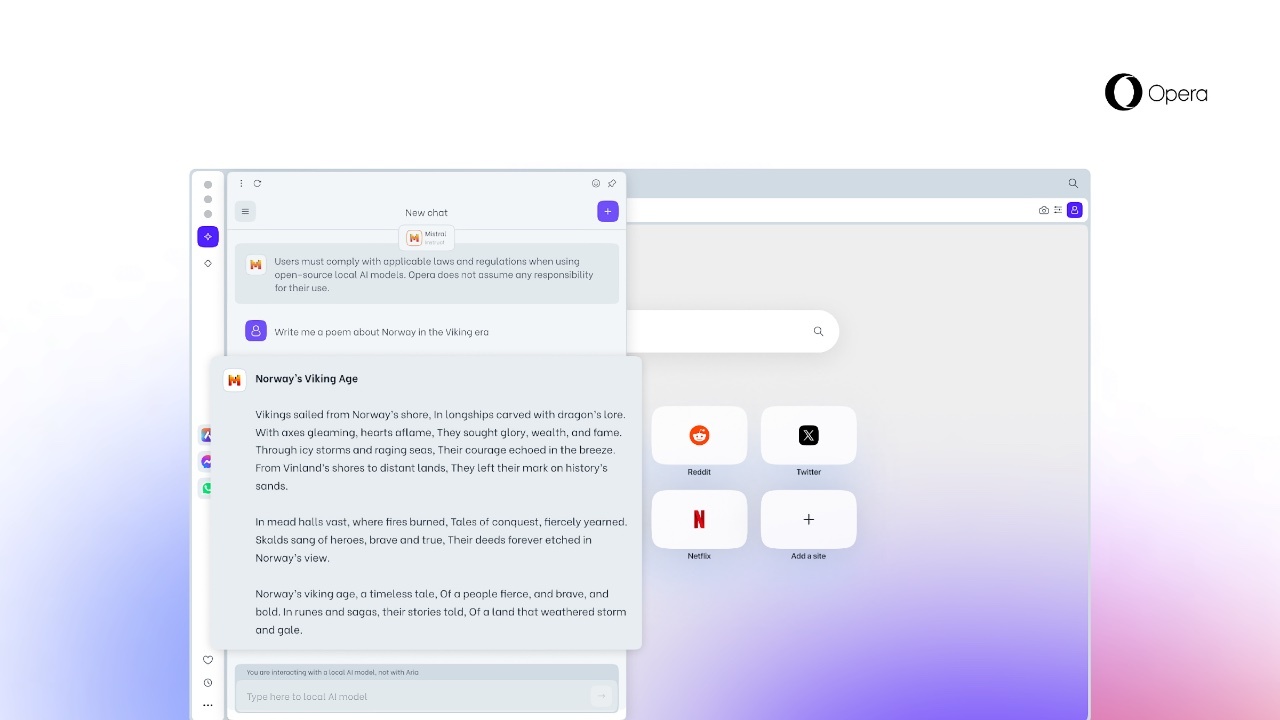

今回の機能を試すには、開発者向け「Opera One developer」の最新版にアップグレードする必要がある。アップグレードしたら、サイドパネルのAIチャット「Aria」を開き上部のドロップダウンボックスで「ローカルAIモデルを選択」(choose local mode)を選ぶ。次に「設定に移動」(Go to settings)をクリックしてから、ダウンロードしたいモデルを探す。選んだLLMがダウンロードされたら、左上にあるメニューボタンをクリックして、新しいチャットの開始を選ぶ。すると、ダウンロードしたモデルを選択してチャットを始められる。

OperaのネイティブなAIであるAriaに戻すまで、選んだLLMがAriaの代わりを務める。

提供:Opera

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。