Microsoftは米国時間5月21日、年次開発者会議「Microsoft Build」で、「Azure AI Speech」サービスの新機能を発表した。これらの新機能は、音声に対応した生成人工知能(AI)アプリの開発を強化するものだ。

MicrosoftのリリースではAzure AI Speechについて、すでに「通話分析(音声とテキスト)、医療文字起こし(音声、画像、テキスト)、キャプション作成(音声/映像、文字起こし、翻訳)、チャットボット(音声、GPT)など、さまざまなユースケース」で利用されているとしている。また、放送や配信用のキャプションを音声から作成したり、通話の中で出てきた住所を抽出したりするなど、現時点でも多くの機能を備えている。

OpenAIが13日に発表した「GPT-4o」の目玉の1つは「Voice Mode」の改善で、プログラムの応答に使われる音声の品質向上に焦点を当てたものだった。このアップデートに後れを取るまいと、Microsoftは「パーソナル音声」機能を一般提供することを明らかにした。

この機能により、ユーザーは「音声アシスタント、音声認識、音声コンテンツ作成など、さまざまな用途で独自のAI音声を作成し、利用できるようになる」と、Microsoftはリリースで説明している。

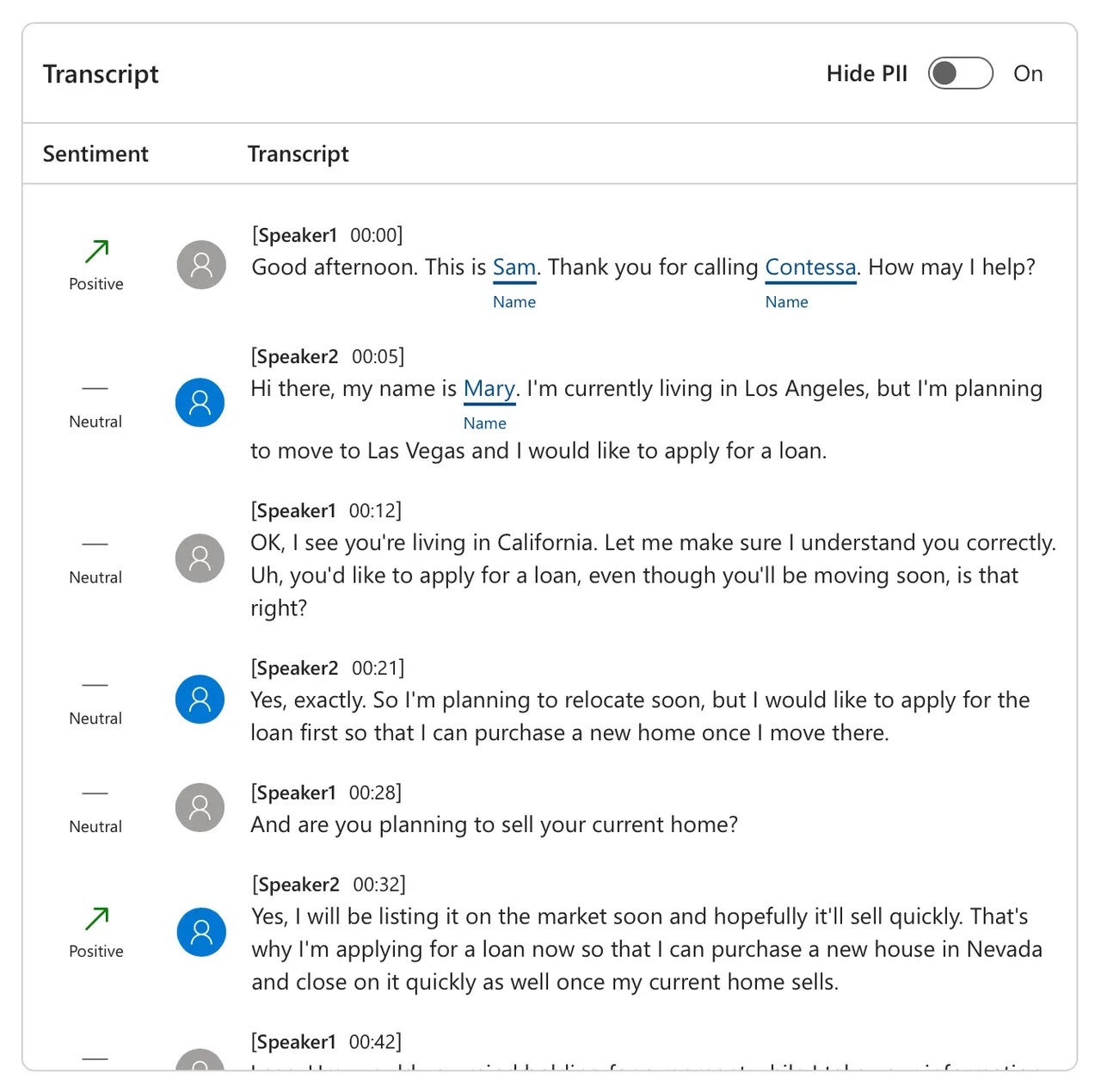

もう1つの新機能は音声分析で、まずプレビュー版として提供される。この機能は「Azure」の開発環境「Azure AI Studio」内で利用でき、同社が「ソフト」分析と呼ぶ機能に対応するものだ。通話内容のソフト的な要素としては、意味の解釈や話者の感情などが挙げられるが、いずれも通話内容そのものと比べて捉えにくい要素と言える。

センチメント分析では、「示された共感の度合い、参加者の関与、主張の強さといった情報を細かく検出できるだけでなく、今後の会話の流れを予測できるようになる」と、リリースには書かれている。

例えば、通話記録では各話者の言葉遣いが「肯定的」「否定的」「ニュートラル」のいずれであったかを発言ごとに評価できる。詳しくは、こちらのインタラクティブデモを見てほしい。

また、素早い分析を可能にするために、Microsoftは「Fast Transcription」(高速文字起こし)機能も導入する。この機能は「リアルタイムより40倍速い(リアルタイム係数<1)文字起こしを可能にする」ため、「文字起こし作業そのものに大きな変革をもたらす」と、同社は主張している。

Microsoftによれば、Fast Transcriptionのおかげで、コールセンターのスタッフは通話中に手書きでメモを取る必要がなくなり、「数千時間」を節約できるほか、医師や看護師は患者との会話を数秒で分析できるようになるという。さらに、「メディアやコンテンツ制作者は、ポッドキャストやインタビューの収録を終えたらすぐに分析に取りかかり、インサイトを抽出できる」と、同社はリリースの中で述べている。

Microsoftによれば、この機能は6月から利用可能になる予定だという。

顧客との通話後に会話内容を分析している画面の例

提供:Microsoft

また、コンテンツを世界中に発信したいというニーズに対応するため、Microsoftは動画の自動吹き替え機能の導入を予告した。この機能は、コンテンツを翻訳するだけでなく、翻訳した言語で音声を作成し、動画の話者に合わせて声を吹き替えるというものだ。

さらに同社は、多言語翻訳機能のアップデートも発表した。例えば、動画を視聴しながら字幕の言語を切り替えることが可能になるという。

提供:SOPA Images/Contributor/Getty

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。