Googleは5月に開催したイベント「Google I/O」で、自社開発の第2世代「Tensor Processing Unit」(TPU2)を発表して以降、この製品については数枚の画像を公開しただけに留まっていた。

しかしThe Registerの報道によると、Google BrainチームのJeff Dean氏は、先週に米カリフォルニア州ロングビーチで開催されたNeural Information Processing Systems(NIPS)カンファレンスで、TPU2に関するプレゼンテーションを行った。

同氏は5月に、初代のTPUは機械翻訳やコンピュータ囲碁プログラム「AlphaGo」の処理、検索、画像認識などの機械学習モデルを効果的に実行することに特化しており、推論やトレーニング済みモデルの実行に適していると説明していた。

しかし、より負荷が高い処理であるモデルのトレーニングについては、高性能なGPUやCPUを使用して別途行う必要があった。この機材を使ったトレーニングには数日から数週間かかり、研究者が複雑な問題に取り組むことを妨げていた。

しかしTPU2はこのボトルネックを解消するため、トレーニングと機械学習モデルの実行の両方に使用されることを前提に設計されたという。

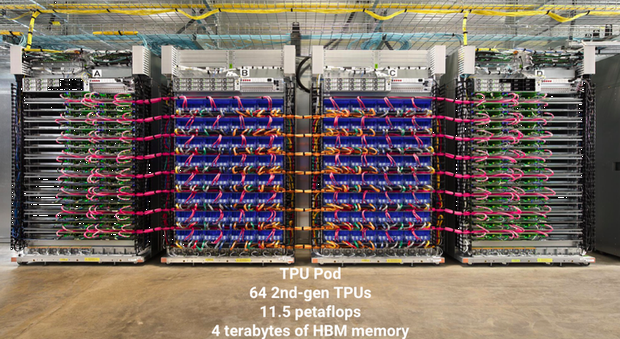

Googleは180テラフロップスの処理能力を持つTPU2を、専用の高速ネットワークで接続した「TPU pod」を構築した。TPU2に販売予定はなく、今後TPU podはGoogle Cloud経由で提供され、TensorFlowを使ったプログラムで利用できるようになるという。

提供:Google

Dean氏のプレゼンテーションでは、TPU podやTPU2のユニット、TPU2チップの設計に関する詳しい情報も公開された。

TPU podは64個のTPU2から構成されており、11.5ペタフロップスの処理能力と4テラバイトの広帯域メモリを備えている。一方、TPU2の各ユニットは4基のTPU2チップから構成されており、180テラフロップスの処理能力、64Gバイトの広帯域メモリ(2400Gバイト/秒)を持つ。また、各TPU2チップは、それぞれ8Gバイトの広帯域メモリを持つコアを2つ搭載しており、1チップあたり16Gバイトのメモリを持っている。

Googleは今後「TensorFlow Research Cloud」経由で、オープンな機械学習研究を進める研究者に1000個のTPU2を無料で提供する計画だという。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。