グラフコア・ジャパンは3月17日、2016年から英本社Graphcoreが開発する機械学習に特化したチップ“Intelligence Processing Unit(IPU)”の最新モデルとなる「Bow IPU」の説明会を開催した。

グラフコア・ジャパン 代表取締役社長 中野守氏

昨今は機械学習や深層学習の需要が高まり、より高速に演算できるプロセッサーが必要とされている。IPUについて同社 代表取締役社長 中野守氏は、「ニューラルネットワークとして、LSTM(Long Short Term Memory)などを使用する株価予測やリスク分析といった時系列予測を高速に処理する金融業で優位性を発揮する」と解説する。

同社は2021年1月に設立した日本法人の事業展開について、2022年2月に発表したNECとの提携など順調にビジネスが推移していると強調した。現在の国内販売代理店は、HPCシステムズ、SCSK、ScaleWorX、NECの4社が務める。

「アプリケーション性能は3~4割向上」

端的にIPUの役割を説明すると、機械学習に特化したプロセッサーである。汎用的なCPUや描画演算向けのGPUでは、加速的に拡大する演算変数の処理に追いつかず、2016年に創業したGraphcoreの活動は注目を集めてきた。なお、IPUは同社が命名した独自名称であり、次に紹介する製品名称も「(ロンドン・タワーハムレット自治区内の)郊外にある街が由来」(中野氏)である。

今回発表したBow IPUは、2018年の「Colossus GC2」、2020年の「Colossus GC200」に続く第3世代にあたるものの、中野氏は「第3世代ではない。あくまでも第2世代の改良版」と紹介した。

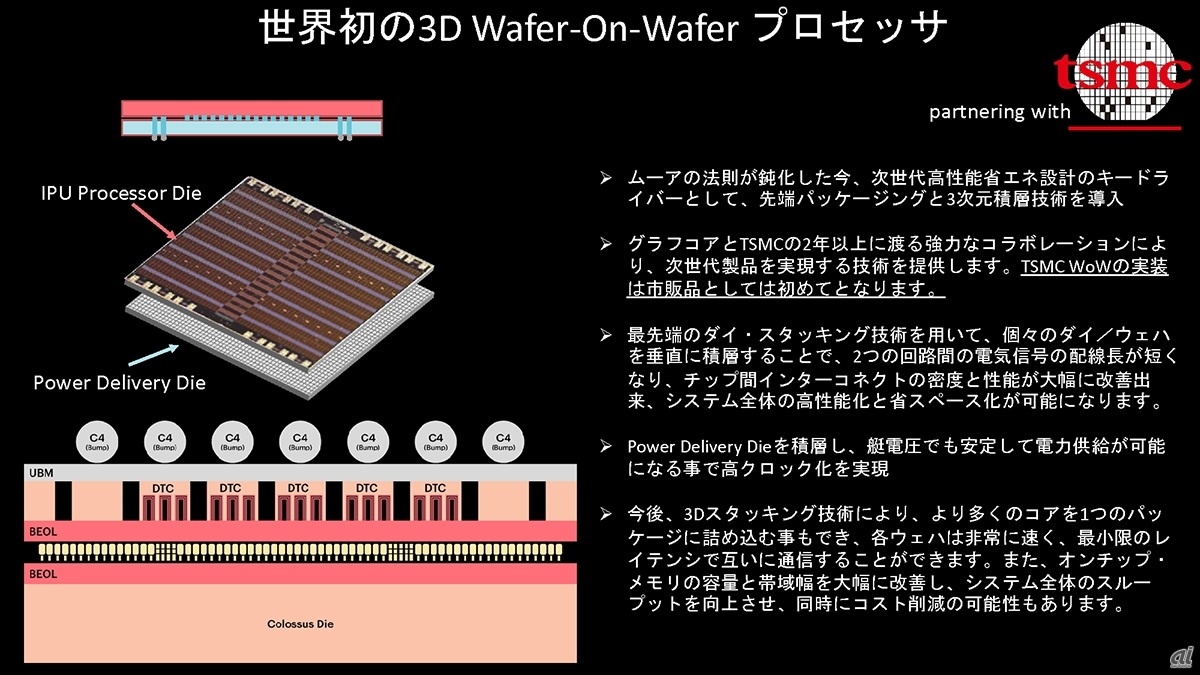

その理由は第2世代・第3世代でプロセッサーのトランジスター数は同等ながらも、「3D WoW(Wafer-On-Wafer)」と呼ばれる技術で最大40%高い性能と16%高い電力効率を実現しているからだという。IPUプロセッサーの下部に、台湾のファウンドリー大手の台湾積体電路製造(Taiwan Semiconductor Manufacturing:TSMC)と連携して開発したフィルムサイズの通電用ダイとなるPower Delivery Dieを用意することで電源効率を最適化していると説明する。

3D WoWの概要

3D WoWの概要

※クリックすると拡大画像が見られます

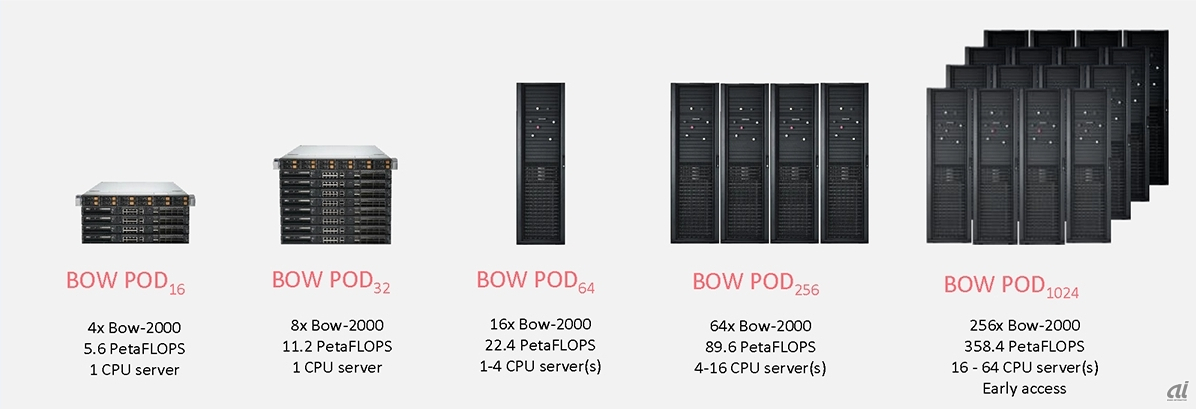

たとえばフラッグシップモデルの「Bow Pod256」はブレードサーバー「Bow-2000」を64基搭載し、演算性能は89.6ペタFLOPSに達した。256基のBow-2000を搭載する、358.4ペタFLOPSの性能を持つスーパースケールコンピューター向けの「Bow POD1024」など5種類のシステムを用意する。

BOW PODシリーズはメモリーを内蔵したコンピュートインメモリー構成のため、 メモリー性能も65テラビット/秒に達し、「プロセッサーとメモリーバンド幅の相乗効果により、アプリケーション性能は3~4割向上」(中島氏)するという。

最新のBOW PODシリーズ

最新のBOW PODシリーズ

※クリックすると拡大画像が見られます

Graphcoreが「Bow POD16」×4構成(約15万ドル)と、NVIDIAのGPUサーバー「DGX A100」(640GBモデル、約30万ドル)の性能を画像認識モデルである「EfficientNet B4」でベンチマークした結果、処理時間はDGX A100が70.5時間、POD16が14.1時間と約5倍の高速化を確認。コスト差が生じるため、「最大10倍(差だった)。国内でも4~6倍の事例を確認している」(中野氏)という。

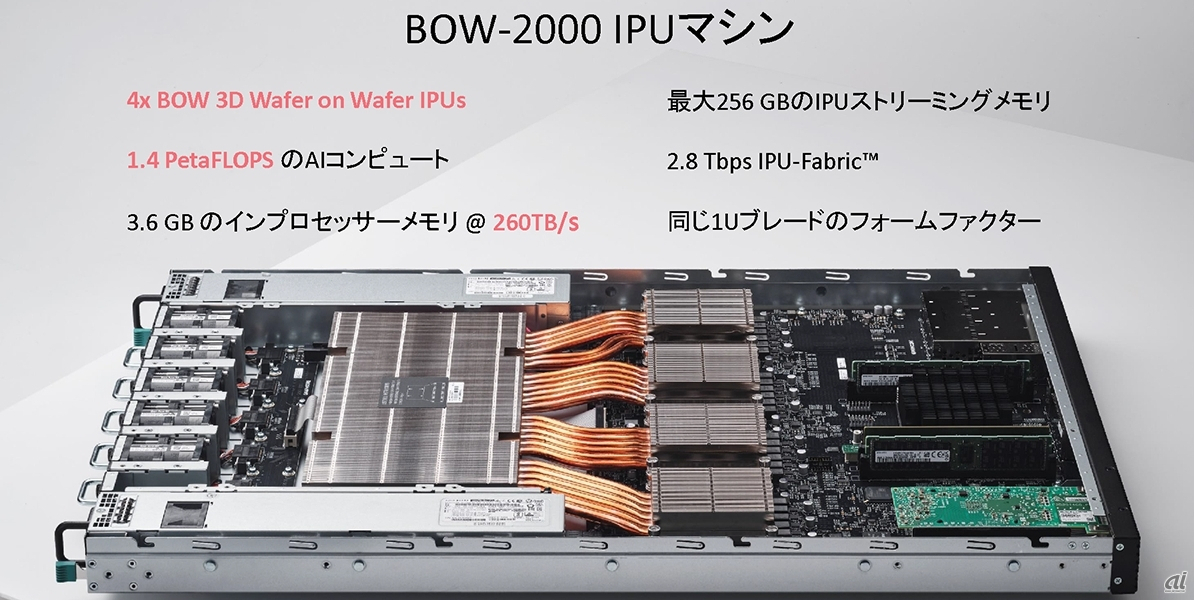

Bow-2000の構成

Bow-2000の構成

※クリックすると拡大画像が見られます

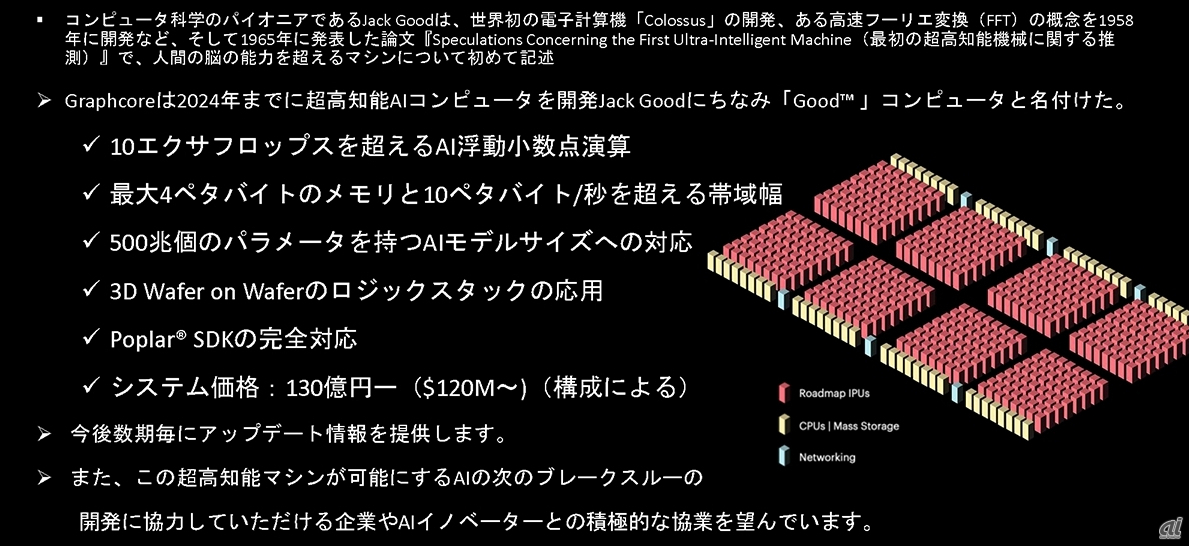

グラフコア・ジャパンの主力製品はBow PODシリーズだが、Graphcoreはコンピューター科学で著名なJack Good氏をなぞった「GOODコンピューター」の開発に着手した。機械学習の展望について中野氏は「人間の脳は約1000億個の神経細胞があり、(機械学習で扱う)パラメーターは100兆を超える。GOODコンピューターは概念レベルだが、2024年までに実現する目標を発表」したという。

GOODコンピューターの概要

GOODコンピューターの概要

※クリックすると拡大画像が見られます