筆者はここ1カ月ほど、「ChatGPT」にさまざまな課題を与えてその能力を調べる記事を何本も書いてきた。その中には、「スタートレック」のエピソードの続編を書かせるものや、「WordPress」のプラグインのコードを書かせるものもあった。驚くべきことに(正直に言えば、恐ろしいほどに)、ChatGPTは筆者が与えたすべての課題に十分に応えてくれた。もしChatGPTが筆者の学生の1人であれば、どの課題でもBの成績が取れただろう(訳注:米国の学校の成績は一般的にA、B、C、D、Fの5段階で評価される)。

提供:Photo by Smith Collection/Gado/Getty Images

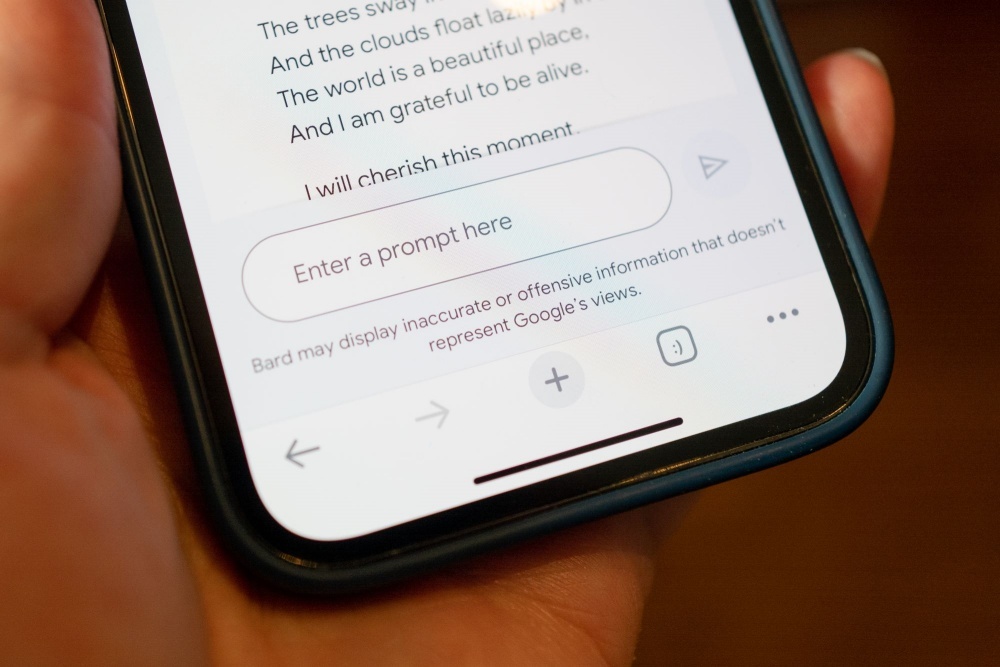

最近になってこの分野にGoogleが参入し、同社のチャットボットである「Bard」も試せるようになった。今回、GoogleからBardのベータ版へのアクセス権を得ることができたので、BardにもChatGPTと同じテストを受けさせてみることにした。

残念ながらBardは、ChatGPTのように常にBの成績が取れる訳ではないかもしれない。米ZDNetのSabrina Ortiz記者が、Bardが使えるようになるとすぐにさまざまなテストを行ったのだが、残念ながらその結果は芳しくなかった。その記事のタイトルが『グーグルの「Bard」を試す--今のところ「ChatGPT」の方が優秀か』というものだったことを考えれば、その内容は推して知るべきだろう。

とは言え、Bardのほうが優れている分野があるかもしれない。そこで筆者は、BardとChatGPTを比較していくことにした。その手法としては、Bardに対し、過去にChatGPTに入力したのとまったく同じプロンプトを入力し、その結果を比較するというやり方を取りたい。一連のテストが終わったら、その結果を表にまとめ、2つのAIを横に並べて包括的に評価できるようにしたいと考えている。

まずは、すでにうまく行かないことが分かっている部分から始めよう。