「ChatGPT」に対して、ソフトウェア工学関連の質問(プロンプト)を投げかけない方がよいという調査結果が新たに発表された。

提供:June Wan/ZDNET

人工知能(AI)チャットボットが台頭してくるまで、「Stack Overflow」というフォーラムは、プログラマーが自らのプロジェクトで抱えている問題の解決策を求めるために最初に頼る場所になっていた。このフォーラムは、質問に対して回答が返されるという点でChatGPTのモデルとよく似ている。

しかしStack Overflowの場合、ChatGPTとは異なり、誰かが質問に回答してくれるのを待つ必要がある。

このため、ソフトウェア関係のエンジニアやプログラマーの多くがChatGPTに頼るようになった。しかし、ChatGPTがこの種のプロンプトにどれだけ有効に回答できるかというデータは存在しなかった。このような状況を受け、米インディアナ州のパデュー大学の研究者らは今回の調査に取り組むことになった。

研究者らは、ChatGPTがソフトウェア工学関連のプロンプトに対してどれだけ効率的に回答できるかを明らかにするために、Stack Overflowに寄せられた517件の質問をChatGPTに与え、回答の正確さと品質を評価した。

その結果、517件の質問のうちChatGPTによる回答が正しくないと判断されたのは52%の269件に上り、正しいと判断されたのは48%の248件しかなかった。さらに、冗長な回答は77%にも達していた。

正しくないと判断された回答は数多くあったものの、返ってきた回答の65%は包括的であり、質問のすべての観点に取り組んでいた。

研究者らはChatGPTの回答品質をさらに分析するために、プログラミングに関する知識レベルが異なる12人に協力を依頼し、これらの回答についての洞察を求めた。

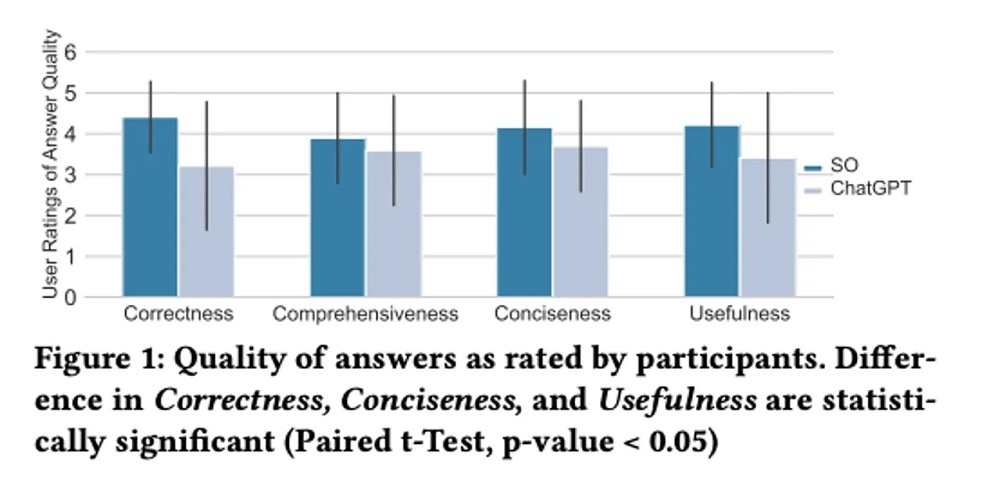

その結果は下記のグラフが示すように、さまざまなカテゴリーを通じてChatGPTの回答よりもStack Overflowの回答の方が優れていると判断された。また、ChatGPTの正しくない回答を、不正確だと見抜けなかった確率は39.34%だった。

提供:Purdue University

今回の調査によると、この協力者らはChatGPTが返す明快な応答により、回答に含まれている誤った情報を見落としていたという。

研究者らは、「協力者らは、ChatGPTの回答における包括的で明快、そして人間のような洞察により、その回答に含まれていた不正確な情報を見落としてしまった(39.34%)」と記している。

もっともらしく聞こえるが間違った回答を生成するというのは、誤情報の拡散につながるという点で、全てのチャットボットが抱えている重大な懸念だと言える。こうしたリスクに加え、回答精度の低さを考えた場合、ChatGPTをこの種のプロンプトで使用することは考え直したほうがよいだろう。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。