生成型の人工知能(AI)モデルに関連する大きな問題の1つに、AIによるスクレイピングがある。AIスクレイピングとは、AI企業が自社のAIモデルを訓練するという名目で、インターネット上のデータを所有者の許可を得ずに取得するという行為だ。

提供:ChamilleWhite/Getty Images

AIスクレイピングは、視覚に訴えかけるアーティストに対して特に大きな影響を与える可能性がある。というのも、テキストプロンプトから画像を生成するモデルが新たな作品を生み出すために、こうしたアーティストの作品を無許可で使用しているためだ。しかし今回、そのソリューションになるかもしれないツールが開発された。

シカゴ大学の研究者らは、アーティストが自らのデジタルアート作品に「毒」を仕込んでおくことで、AIツールの開発者がこういったアート作品をモデルの訓練で使用できないようにする「Nightshade」という新たなツールを開発した。

この研究に関する独占取材を許されたMIT Technology Reviewによると、アーティストはNightshadeを用いることで、自らの作品中のピクセルに対して、人間の目には見えないものの、生成型AIモデルが「無秩序」かつ「予測不能」なかたちで破綻するような変更を加えられるようになるという。

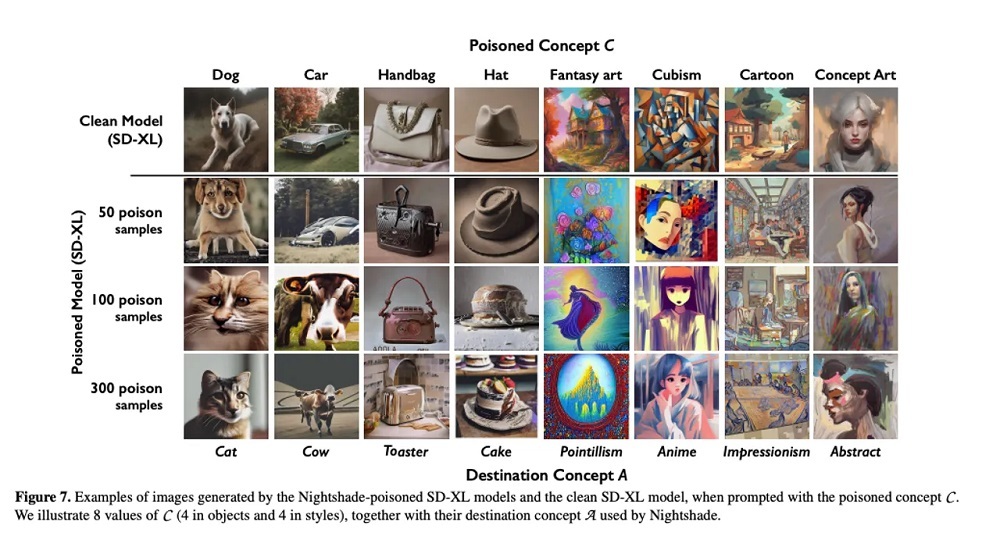

こうしたプロンプト対象型攻撃は、生成型AIのモデル学習プロセスに影響を与え、モデルが個々の学習対象を混乱するよう仕向けることで、役に立たない結果を描画させるというものだ。

例を挙げると、犬のことを実際には猫だと学習させ、その結果としてテキストプロンプトとは一致しない誤った画像をモデルに生成させることができるようになる。

提供:University of Chicago

今回の研究論文によると、Nightshadeの毒サンプルは100サンプル未満で「Stable Diffusion」を破綻させることができたという。

さらに、毒の効果は対象の言葉だけに終わらず、関連する言葉にも及ぶ。例えば、「dog」(犬)という言葉が影響を受けるだけではなく、「puppy」(子犬)や「hound」(ハウンド)、「husky」(ハスキー)といった類義語も影響を受ける。

言葉の間の関係は、上記の例で示されているほど直接的である必要はない。例えば論文では、「fantasy art」(ファンタジーアート)という言葉に毒を仕込んだ際に、「a painting by Michael Whelan」(Michael Whelan氏[ファンタジーアート分野で有名なクリエイター]の絵画」という言葉にも毒の及ぶ過程が説明されている。

モデルを訓練する側は、ロス(無駄)の多いデータのフィルタリングや、位置検出、毒の除去といった方法でこの攻撃を回避できる可能性があるものの、これら全ては完全に有効な防御策とはならない。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。