Google Cloudは米国時間4月9日、ラスベガスで開催の年次カンファレンス「Google Cloud Next 2025」で、第7世代の「Tensor Processing Unit(TPU)」(開発名:Ironwood)を発表した。これまでで最も高性能かつ拡張性が高く、推論に特化して設計された初のカスタムAIアクセラレーターだとしている。

Ironwoodは、次世代の生成AIとその膨大な計算および通信ニーズに対応するために構築されている。最大9216個の液冷チップをチップ間相互接続(ICI)ネットワークで接続できる。AIワークロードの需要に基づいて、256チップ構成と9216チップ構成の2つのサイズで提供される。

Ironwoodは1ポッド当たり9216個のチップ、合計42.5エクサフロップス(EFLOPS)に拡張することで、スーパーコンピューター「El Capitan」の24倍以上の計算能力をサポートするとのこと。また、大規模言語モデル(LLM)、Mixture of Experts(MoE)、高度な推論タスクを含む「思考モデル」の複雑な計算とコミュニケーション要求を円滑に管理できるように設計されている。各チップは、ピーク時で4614テラフロップス(TFLOPS)の計算能力を持つとしている。

Ironwoodは、高度なランキングやレコメンデーションといった処理で使われる、非常に大規模な埋め込み(データを数値の集まりで表現する方法)を処理する専用アクセラレーターである、強化された「SparseCore」も搭載している。

Google DeepMindが開発した独自の機械学習ランタイムである「Pathways」は、複数のTPUチップ間で効率的な分散コンピューティングを可能にする。Google Cloud上のPathwaysにより、単一のIronwood Podを超えた拡張が容易になり、数十万個のIronwoodチップを組み合わせて生成AIコンピューティングの最前線を急速に進化させることができる。

2024年に発表されたGoogleの第6世代TPU「Trillium」と比較して、消費電力当たりの性能が2倍に向上した。同社の高度な液冷技術と最適化されたチップ設計により、高負荷のAI処理を継続して行う場合でも、標準的な空冷方式と比較して、最大2倍の性能を安定して維持できるとしている。また、2018年の初代TPUと比較して、電力効率が約30倍優れているとのこと。

Ironwoodは、Trilliumの6倍となる1チップ当たり192GBのメモリー容量を提供する。これにより、より大きなモデルとデータセットの処理が可能になり、頻繁なデータ転送の必要性が減って性能が向上する。メモリー帯域幅もTrilliumの4.5倍となる1チップ当たり7.2Tbpsに大幅に向上した。ICI帯域幅は双方向で1.2Tbpsに増加し、Trilliumの1.5倍となった。

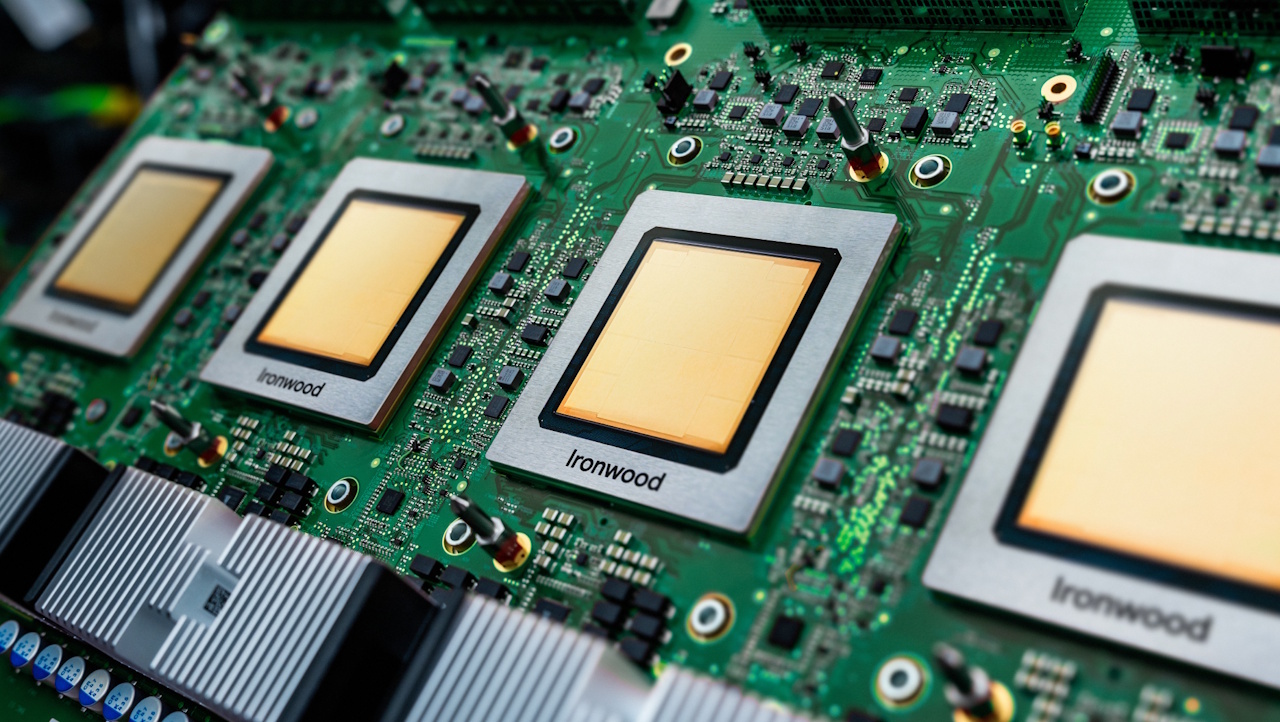

Ironwoodのイメージ(提供:Google)