マサチューセッツ工科大学(MIT)が作成したアルゴリズムが、人間に本物と認識させる音を作り出し、「音のチューリングテスト」に合格したという。

MITの研究者らはAlan Turing氏が1950年代に考案した「チューリングテスト」を応用した。このテストは、人間と「区別できない」ほど高いレベルの人工知能(AI)を人間が作り出せるかを検証するベンチマークとして作られたもの。

MITは既にTuring氏の成果を活用して、人が書いたかのように見える文字を書くシステムを開発し、「視覚の」チューリングテストに合格させている。

今回、MITのコンピュータ科学・人工知能研究所(CSAIL)はディープラーニング(深層学習)アルゴリズムを作成し、「音のチューリングテスト」に合格させたという。

MITのチームは数カ月にわたって、さまざまな物体をドラムスティックで叩いたり突いたり壊したりして4万6000以上の音を作り出し、その様子を約1000本の動画に収録した。

これらの動画はアルゴリズムに投入された。アルゴリズムは動画を分解し、音の高さや大きさなどの特徴を分析。そして、動画の各フレームに含まれる音に関する特徴を把握し、データベースにある似た音を組み合わせて、動画の音を「予測」できるようになった。

その結果、このAIはさまざまな接触音を模倣できるようになった。例えば「ドサッ」という音や、歯切れの良い音、カサカサいう音だ。

「ワイングラスを指でなでると、その音には中に入っている液体の量が反映される」と、この研究のリーダーでありCSAILの博士課程で学ぶAndrew Owens氏は述べている。「このような音を具現化するアルゴリズムは、物体の形や材質、さらに周囲のあらゆる物と関わる際の力や動きに関する重要な情報を明らかにすることができる」(同氏)

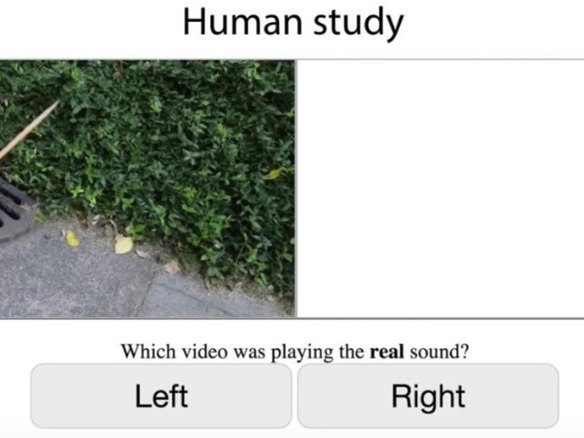

次の段階は、テストすることだった。オンライン調査により、参加者は物と物がぶつかる2つの動画を見せられる。1つは録音された本物の音、もう1つはアルゴリズムが作り出した音を含んでいる。どちらの動画が本物かを問われて参加者が偽の音を選んだ頻度は、本物を選んだ頻度の2倍にのぼった。

アルゴリズムが葉や土などによる「はっきりしない」音を作り出した場合は特に、それが本物だと参加者に信じさせることができた。

それでも、このシステムにはまだ改善の余地がある。例えば、ドラムスティックが不規則に動いている場合、アルゴリズムは音をうまく生成できなかったり、本来は音のないところで音を生成したりすることが多くなる。研究チームによると、このアルゴリズムは現在、動画の中の物理的な接触によって生じた「視覚的に明示された音」のみに対応しており、それ以外には対応していないため、これについても改良が可能だという。

こうした課題はあるものの、MITはチューリングテストを起点にAIという分野で前進している。将来、このチームはロボットの能力を向上させて、音声を認識するだけでなく、周囲や環境全体とやり取りできるようにしたいと考えている。

「ロボットが歩道を見て、セメントは固く草は柔らかいと直感的に把握し、それによりどちらを踏んだら何が起きるかを認識することができる」とOwen氏は述べる。「音を予測することは、周囲のあらゆる物との物理的な接触によって何が起きるかを予測できるようになることへの、重要な第一歩だ」(同氏)

この研究は、米国立科学財団(NSF)とShellによって一部資金の提供を受けている。MITの論文は6月にラスベガスで開催される年次会議「Computer Vision and Pattern Recognition(CVPR)」で発表される予定だ。

この記事は海外CBS Interactive発の記事を朝日インタラクティブが日本向けに編集したものです。