Facebookは、拡張現実(AR)や仮想現実(VR)の世界を創出していく上で、人工知能(AI)が「自己中心的な観点」を獲得しなければならないと考えている。

提供:Facebook AI

その目標に向けて同社は米国時間10月14日、「Ego4D」を発表した。これは約3000時間に及ぶ一人称視点の動画データセットと、ニューラルネットワーク(NN)のベンチマークテスト一式からなっている。その目的は、AIが仮想世界で上手に立ち回っていく上で必要となる知識の開発を一人称の視点から促そうというものだ。

このプロジェクトは、Facebook Reality Labsと、学術機関や研究所などの13の研究機関に所属する学者たちとの共同研究だ。その詳細は、FacebookのKristen Grauman氏が筆頭著者となって書き上げた「Ego4D:Around the World in 3,000 Hours of Egocentric Video」(Ego4D:自己中心的動画3000時間世界一周)に記されている。

Grauman氏は、FacebookのAI研究部門であるFacebook AI Research(FAIR)のサイエンティストだ。同氏はテキサス大学オースティン校の教授としてコンピュータービジョンや機械学習(ML)に関する分野での研究を進めてきている。

そのアイデアというのは、「ImageNet」のような大規模データセットが「観測者」の視点から既存のAIプログラムの発展を促したように、このデータセットによって、一人称の視点からのタスク実行に長けたNNの発展を促すような力をリサーチャーにもたらすというものだ。

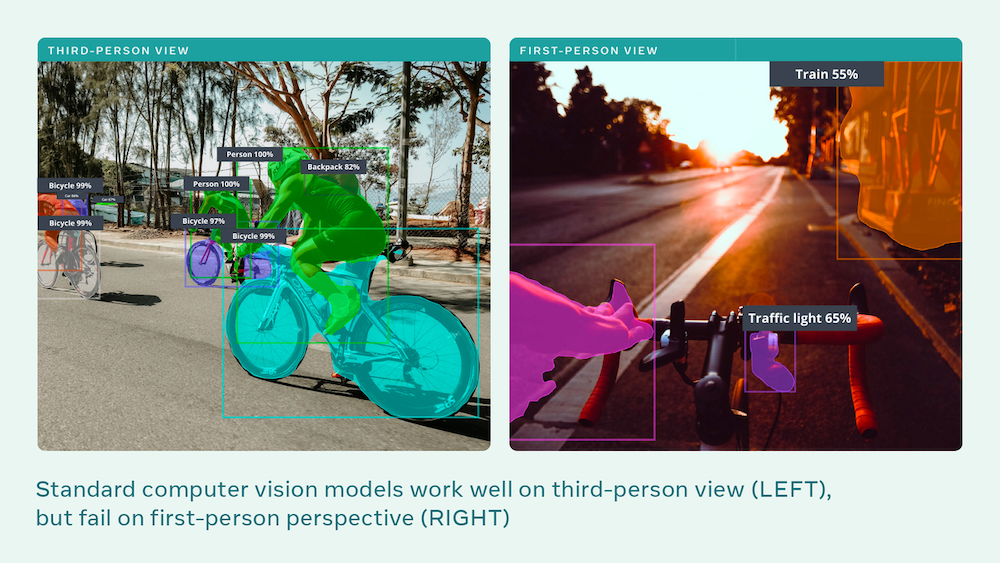

Facebookによると、自己中心的な視点のポイントは、例えば画像認識が絡む基本的なタスクにおいて、三人称の視点から一人称の視点に移った場合に発生するNNの問題を解決しようとするものだという。

ほとんどの画像認識システムは側面から見た物体を検出できても、その物体を人間が扱う際のように、真正面から見たかたちで提示されると、認識精度が低下してしまう。

Ego4Dというイニシアチブは、メタバース、すなわち没入型ソーシャルネットワーキングという次なる世界にターゲットを絞ったものだ。メタバースについては、Facebookの最高経営責任者(CEO)Mark Zuckerberg氏が同社の2021会計年度第2四半期の決算発表でも語っていた。

Facebookは、「これらのベンチマークによって、現実世界だけでなくメタバース、すなわち現実とAR、VRすべてが融合する単一空間を理解し、そこでのやり取りを可能にするよりスマートなAIアシスタントを開発する上で必要となるビルディングブロックの研究が促進される」と述べた。

Facebookのスタッフは、さまざまなカメラを用いて約3000時間に及ぶ動画を撮影した。Vuzixのスマートグラス「Vuzix Blade」もその1つであり、他にはGoProやPupil Labs、Zetronix、愛拍設計(WEEVIEW)のカメラも使用した。Grauman氏と共同研究者らによると、さまざまなカメラを使用した理由は、NNが異なった対象の類似点を推論するのではなく、動画フレームの情報自体を記憶してしまう「過剰適合」という現象を避けるためだという。