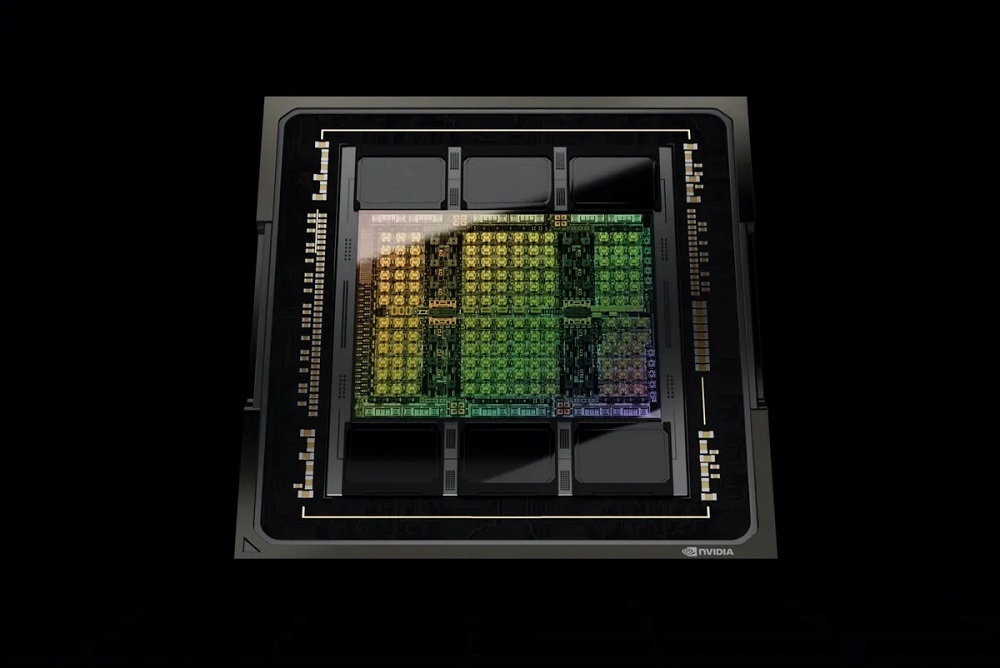

NVIDIAの最高経営責任者(CEO)Jensen Huang氏は米国時間9月20日、秋の「NVIDIA GTC(GPU Technology Conference)」カンファレンスで、同社の「NVIDIA Hopper」アーキテクチャーに基づくグラフィックスプロセッシングユニット(GPU)が量産体制に入っており、Dell TechnologiesやHewlett Packard Enterprise(HPE)、Cisco Systemsなどのパートナー企業からこのGPUを搭載したシステムが10月より出荷される予定だと発表した。また同氏は、このGPUを搭載したNVIDIAシステムが2023年第1四半期に利用可能になるとも述べた。

提供:NVIDIA

「NVIDIA H100」としても知られるこのHopperチップは、人工知能(AI)などのタスクを念頭に置いた、データセンター向けのものとなっている。同社は、H100によってAIプログラムの配備にかかるコストを「劇的に」削減できるとしている。例を挙げると、前世代の最上位GPUである「NVIDIA A100」が320基必要だった処理は、H100ではわずか64基で実行できる、つまりサーバーノードの数を5分の1に抑えられるという。また、エネルギー効率は3.5倍に向上する。

同社が最初にHopperを発表したのは3月だった。そして同社は9月に入り、機械学習(ML)タスクのベンチマークテスト「MLPerf」でのスコアを明らかにしていた。

Huang氏は、Hopperの利用可能性とともに、新たな「サービスとしての」クラウド製品、すなわち「大規模言語モデル」向けの「NVIDIA NeMo LLM」についても言及した。顧客はこのサービスを利用することで、OpenAIの「GPT-3」や、NVIDIAとMicrosoftが共同で開発した言語モデル「Megatron-Turing NLG 530B」(MT-NLG)といった膨大な規模の自然言語処理モデルを容易に配備できるようになる。

10月から「アーリーアクセス」形式での提供が開始されるこのNeMoサービスでは、GPT-3をはじめとするモデルを訓練済みの状態で提供し、NVIDIAが「プロンプトラーニング」と呼んでいる、2021年にGoogleの科学者らが発表したテクニックを取り入れた手法を用いることで、開発者によるチューニングを可能にしている。

提供:Nvidia

「NVIDIA BioNeMo」というNeMoの応用事例は、創薬などのワークフローで利用できる、生物医学向け大規模言語モデルの利用に特化したサービスとなる。

今回のプレゼンテーションでは、ヘルスケア業界を含むさまざまな業界向けや、NVIDIAのメタバース用ソフトウェアプラットフォーム「NVIDIA Omniverse」向けの、多数の専用コンピュータープラットフォームも網羅されていた。

これらプラットフォームには、ヘルスケアアプリケーション向けの「NVIDIA IGX」プラットフォームや、工場向けのIGXプラットフォーム、Omniverse開発専用の「NVIDIA OVX」プラットフォームの新バージョンのほか、自動車用コンピューティングプラットフォーム「NVIDIA DRIVE」の新バージョンとなる、Hopper GPUとNVIDIAの次期CPU「NVIDIA Grace」を一体化した「NVIDIA DRIVE Thor」が含まれている。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。