NVIDIAは、同社が命名した「スーパーチップ」の強化版として、HBM3eメモリーを搭載する次世代「NVIDIA GH200 Grace Hopper Superchip」を発表した。

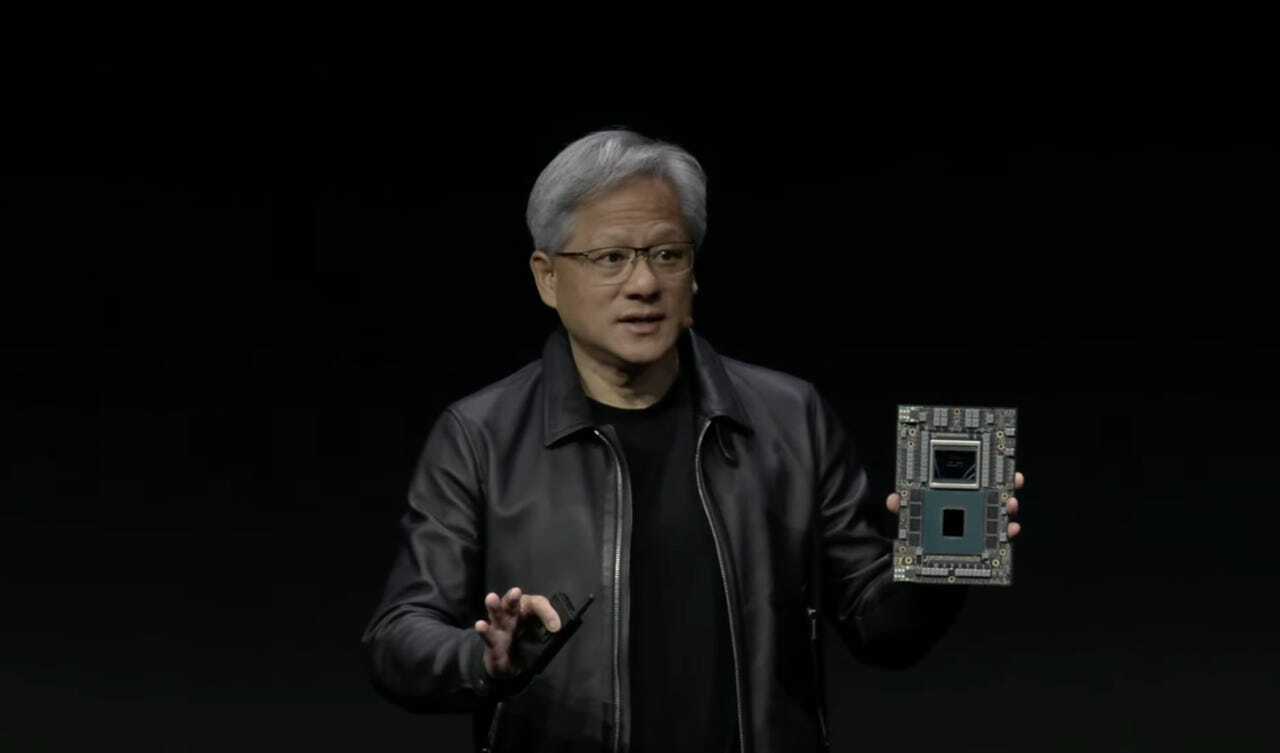

NVIDIAのCEO、Jensen Huang氏

提供:NVIDIA

これを搭載するシステムは2024年第2四半期に提供が始まる見込みだ。最高経営責任者(CEO)Jensen Huang氏が米国時間8月8日、ロサンゼルスで開催されているコンピューターグラフィックスの年次カンファレンス「SIGGRAPH」の基調講演で語った。次世代GH200 Grace Hopperは、CPUとGPUを組み込み、より高速なメモリーを搭載することで、回路を行き来するデータの大容量化を実現している。

これは、2023年に入って発表されたGrace Hopperの次期バージョンだ。初期バージョンは、すでにDellなどのコンピューターに搭載されて出荷されている。

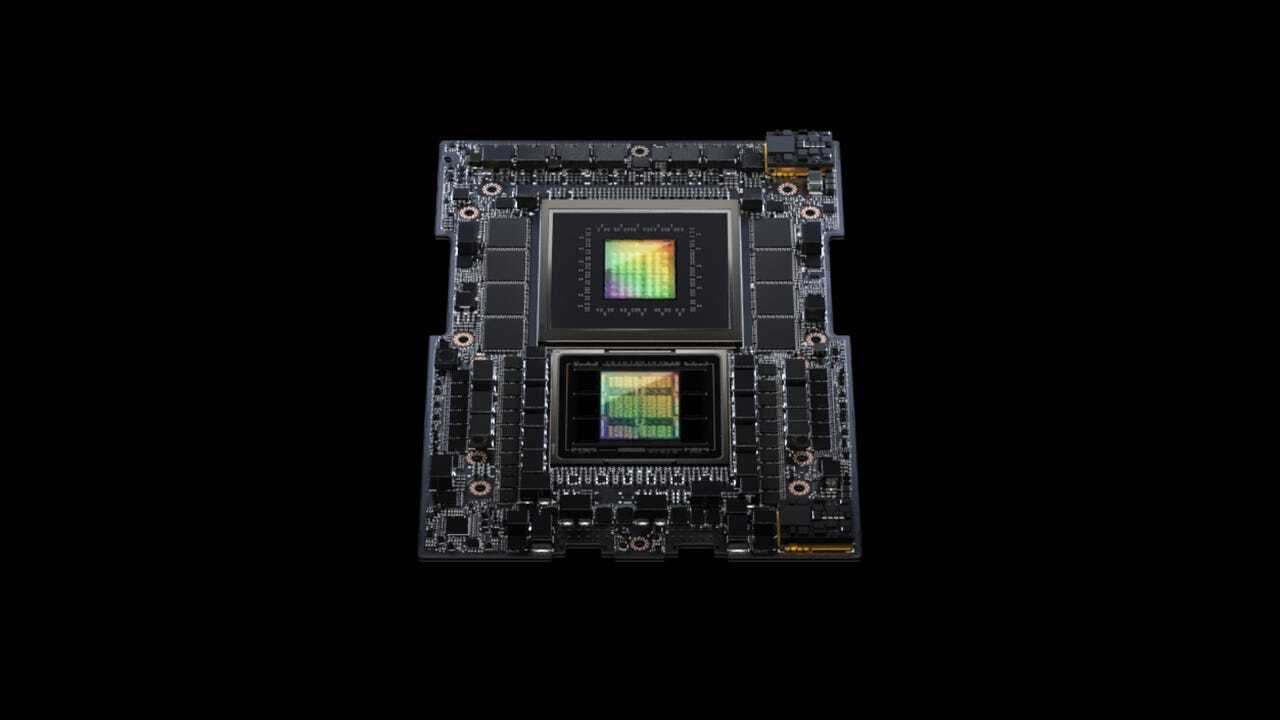

初代のGrace Hopperでは、「Hopper」GPUにデータを転送する広帯域幅メモリー(HBM)の容量は96GBだが、新GH200では、HBM規格の次期バージョンであるHBM3eの容量が141GBになる。HBM3eにより、GPUに転送されるデータレートは初代Grace Hopperの毎秒4TBから5TBに高速化する。

次世代GH200は初代と同様、ArmベースのGrace CPUと、Hopper GPUを搭載している。これらは回路基板上で、高速かつキャッシュコヒーレントなメモリーインターフェース「NVLink」によって接続されている。このNVLinkを通じて、Hopper GPUはCPUのDRAMメモリーにアクセスする。

Huang氏の説明によると、GH200をデュアル構成のサーバー内で第2のGH200に接続することで、HBM3eメモリーの帯域幅は合計10TBになるという。

提供:Nvidia

NVIDIAは過去にも、GPUパーツのメモリー速度をアップグレードしてきた。例えば、「Ampere」アーキテクチャをベースにした前世代のGPU「A100」は、HBM2からHBM2eに移行した。

以前のGPUメモリー標準だったGDDRからHBMへの移行は2015年に始まったが、それをけん引したのは、ビデオゲームグラフィックス用の4Kディスプレイのメモリー需要増だった。HBMは積層型のメモリー構成で、個々のメモリーダイが互いに垂直に積み重ねられ、各チップを貫通する「シリコン貫通ビア」を介して、各チップ間の表面にはんだ付けされた「マイクロバンプ」に接続される。

AIプログラム、特に「ChatGPT」のような生成系AIは、メモリーを大量に消費する。というのも、膨大な数のニューラルの「重み」、すなわちパラメーターを保存する必要があるからだ。ニューラルネットワークにおいては、主要な機能単位である行列がパラメーターになる。これらの重みは、大規模言語モデルのような生成系AIプログラムの新しいバージョンが出るたびに増加し、1兆個のパラメーターに向かう傾向にある。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。