カーネギーメロン大学計算機科学部の学部長であり、元GoogleのバイスプレジデントであるAndrew Moore氏が、興味深い話をしてくれた。同氏は、2016年には機械に感情を理解させる研究が盛んになると予想しているという。ロボットやスマートフォン、コンピュータはまもなく、人間の感情を理解し、それに合わせて反応できるようになり始めるだろう。

「すぐに役に立つ使い方が出てくるはずだ。感情を理解するコンピュータによる、緊急治療室での患者のモニタリングができれば、患者がコミュニケーションできない状態でも、医者は患者が不快に感じているかどうかを知ることができる。あるいは、生徒の感情面での反応を見て生徒の関心のレベルを知ることができれば、教師はより効果的に教えることができるだろう。これらは明らかに有益だ」と同氏は説明する。

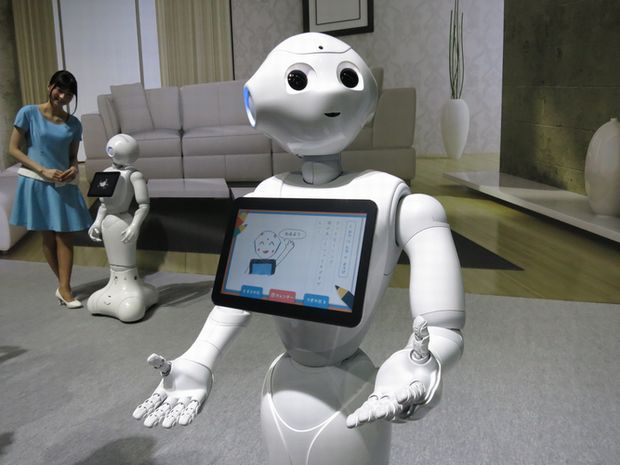

Aldebaranが開発した、感情を読み取るロボット「Pepper」

しかし、Moore氏が警告するように、感情を理解できる機械が受け入れられるのには、困難が伴う可能性もある。

「この技術が広告などに使われれば、不快に感じられるかも知れない。わたしはインターネット広告についても専門としており、もし学部長の仕事で忙しくなければ、タブレットでユーザーがウェブページを読むところを観察して、肯定的に反応しているか、否定的に反応しているかを調べられるような技術を提供するスタートアップ企業を立ち上げているだろう」(Moore氏)

その情報が広告主にとってどれだけ貴重なものかは言うまでもないが、この技術が厳重に監視されたり批判されたりせずに進歩することはないだろう。

人間は意識的にも無意識的にも、感情を示す手がかりを数多く発信しているため、この分野の研究はいくつか並行して進められている。声のパターンからはストレスや興奮の度合いを読み取ることができ、表情筋の動きは、人間の内部状態を表している。例えば、機械による感情センシング技術に関する最大のブレークスルーの1つは、当然にも思える話だ。

「カメラの解像度は大きく向上した。高解像度カメラは顔のわずかな動きや、髪の毛の一本一本までも捉えることができる」とMoore氏は言う。