生成人工知能(AI)との関連で言語モデルを考えるとき、真っ先に思い浮かぶのは大規模言語モデル(LLM)だろう。「ChatGPT」「Bard」「Copilot」など、人気のチャットボットを支えているのは、こうしたLLMにほかならない。しかし、Microsoftの新しい言語モデルは、小規模言語モデル(SLM)も生成AIの分野で大きな可能性を秘めていることを示している。

提供:Microsoft

同社は米国時間12月12日、常識的な推論と言語理解が可能なSLMの「Phi-2」を発表した。現在、「Azure AI Studio」のモデルカタログで利用可能となっている。

「小規模」という言葉に惑わされてはいけない。Phi-2は27億個のパラメーターを持ち、その数は「Phi-1.5」の13億個から飛躍的に増加している。

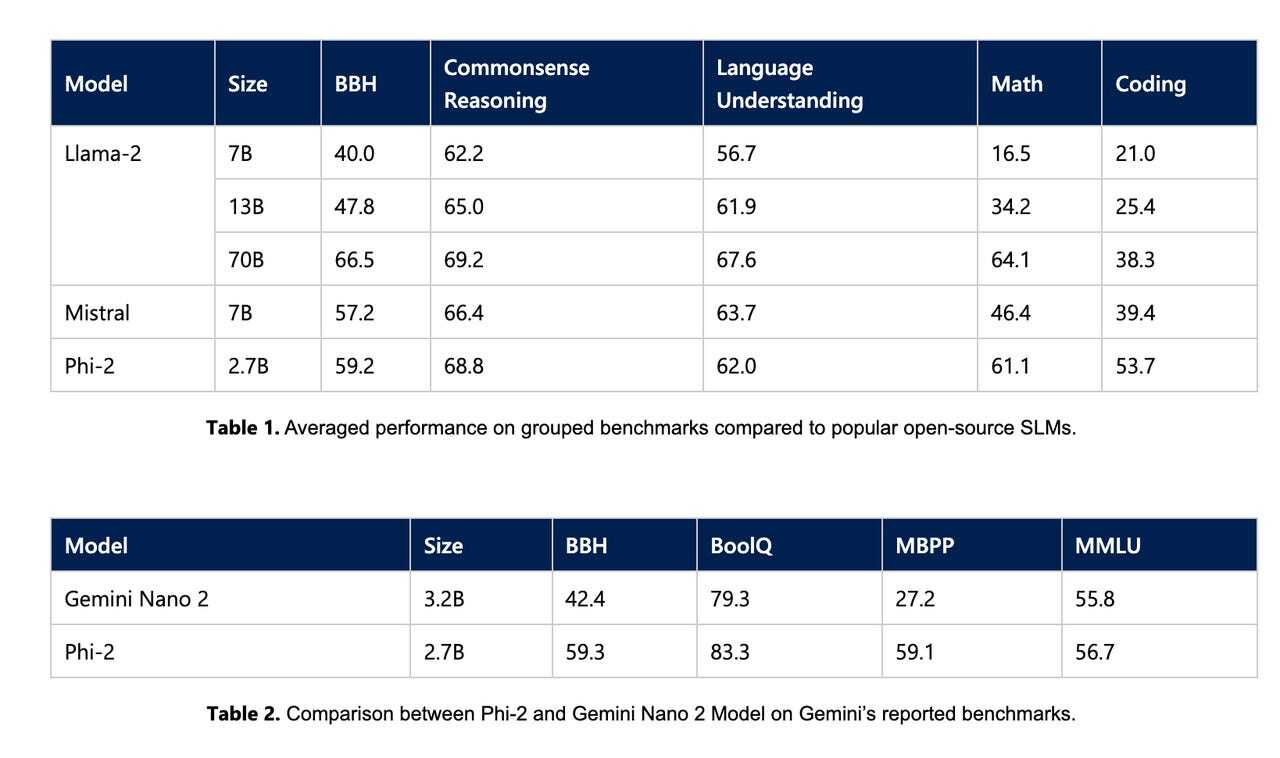

同社によると、Phi-2はパラメーターが130億個以下の言語モデルの中で「最先端の性能」を発揮し、複雑なベンチマークでは最大25倍の言語モデルを上回ったという。

下図が示すように、Phi-2は、Metaの「Llama-2」やMistral AIの「Mistral」に加え、Googleが提供する高性能LLMの最小バージョンである「Gemini Nano 2」さえも、いくつかのベンチマークで凌駕した。

提供:Microsoft

MicrosoftはPhiの開発において、より大規模な言語モデルに匹敵する性能と新たな機能を持つSLMを目指しており、この性能結果はその目標と一致している。

同社はPhi-2のトレーニングにあたり、データを厳選し、まず「教科書品質」のデータを用いたという。その後、学習するに値するかどうかとコンテンツの品質をもとに精選したウェブデータを追加し、言語モデルのデータベースを増強した。

同社がSLMに注力しているのはなぜだろう。それは、LLMに対するコスト効率の優れた代替となるからだ。SLMはLLMほどのパワーを必要としないタスクで役立つ。LLMよりはるかに少ない計算能力で実行できるため、データの処理要件を満たすために高額なGPUへ投資する必要がなくなる。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。