FICOとCoriniumが新たに発表した調査レポートで、多くの企業はさまざまな形態の人工知能(AI)をあらゆる場面に導入しているが、潜在的な倫理の問題を考慮しないままとなっている場合があることが明らかになった。

この10年間で、企業が使用していたAIが破滅的な結果を招く事例が数多く起きている。例えば肌が黒いと顔の認識精度が低下する顔認識システムや、アフリカ系米国人の患者を差別するヘルスケアアプリ、裁判所が利用する再犯率を計算するAIが人種によって偏った結果を出していた事例など、そうした例は枚挙に暇がない。

それでも、FICOのレポート「State of Responsible AI」によれば、ビジネスリーダーは自分たちが幅広くAIシステムを利用しているにも関わらず、AIの公平さや安全性を確保する努力を怠っていることが明らかになった。

2~3月にかけて実施されたこの調査は、米国、南米、欧州、中東およびアフリカ、アジア太平洋の各地域から20人ずつ選ばれた、計100人のAI分野のビジネスリーダーを対象としたものだ。

この調査では、年間売上高1億ドル(約110億円)以上の企業に所属する最高データ責任者(CDO)や最高AI責任者(CAO)、最高アナリティクス責任者(CAO)などの役職にある役員を対象として、AIの責任ある倫理的な利用を推進するために講じている方策について尋ねた。

レポートによれば、回答者の約70%は、特定のAIモデルの意思決定や予想がどのように行われているかを説明することはできないと述べており、AIを透明性が高く説明責任を果たせる形で利用する努力をしていると答えたのは35%にすぎなかった。

使用する技術の公平性についての判断を行うAI倫理委員会を設けていると答えた回答者はわずか22%で、残りの78%は、「新しいAIシステムを使用することによる倫理的な影響を保証する体制は十分に整っていない」と述べている。

また回答者の80%近くが、倫理的なAIの利用を検討したり、優先させたりするようほかの幹部を説得することは非常に困難だと答えていた。不公平なAIや、非倫理的なAI、正しく管理されていないAIが評判を損なうリスクとビジネスの両方を真に理解している企業役員はほとんどいない。

さらに回答者の65%以上は、すべてのAIプロジェクトが規制を遵守していることを保証するためのプロセスが「効果的ではない」(「あまり効果的ではない」と「まったく効果的ではない」の合計)と述べており、半数近くが「まったく効果的ではない」と述べていた。

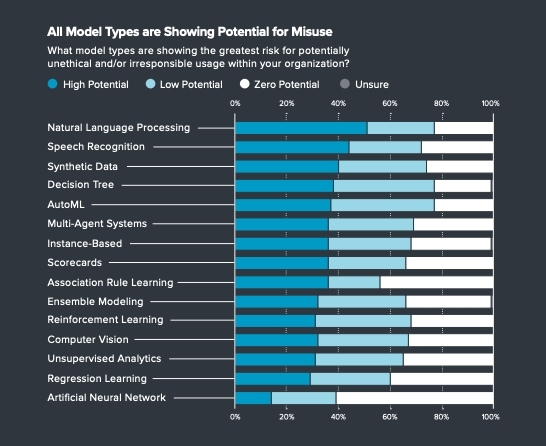

企業がAIの利用について十分な配慮を行っていないことを認めているにも関わらず、調査対象の77%はAutoML技術が誤った形で使われる可能性があることを認めており、90%はモデルを監視するプロセスが非効率的であることがAI導入の障害になっていると回答していた。