人工知能(AI)コンピューターメーカーであるCerebras Systemsは米国時間11月29日、研究目的にとどまらず、商用利用も増えてきている大規模言語モデルの処理を高速化するサービスを発表した。同社は、チップおよびコンピューターの開発を手掛けており、最近ではディープラーニング(DL)を高速化するための専用スーパーコンピューターの開発も進めている。

提供:Cerebras Systems

同社の共同創業者であり、最高経営責任者(CEO)のAndrew Feldman氏は報道陣に向け、「大規模言語モデルは過大評価ではなく、過小評価されていると考えている」と述べた上で、「われわれは、そのインパクトを目にし始めたところだ。今後、大規模言語モデルのエコシステムにおけるハードウェアレイヤーとインフラレイヤー、アプリケーションレイヤーの3つの層でそれぞれ勝者や、新興企業が台頭してくるだろう」と語った。

また同氏は、「2023年には、経済のさまざまな分野で大規模言語モデルのインパクトが急速に高まっていくのを目にするようになるだろう」と予測した。

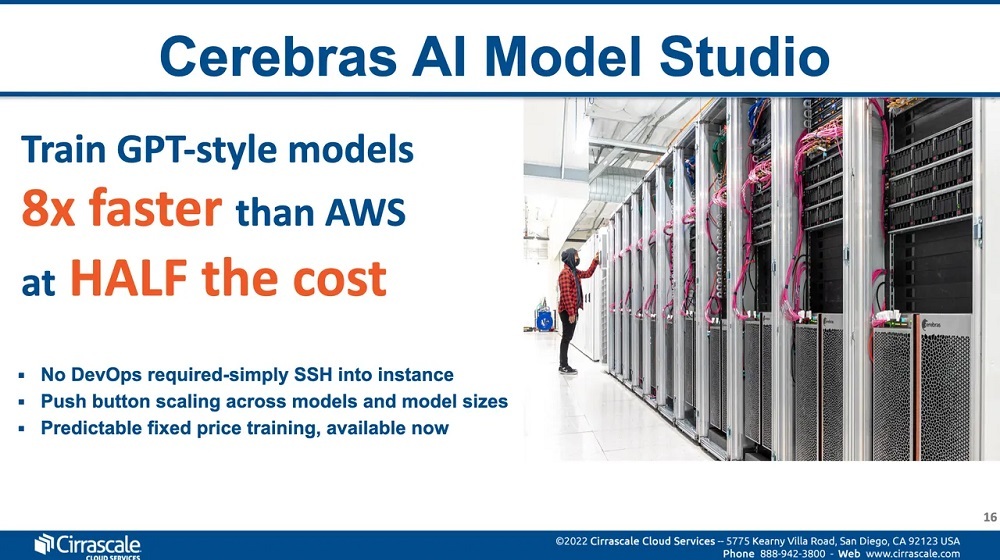

同社は、クラウドコンピューティングサービスプロバイダーであるCirrascale Cloud Servicesとの提携により、「利用時間に基づく」かたちでコンピュート能力を提供する。つまりユーザーは、OpenAIの「GPT-3」といった大規模言語モデルの集中的な訓練を、DL用に開発された「Cerebras CS-2」コンピューターのクラスターを用いてフラットレートで実行できるようになる。

このサービスは「Cerebras AI Model Studio」という名称で展開される。

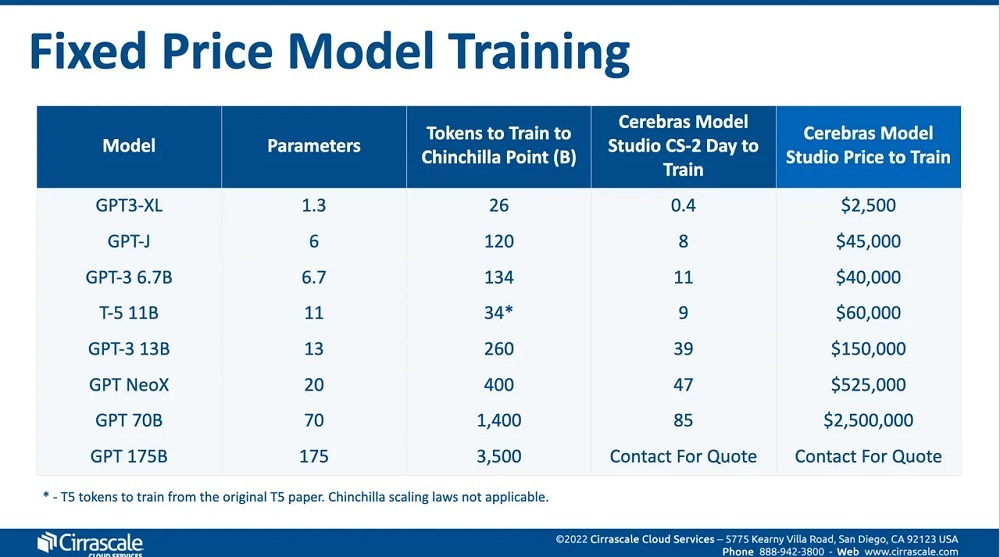

その価格は、13億個のパラメーターを用いるGPT-3モデルを0.4日使用する場合、2500ドル(約35万円)、700億個のパラメーターを85日間使用する場合、250万ドル(約3億5000万円)となっている。これは、同等の作業を実行しようとした場合に必要となる、数年分のクラウド能力のレンタル料金やマシンのリース料金と比べると、平均で半分程度で済むようになっている。また、CS-2クラスターの処理速度は、クラウド上の「NVIDIA A100」搭載マシンのクラスターを用いた訓練速度と比べると8倍に達するという。

Cirrascaleは、自社のCS-2クラスターと、Cerebrasが所有するマシンとともに、カリフォルニア州に拠点を置くColovoreのサンタクララの施設にコロケーションされているスーパーコンピューター「Andromeda」を組み合わせて使用している。なお、この施設にはCirrascaleの機器も設置されている。

提供:Cerebras Systems/Cirrascale

同サービスに関する今回の提携は、クラウド上のCS-2マシンを週単位で提供するという、CerebrasとCirrascaleの間で締結された2021年の提携に続くものとなっている。

Feldman氏によると、このサービスは言語モデルの規模に応じてクラスターのサイズを自動的に調整するようになっているという。またCerebrasは、マシンを追加することで訓練のパフォーマンスが線形に向上していくという点を強調している。

提供:Cerebras Systems/Cirrascale

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。