米NVIDIAの日本法人エヌビディアは説明会を開催し、自社の生成AI向けコンピューティングプラットフォームをハードウェア、ソフトウェア、クラウドサービスに分類して解説した。

エヌビディア テクニカル マーケティング マネージャーの澤井理紀氏(写真提供:エヌビディア)

説明会に登壇したテクニカル マーケティング マネージャーの澤井理紀氏は、生成AIの開発では基盤モデルの構築とカスタマイズにおいて複数の課題があると指摘。基盤モデルの構築段階では、膨大なトレーニングデータ、トレーニング/推論用の大規模計算資源、深い専門知識、大規模インフラ上に構築される複雑なアルゴリズムが必要となる。

カスタマイズの段階では、ハルシネーション(偽情報)や偏見・有害性が含まれた情報の生成のほか、「一般的なデータセットでトレーニングされたモデルには、企業独自の知識が含まれていない」「トレーニング完了時点で知識が固定されてしまう」といった課題が存在する。

澤井氏は「これらの課題に対応して独自の生成AIを構築・使用するには、NVIDIAのコンピューティングプラットフォームを活用してもらうのが一番簡単である」とアピールした。現在、1600以上の事業者が同社のコンピューティングプラットフォームを利用して生成AIを開発・運用している。

NVIDIAのGPUはAIの処理に最適化されており、大規模言語モデル(LLM)のトレーニングや実行において高い演算能力を発揮するとともに、高い性能と電力効率を実現するという。拡張性にも優れており、「ChatGPT」の開発では米OpenAIが約1万基に上るNVIDIAのGPUを活用し、数週間にわたってトレーニングを行った。

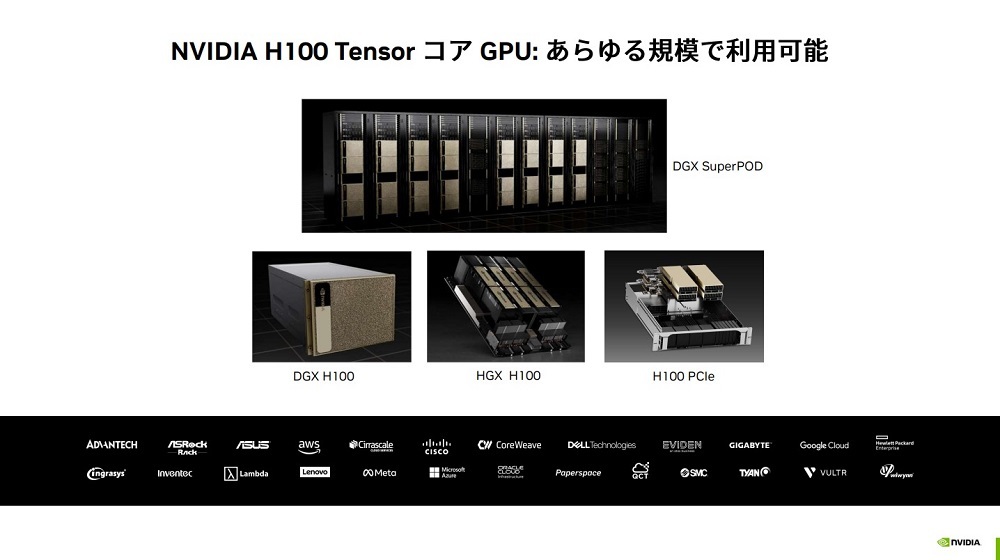

生成AIをトレーニングする最新GPUとして「NVIDIA H100 Tensor コア GPU」がある(図1)。同GPUは、深層学習モデル「Transformer」のアーキテクチャーを高速に処理するエンジンを搭載。オンプレミス/クラウドの両方で利用でき、筑波大学やサイバーエージェント、三井物産など幅広い事業者が導入している。

図1:NVIDIA H100 Tensor コア GPU

図1:NVIDIA H100 Tensor コア GPU

※クリックすると拡大画像が見られます

H100 Tensor コア GPUは、前世代のGPU「A100」の320基と同等の性能を64基で実現する。これにより、総所有コストが3分の1に減少、サーバーノード数が5分の1に減少、エネルギー効率が3.5倍に向上する。

しかし、基盤モデルのサイズやトレーニングデータの量は指数関数的に増加する。NVIDIAはより大規模な基盤モデルを素早く処理するシステムの開発にも取り組んでおり、その中核としてAIスーパーコンピューター「NVIDIA DGX GH200」の提供を2023年中に予定している(図2)。

図2:NVIDIA DGX GH200

図2:NVIDIA DGX GH200

※クリックすると拡大画像が見られます

DGX GH200は、256基のアクセラレーテッドCPU「Grace Hopper Superchip」で144テラバイト(TB)の共有メモリー空間を提供する。またGrace Hopper Superchipsは、同じ回路基板上で 「NVIDIA Grace CPU」と「NVIDIA Hopper GPU」を組み合わせることで、従来のPCIeによるCPU・GPU間の接続を不要とし、帯域幅を7倍に増加させるとともに、インターコネクトの消費電力を5倍以上削減する。

NVIDIAは推論に特化したAIプラットフォームを複数展開しており、画像生成向けの「NVIDIA L40」とLLM向けの「NVIDIA H100 NVL」などがある。L40は、前世代の「A40」と比べて画像生成を7倍の速さで処理する。H100 NVLは、94ギガバイト(GB)のメモリーを搭載したGPUを2つ接続することで、合計188GBのメモリーを備える。また、「GPT-3」の推論を前世代の「A100」と比べて12倍の速さで処理する。

「生成AIの推論は1回の処理で完了するが、ユーザーからの膨大なリクエストを低遅延で処理する必要がある。推論には、トレーニングとは異なるコンピューティングの難しさがある」と澤井氏は説明した。