Hewlett Packard Enterprise(HPE)が社運をかけて開発中の次世代のコンピューティングアーキテクチャ「The Machine」が少しずつ成果を上げている。11月28日から3日間、英ロンドンで開催した欧州の年次イベント「HPE Discover London 2016」で初のプロトタイプの起動に成功したことを報告した。

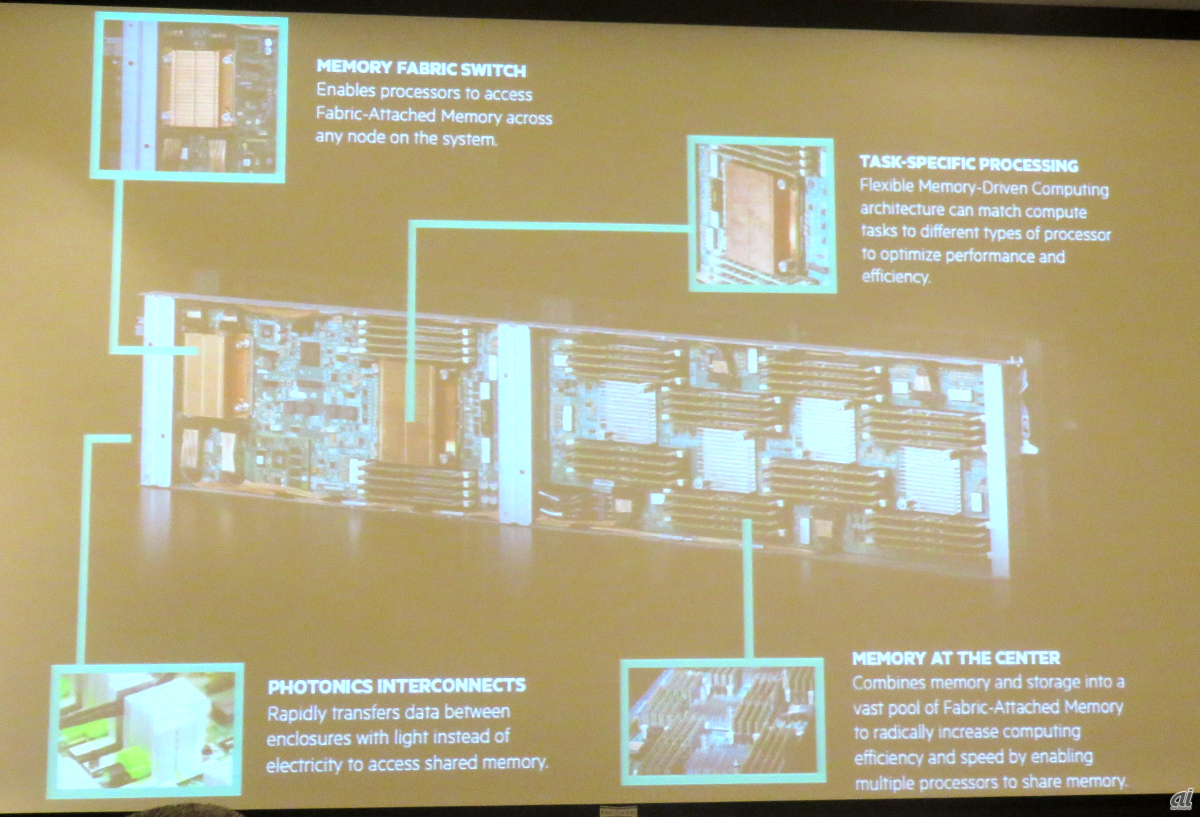

The MachineはHPEが2014年のDiscover Las Vegasで正式発表したプロジェクト。マイクロプロセッサを中心としたこれまでのアーキテクチャをメモリ中心にするというもので、これを実現するための複数の技術プロジェクトで構成される。

HPE CEO Meg Whitman氏

最高経営責任者(CEO)であるMeg Whitman氏は基調講演のステージで、メモリを中心に据えたThe Machineのコンセプトを「メモリドリブンコンピューティング」と銘打った。「これまで60年間、コンピューティングのアーキテクチャは変わっていない。メモリドリブンコンピューティングはこれからのコンピューティングを定義するものになる」と説明、「ヘルスケア、教育、運輸輸送、小売りと全てを変える可能性を秘めている」と続けた。

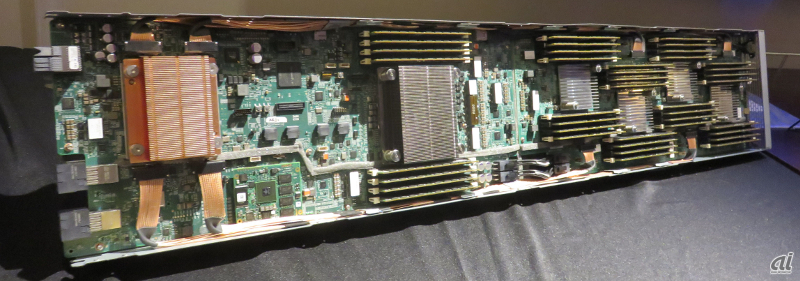

10月24日に成功したプロトタイプは、ファブリックアタッチドのメモリの共有プールを作成し、これにコンピュートノードがアクセスする。最適化されたLinux(Debian)ベースのOSをシステムオンチップ(SoC)上で動かし、接続部分はフォトニクスモジュール「X1」を含む光ベースの通信リンクを用いた。潤沢な永続メモリを活用するためのソフトウェアプログラミングツールも実演してみせた。

既存製品上で新しいプログラミングツールを動かしたところ、ワークロードを最大8000倍高速に実行できたと言う。「ノードとメモリの拡張でキャパシティを拡大できる」(HP Labsシステムリサーチ担当チーフアーキテクト兼HPEフェローのKirk Bresniker氏)と拡張性もアピールした。

The Machine内部

The Machineのプロトタイプ

The Machine開発の背景にあるのはデータの爆発だ。「現在のアーキテクチャではコンピューティングモジュールとメモリが紐付いているため、メモリのスケールが難しい。そこで発想を完全にひっくり返して、コンピューティングを必要に応じて接続できないかと考えた」とHP Labsのチーフアーキテクト、Paolo Faraboschi氏は言う。Bresniker氏は、ムーアの法則などこれまで業界の成長に貢献してきたものがデータの爆発についていけなくなっているとも指摘する。

データは2020年まで2年おきに倍増するが(右)、処理する側はついていけない(左)という

構想は2年前の発表からさらに遡ること3~4年ほど前からあったという。Bresniker氏は、The Machineは分社する前のHewlett-Packard時代を含め「規模と複雑性の両方で過去最大のリサーチプロジェクトだ」と述べた。

Bresniker氏は、メモリドリブンコンピューティングがパフォーマンスにもたらすメリットの例も紹介した。クラスタコンピューティングフレームワーク「Apache Spark」を利用したインメモリ分析の場合で15倍という。新しいアルゴリズムの例としては、類似性分析は300倍、大規模な推理グラフで100倍、財務モデルでは8000倍の高速化が見込めると胸を張る。

Gartnerは2020年までに接続されたデバイスの数は208億台に達すると予想しているが、IoTによりデータの量はさらに増える。これらのデータを処理をして、意味のある情報を得る必要がある。それも速度が求められる。「すべてがコンピュートする時代だ。メモリドリブンコンピューティングは新しい時代の土台技術になる」(Whitman氏)