Advanced Micro Devices(AMD)の最高経営責任者(CEO)Lisa Su氏は米国時間6月13日、同社が開催したイベント「Data Center and AI Technology Premiere」で、人工知能(AI)コンピューティング分野における自社戦略の鍵となるチップを発表した。このチップは、大規模言語モデル(LLM)のような生成型AIのタスクが要求する、膨大なメモリー容量とデータスループットに応えるものだとされている。

提供:AMD

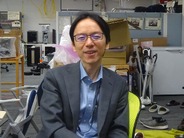

今回発表された「AMD Instinct MI300X」というチップは、以前に発表されていた「AMD Instinct MI300A」に続く製品だ。このチップは実際のところ、複数の「チップレット」が組み合わされたものであり、単一のパッケージ内でそれぞれがメモリーとネットワークリンクを共有するようになっている。

Su氏は、サンフランシスコのダウンタウンにあるフェアモントホテルで開催した招待客限定の同イベントで、この製品を「生成型AIアクセラレーター」と位置付け、搭載されている「AMD Compute DNA(CDNA)3」アーキテクチャーに基づくGPUチップレットは、「AIとHPC(高性能コンピューティング)のワークロードに特化して設計されたものだ」と述べた。

MI300Xは「GPUのみ」を搭載した製品だ。MI300Aには3基の「AMD Zen4」CPUチップレットと複数のGPUチップレットが搭載されている。しかしMI300XではCPUの代わりに2基のCDNA 3チップレットが追加搭載されている。

またMI300Xでは、トランジスター数が1460億個から1530億個に増加しており、共有DRAMの容量はMI300Aの128GBから192GBに増強されている。

さらに、メモリー帯域幅も5.2TB/秒へと引き上げられている。

Su氏は、さまざまな種類のコンピュート部品を適切なかたちで組み合わせたり、CPUやGPUを交換できる能力を有しているという点で、「この製品におけるチップレットの使用は極めて戦略的なものだ」と述べた。

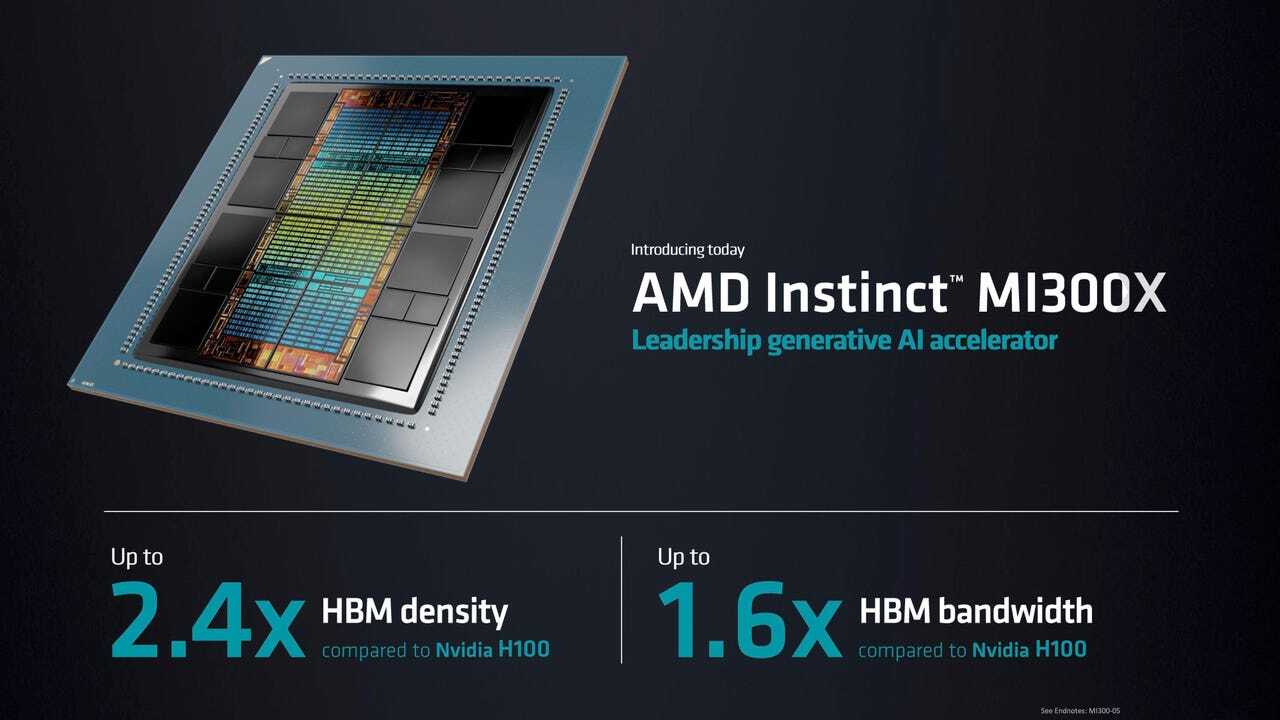

また同氏は、MI300XがNVIDIAの「Hopper」アーキテクチャーを採用した「NVIDIA H100 Tensor Core GPU」に比べ、メモリー密度が2.4倍となっており、メモリー帯域幅も1.6倍になっているとも述べた。

提供:AMD

同氏は「生成型AI、すなわちLLMによって状況は一変した」と述べ、「その用途が訓練であるか、推論であるかに関係なく、より強力なコンピュート性能を求める声が急激に増加している」と続けた。

Su氏はより強力なコンピュート性能の必要性を示すために、現時点で最も人気のあるLLMと同氏が称するオープンソースの「Falcon 40B」を用い、同チップのデモを実施した。LLMは、ニューラルネットワークの「パラメーター」と呼ばれるものの数が増加の一途をたどる中、より強力なコンピュート性能を必要とするようになる。なお、Falcon-40Bのパラメーター数は400億個だ。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。